在 AI 绘画领域,长期存在着“画质”与“速度”的博弈,以及“扩散模型”与“自回归模型”的路线之争。扩散模型(如 Stable Diffusion)画质优异但推理步骤繁琐;自回归模型(类似 LLM 生成文本)虽能与大语言模型统一架构,却受困于“逐字生成”的低效和重建质量的瓶颈。

- 项目主页:https://bitdance.csuhan.com/

- GitHub:https://github.com/shallowdream204/BitDance

- 模型:https://huggingface.co/collections/shallowdream204/bitdance

- Demo:https://huggingface.co/spaces/shallowdream204/BitDance-14B-64x

字节正式开源了 BitDance —— 一款拥有 140 亿参数 的离散自回归多模态基础模型。它通过创新的二进制 Token 机制与并行扩散预测范式,实现了惊人的生成速度:在保持高分辨率、高保真画质的同时,生成效率比传统自回归模型提升 30 倍以上,甚至超越了众多主流扩散模型。

核心突破:为什么 BitDance 这么快?

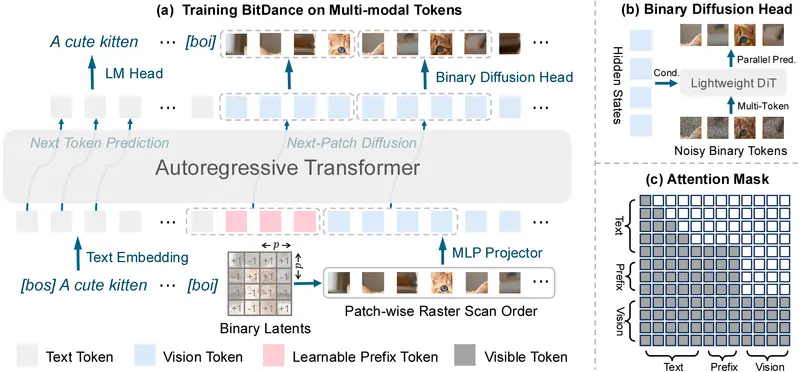

BitDance 并非简单的参数堆砌,而是在架构层面进行了三项颠覆性创新,彻底解决了自回归模型在视觉生成上的三大痛点。

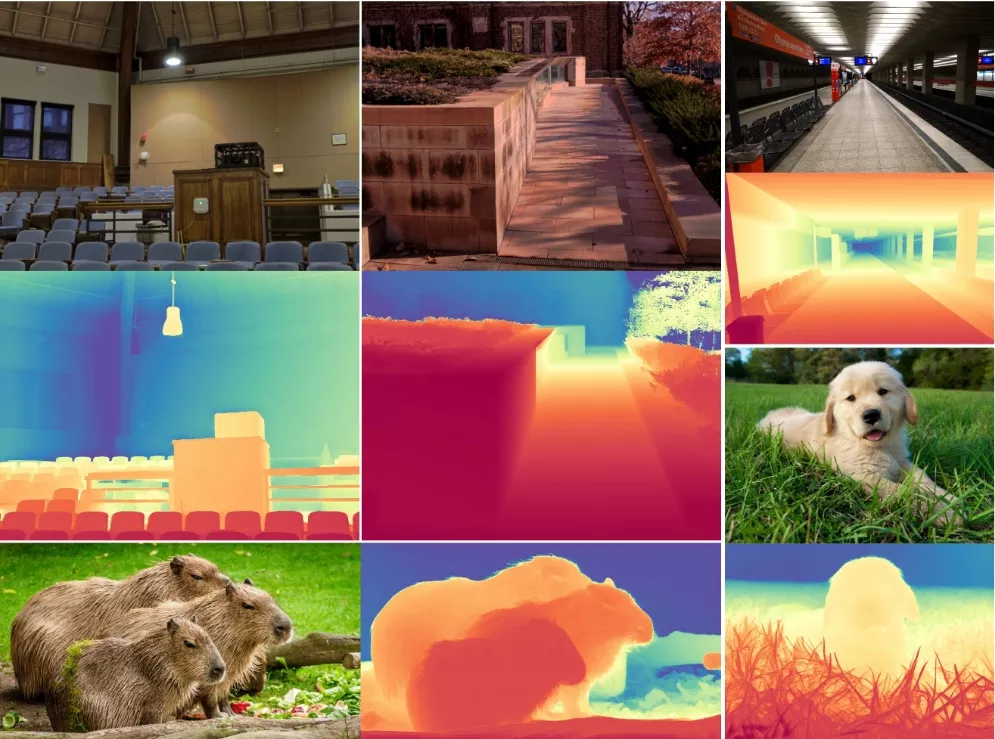

1. 超大词汇量的二进制 Token (Binary Tokenizer)

传统视觉分词器通常使用几万个离散 Token 或连续向量,前者重建质量差,后者采样困难且易累积误差。

- 创新点:BitDance 将图像映射为紧凑的 256 位二进制序列。

- 优势:其潜在状态空间高达 $2^{256}$(远超宇宙原子总数),既保留了离散 Token 的精确性,又提供了近乎无限的表达能力。这使得图像压缩更紧凑,重建画质甚至优于连续向量方案。

2. 二进制扩散头 (Binary Diffusion Head)

面对如此巨大的二进制搜索空间,传统的分类头(Classification Head)难以高效采样。

- 创新点:引入微型扩散模型作为“解码头”。它将二进制 Token 视为超立方体的顶点,在连续空间中通过去噪过程“打磨”出精准的二进制结果。

- 优势:完美解决了大词汇量下的采样难题,兼顾了生成的多样性与高质量。

3. 下一块扩散范式 (Next-Patch Diffusion)

这是速度提升的关键。传统自回归模型像打字机,一次只能预测一个 Token。

- 创新点:利用图像局部的高度相关性,BitDance 将图像分块,每一步并行预测多达 64 个 Token(即一个 Patch)。

- 优势:将串行生成转变为“块级并行”,大幅减少了推理步数。生成一张 1024px 高清图,仅需极少的步数即可完成。

主要功能与表现

BitDance 不仅快,而且“画”得好。作为一个纯粹的多模态生成模型,它具备以下核心能力:

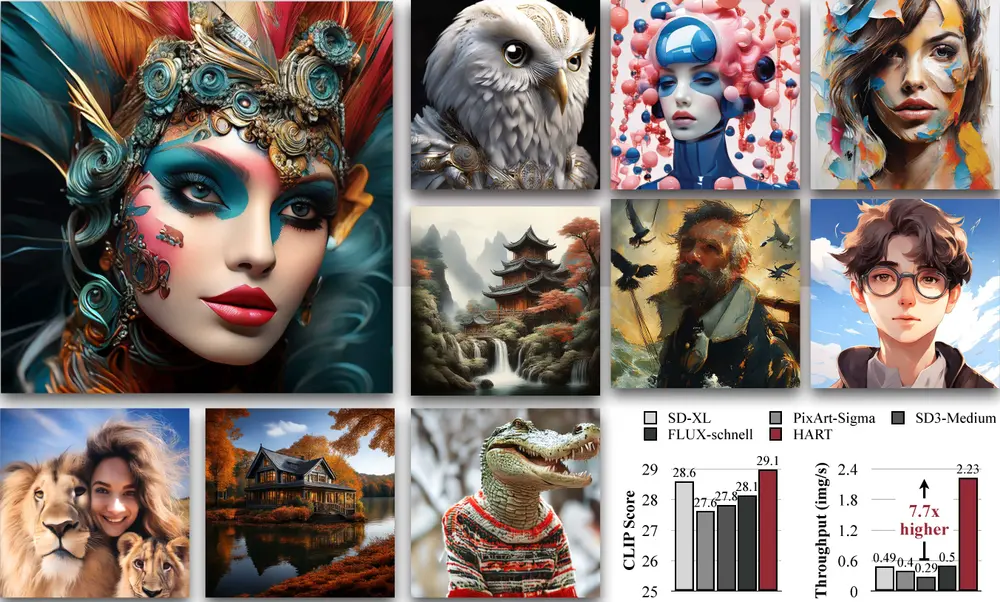

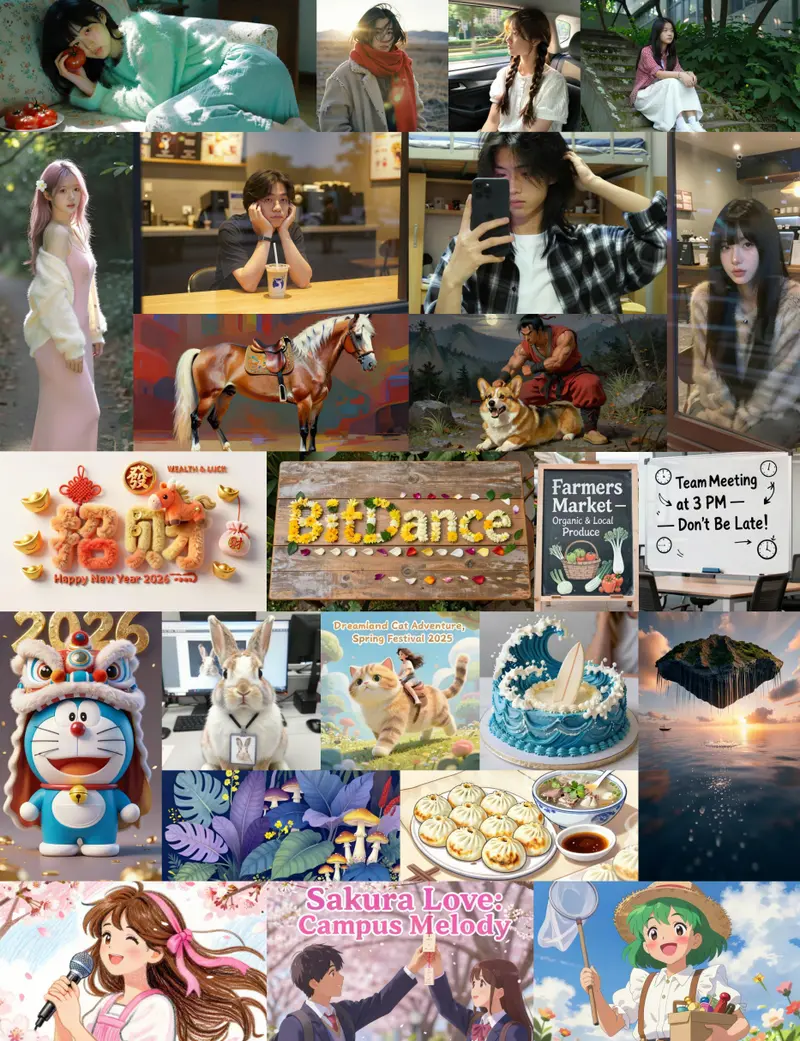

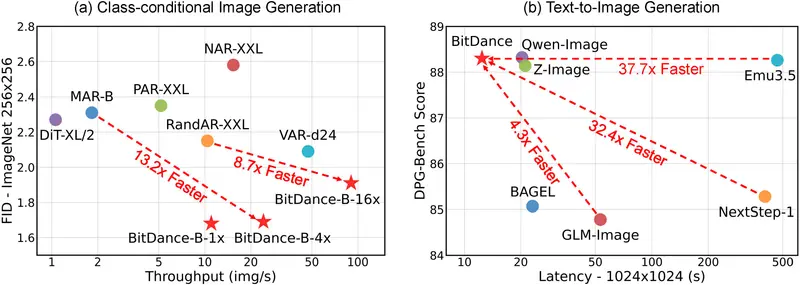

- 高质量文生图:支持写实照片、动漫、油画等多种风格。在 DPG-Bench(图文匹配度)测试中得分 88.28,位居自回归模型榜首;在 GenEval 综合测试中得分 0.86,表现优异。

- 高分辨率输出:原生支持 1024×1024 高清分辨率,细节丰富,且能准确渲染图片中的文字(如招牌、标语),解决了 AI 绘图中常见的“乱码”痛点。

- 极速推理:

- 生成一张 1024px 高清图仅需 12.4 秒。

- 对比同类竞品:NextStep-1 需 402 秒,GLM-Image 需 53.2 秒。BitDance 的速度提升高达 30 倍+。

- 多语言支持:在 OneIG 中英双语测试中,以少得多的训练数据量,达到了与商业闭源模型相当的水平,展现了极高的数据效率。

模型版本与下载

字节此次开源了两个版本的模型权重,均托管于 Hugging Face,开发者可根据需求选择:

| 模型名称 | 并行 Token 数/步 | 推理步数 | 支持分辨率 | 适用场景 |

|---|---|---|---|---|

| BitDance-14B-64x | 64 | 64 | 1024px | 极致速度:适合对延迟敏感的生产环境 |

| BitDance-14B-16x | 16 | 256 | 512 & 1024px | 灵活兼容:支持更多分辨率,显存占用略低 |

技术原理解析:它是如何“画画”的?

为了让大家更直观地理解 BitDance 的工作流,我们可以将其拆解为四个步骤:

- 编码(图像转密码):

输入图片被高压缩视觉分词器切割成小格子,每个格子被转化为一串独特的 256 位二进制“密码”。由于组合数天文数字般庞大,图像细节几乎无损保留。 - 分块规划:

模型不再是一个字一个字地写,而是将画面划分为若干“块”(Patch)。生成时,按从左到右、从上到下的顺序,一次处理一块。 - 并行扩散生成(核心):

当生成某一块时,模型启动内部的“微型扩散引擎”。它先随机生成噪声,然后通过几步快速去噪,同时确定该块内所有 64 个 Token 的值。这就像雕塑家直接从大理石中凿出一整块精细的纹理,而非一笔笔描摹。 - 解码(密码还原图):

所有块生成完毕后,二进制序列被送入解码器,瞬间还原为清晰的高清图像。

意义与展望

BitDance 的开源具有里程碑式的意义:

- 验证了自回归路线的潜力:证明了通过架构创新,自回归模型完全可以打破“慢”的魔咒,甚至在效率上反超扩散模型。

- 统一多模态的曙光:由于其纯 Decoder 架构与 LLM 高度一致,BitDance 为未来构建“既能流畅对话,又能秒级绘图”的统一大模型奠定了坚实基础。

- 开源社区的福音:字节将如此大规模(14B)且高性能的模型开源,将极大降低开发者部署高质量 AI 绘画服务的门槛,推动应用层的爆发。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...