Light AI 近日发布了 Qwen-Image-Edit-Causal V1.0,这是对 Qwen-Image-Edit-2511 的一次关键优化。新模型通过引入 分块因果注意力(block causal attention) 机制,在保持编辑质量的同时显著提升推理速度。

- GitHub:https://github.com/ModelTC/Qwen-Image-Edit-Causal

- 模型:https://huggingface.co/lightx2v/Qwen-Image-Edit-Causal

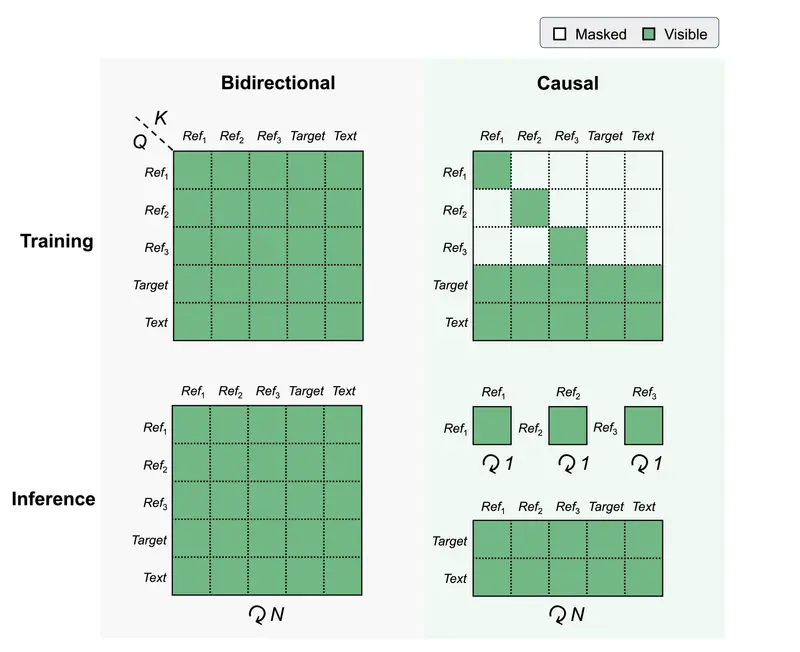

核心设计:让参考图像“专注自己”

在传统多图编辑流程中,参考图像的查询(queries)通常会与所有其他图像的键(keys)和值(values)交互,导致计算复杂度随推理步数线性增长。

Qwen-Image-Edit-Causal 改变了这一点:每个参考图像的查询仅关注其自身的键和值。这种设计带来两个关键优势:

- 减少训练时计算开销:注意力范围被严格限制,避免冗余交叉计算

- 解耦推理步骤与注意力复杂度:无论生成需要多少步(如 4 步或 50 步),参考图像的注意力计算量保持恒定,从而大幅提升推理效率

这一机制特别适合需要快速响应的本地或边缘端图像编辑场景。

快速上手

项目已开源,支持通过 uv 快速搭建环境:

git clone https://github.com/ModelTC/Qwen-Image-Edit-Causal.git

cd Qwen-Image-Edit-Causal

uv venv

uv sync

source .venv/bin/activate

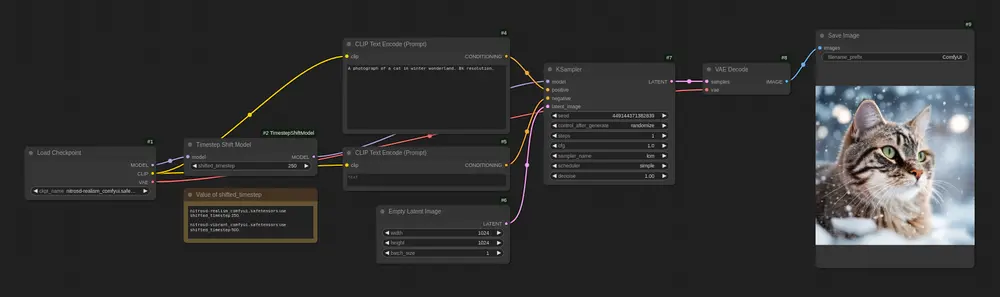

使用 Diffusers 接口运行图像编辑:

python generate_with_diffusers.py \

--model_name lightx2v/Qwen-Image-Edit-Causal \

--prompt_list_file examples/prompt_list.txt \

--image_path_list_file examples/image_path_list.txt \

--out_dir results/Qwen-Image-Edit-Causal \

--base_seed 0 --steps 4 --cfg 1.0

仅需 4 步推理 和 CFG=1.0(无分类器引导),即可完成高质量编辑,进一步体现其高效特性。

开源与合规

模型基于 Apache 2.0 许可证发布,允许商用与修改。项目明确声明:不对用户生成内容主张任何权利,但使用者需确保输出内容合法合规,不得用于传播虚假信息、侵犯隐私或伤害他人。

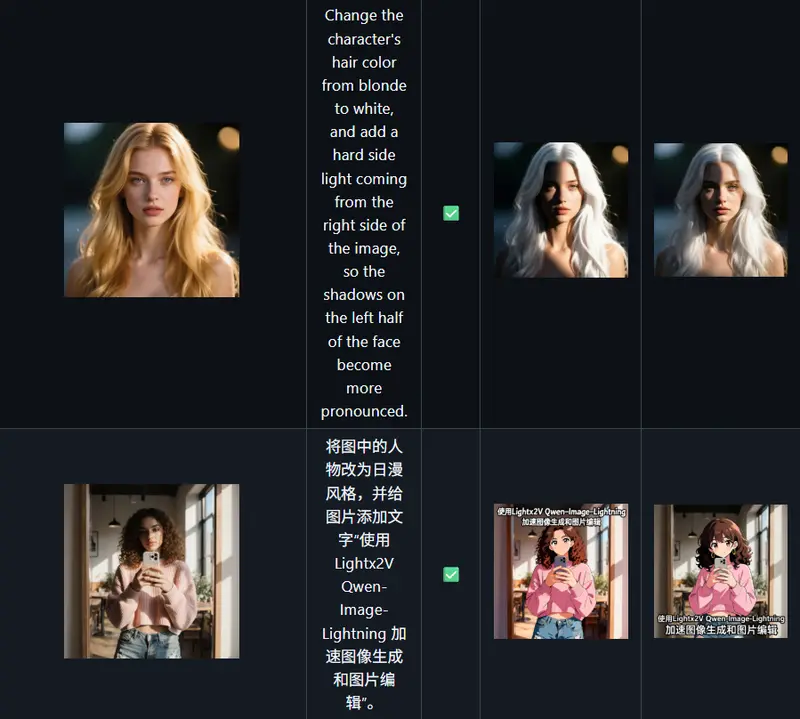

代码复用了 Qwen-Image 与 Qwen-Image-Lightning 的部分实现,测试用例来自 Qwen 官方博客、Reddit 及社区 API 调用记录,具备真实场景代表性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...