近年来,多模态大语言模型(MLLMs)在多种场景中展现了卓越的能力,但在机器人领域,尤其是在长时段复杂操作任务中,其表现仍存在显著局限性。这些局限主要源于当前 MLLMs 缺乏三种关键能力:规划能力、可供性感知和轨迹预测。为解决这一问题,智源研究院的研究团队提出了 ShareRobot 数据集 和基于此数据集开发的 RoboBrain 模型,显著提升了机器人在复杂任务中的智能水平。

- 项目主页:https://superrobobrain.github.io

- GitHub:https://github.com/FlagOpen/RoboBrain

- 模型:https://huggingface.co/BAAI/RoboBrain

核心亮点

1. 解决三大核心问题

- 规划能力:将复杂任务分解为可管理的子任务,如“抓取杯子”、“移动杯子”等。

- 可供性感知:识别物体的可操作区域(如杯子的把手),确保交互精准。

- 轨迹预测:生成完整的运动轨迹,指导机器人顺利完成任务。

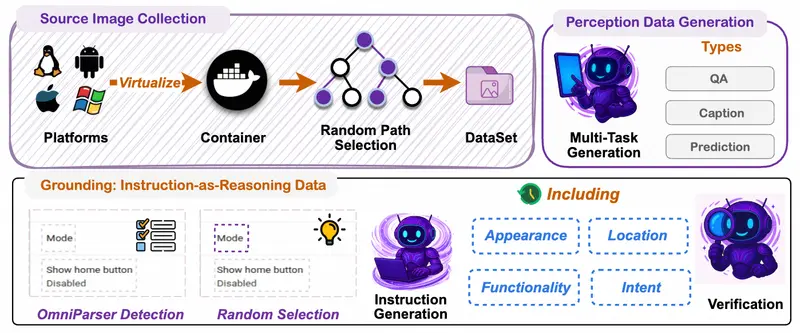

2. 高质量数据集支持

- ShareRobot 数据集:包含任务规划、物体可供性和末端执行器轨迹的多维标注信息,由三位人类标注者精心优化,确保多样性和准确性。

- 多模态数据融合:结合通用多模态数据(图像、视频)与机器人特定数据,提升模型的泛化能力。

3. 多阶段训练策略

- 基础训练:使用通用多模态数据预训练,提升模型的基础理解能力。

- 逐步增强:通过机器人特定数据和 LoRA 技术,逐步提升模型的规划、感知和执行能力。

模型架构与功能

1. 模型架构

- 基础模型:基于 LLaVA 框架,包含视觉编码器(SigLIP)、投影器和大型语言模型(Qwen2.5-7B)。

- A-LoRA 模块:用于可供性感知,通过低秩适应(LoRA)技术高效添加可操作性预测能力。

- T-LoRA 模块:用于轨迹预测,同样采用 LoRA 技术实现高效微调。

2. 主要功能

- 任务规划:将复杂指令分解为具体子任务,如“接近目标”、“抓取物品”。

- 可供性感知:识别物体的可操作区域,确保机器人能够精准交互。

- 轨迹预测:生成完整运动轨迹,指导机器人完成任务。

- 多模态理解:结合视觉输入和语言指令,生成具体的行动计划。

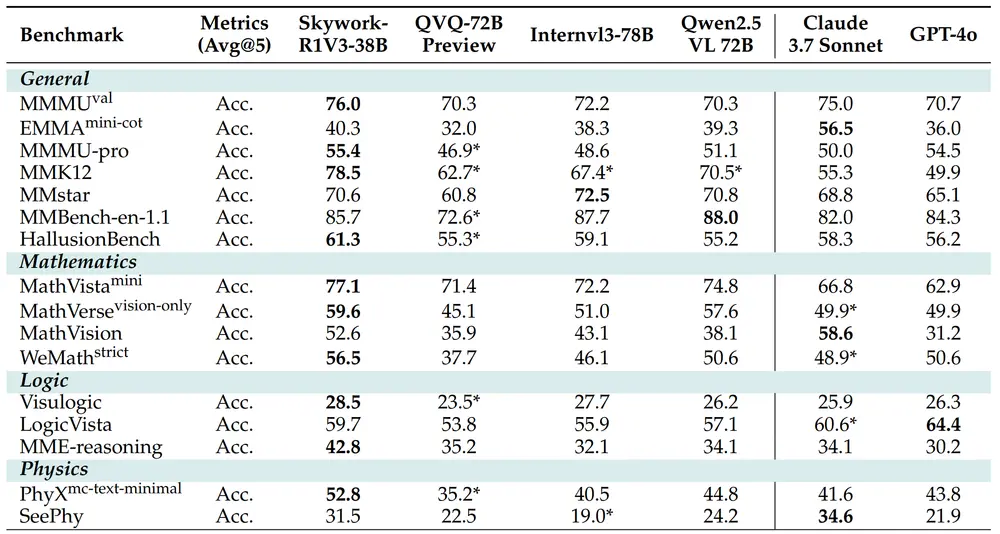

性能表现

1. 任务规划

- 在 RoboVQA、OpenEQA 和 ShareRobot 测试集上,RoboBrain 显著优于现有模型。例如,在 RoboVQA 上,RoboBrain 的 BLEU-4 分数比第二名高出 18.75。

2. 可供性预测

- 在 AGD20K 数据集上,RoboBrain 的平均精度(AP)达到 27.1%,远超其他模型(如 Qwen2-VL-7B 的 12.5% 和 LLaVA-NeXT-7B 的 9.8%)。

3. 轨迹预测

- 在多个指标上,RoboBrain 表现优异:

- 离散 Fréchet 距离降低 42.9%。

- Hausdorff 距离降低 94.2%。

- 均方根误差降低 31.6%。

应用场景

RoboBrain 的强大功能使其适用于多种机器人应用场景:

- 机器人操作:在复杂环境中执行抓取、移动、组装等任务。

- 自动化生产:提高工业生产线上的操作效率和精度。

- 服务机器人:在家庭或公共场所完成清洁、整理、烹饪等日常任务。

- 教育与研究:作为机器人学习和研究的平台,提供强大的规划和感知能力。

未来展望

RoboBrain 的成功标志着机器人领域迈出了重要一步,但仍有改进空间:

- 更自然的语音交互:引入 GPT-SoVITS 等配音技术,使语音合成更加自然流畅。

- 更复杂的任务支持:增加对多步骤、多目标任务的支持,进一步提升机器人的自主性。

- 跨平台部署:优化模型性能,适配更多硬件平台,扩大应用范围。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...