法国AI初创公司 Mistral AI 本周正式发布并开源其小型语言模型的新版本 —— Magistral Small 1.2。该模型在前代基础上全面升级,不仅提升了数学与编程任务的基准表现,还首次引入视觉编码能力,支持图文混合输入,并可在配备 32GB 内存的 MacBook 或单张 RTX 4090 上本地运行。

这一更新标志着开源轻量级多模态推理模型正逐步走向实用化。

模型定位:高效能、可本地部署的推理引擎

Magistral Small 系列的核心目标不是追求参数规模,而是打造一个适合本地运行、具备真实推理能力的小型模型。

- 参数量:240 亿(24B)

- 上下文长度:最长支持 128K tokens

- 训练方式:基于 Mistral Small 3.2 架构,结合监督微调(SFT)与强化学习(RL)优化

- 知识来源:SFT 阶段使用 Magistral Medium 模型在推理过程中生成的思维轨迹作为训练数据

这种“以强带弱”的训练策略,使小模型也能掌握复杂的多步推理模式,在回答前模拟一连串内部思考过程。

相比 1.1 版的主要升级

| 功能 | 更新说明 |

|---|---|

| ✅ 新增视觉编码器 | 支持图像输入,实现文本+图像的多模态理解与推理 |

| 📈 性能提升约 15% | 在数学和代码生成基准测试中显著优于前一版本 |

| 🧰 工具调用能力增强 | 可通过插件执行网页搜索、代码运行、图像生成等外部操作 |

| 💬 输出更自然清晰 | 回应语气更人性化,LaTeX 与 Markdown 排版更规范 |

| 🔁 减少无限生成风险 | 优化解码逻辑,降低陷入循环输出的概率 |

值得一提的是,尽管性能提升明显,但模型仍保持与前代相同的硬件兼容性要求。

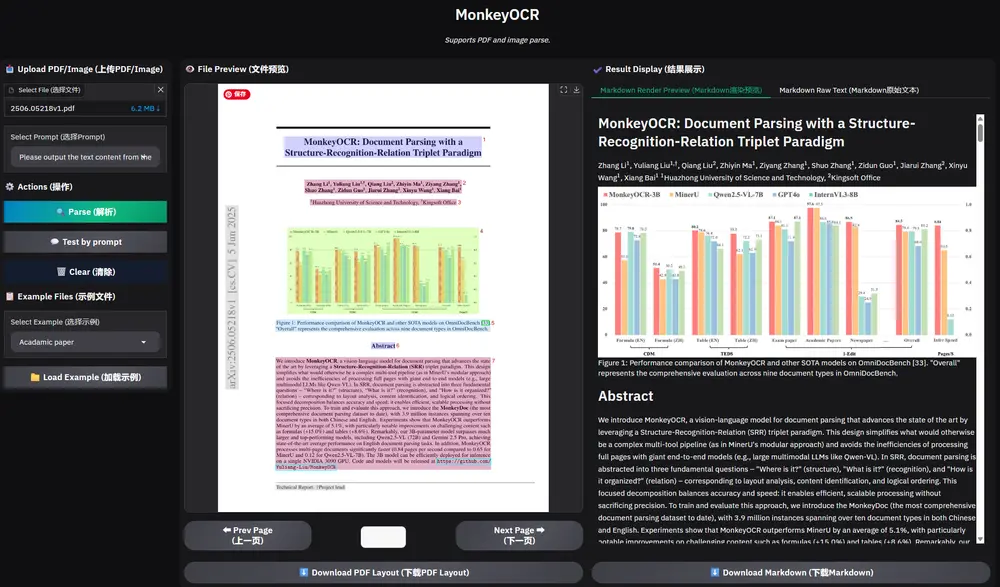

多模态能力详解:从纯文本到“看懂”图片

Magistral Small 1.2 最重要的变化是集成了视觉编码器,使其能够处理以下任务:

- 分析图表、截图或手绘草图中的信息

- 根据产品照片回答规格问题

- 解读数学题中的几何图形并进行推导

- 结合图文内容生成报告或摘要

该能力源自与 Magistral Medium 1.2 同步的技术迭代。后者也已更新至支持 128K 上下文与视觉输入,形成统一的多模态推理体系。

示例场景:上传一张电路图 + 提问“这个电路的功能是什么?”,模型可结合符号识别与电子知识进行解释。

本地部署友好:MacBook 也能跑

Mistral 强调,Magistral Small 系列专为边缘设备和开发者本地环境优化:

- 经过量化后,可在 NVIDIA RTX 4090 单卡 上流畅运行;

- 或部署于 Apple Silicon Mac(M1/M2/M3)且内存 ≥32GB 的机器上;

- 无需依赖云服务即可完成推理任务。

这对隐私敏感场景(如企业内部知识问答)、离线开发调试、教育用途等具有重要意义。

技术特性一览

🔍 推理机制改进

- 使用特殊标记

[THINK]和[/THINK]封装内部推理过程; - 便于解析思维链路,也防止用户提示中出现相同字符串时产生混淆;

- 系统提示中预设推理模板,引导模型按步骤思考。

🌍 多语言支持广泛

覆盖 20 余种语言,包括:

- 主要欧洲语言:英、法、德、西、意、葡、荷、北欧诸语

- 亚洲语言:中、日、韩、印地语、印尼语、马来语、越南语、阿拉伯语、波斯语、孟加拉语

- 斯拉夫语系:俄语、乌克兰语、塞尔维亚语、波兰语

适用于跨国团队协作或多语言内容生成。

📏 上下文窗口达 128K

- 支持超长文档处理,如整本技术手册、法律合同或小说;

- 官方提示:超过 40K 后性能可能略有下降,但仍能提供合理输出;

- 建议保持最大长度为 128K,仅在必要时主动限制。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...