来自浙江大学、微软亚洲研究院、威廉玛丽学院和清华大学的研究人员提出一种新方法DiLightNet,它用于在基于文本提示的扩散模型图像生成过程中实现精细的照明控制。

扩散模型是一种能够根据文本描述生成图像的人工智能技术,但它们在生成图像时往往无法精确控制照明效果。DiLightNet是一个强大的工具,它扩展了扩散模型的能力,使得用户能够更加自由地创作和编辑图像,特别是在照明效果方面。

主要功能:

DiLightNet的主要功能是在用户指定的照明条件下,生成与文本提示相符的图像。它允许内容创作者在图像生成过程中对照明效果进行精细调整,从而创造出更加逼真和符合预期的视觉效果。

主要特点:

- 精细照明控制:DiLightNet能够根据用户提供的照明信息(如光源位置、强度和类型)来调整图像的照明效果。

- 文本提示与照明分离:它允许用户独立控制图像内容和照明,而不是将两者捆绑在一起。

- 无需精确几何信息:DiLightNet不需要精确的物体几何形状信息,而是通过估计的深度图和前景遮罩来生成照明提示。

工作原理:

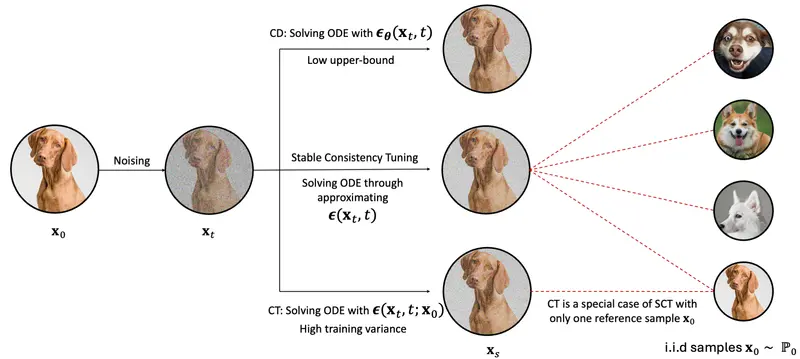

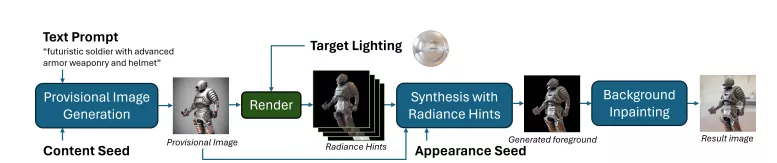

- 第一阶段:使用预训练的扩散模型在不受控制的照明条件下生成初步图像。

- 第二阶段:根据初步图像和目标照明,生成照明提示(radiance hints),并结合这些提示重新合成图像,以匹配文本提示和照明条件。这一阶段使用了名为DiLightNet的细化扩散模型。

- 第三阶段:为了与前景物体的照明保持一致,重新合成背景。

具体应用场景:

- 艺术创作:艺术家和设计师可以使用DiLightNet来创作具有特定照明效果的图像,如模拟不同时间、不同环境下的照明。

- 游戏和电影制作:在游戏开发和电影制作中,DiLightNet可以帮助创建具有逼真照明效果的场景和角色。

- 虚拟现实和增强现实:在VR和AR应用中,DiLightNet可以用来生成与现实世界照明条件相匹配的虚拟内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...