悉尼科技大学和浙江大学的研究人员推出多粒度视频编辑框架VideoGrain,通过自然语言提示实现对视频内容的精细编辑。多粒度视频编辑包括类别级(class-level)、实例级(instance-level)和部件级(part-level)的修改。VideoGrain 通过调节时空注意力机制(空间交叉注意力和自注意力),实现了对视频内容的细粒度控制,解决了现有方法在多实例编辑中的语义错位和特征耦合问题。

- 项目主页:https://knightyxp.github.io/VideoGrain_project_page

- GitHub:https://github.com/knightyxp/VideoGrain

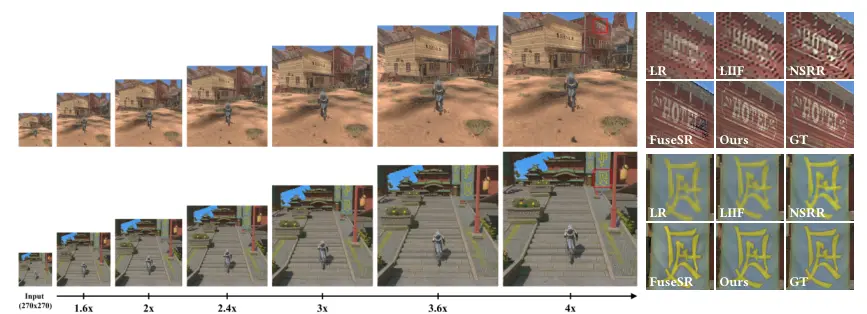

例如,用户可以通过简单的文本提示将视频中的“一个人”替换为“钢铁侠”,将“另一人”替换为“蜘蛛侠”,或者将“左猫”替换为“熊猫”,“右猫”替换为“玩具贵宾犬”,同时还可以在背景中添加新的元素(如“星空”或“日出”)。此外,VideoGrain 还支持对人物或物体的局部进行修改,例如为蜘蛛侠添加“太阳镜”或改变其服装颜色。

主要功能

- 多粒度视频编辑:支持类别级(同一类别的对象)、实例级(不同实例)和部件级(对象的局部)编辑。

- 精确的文本到区域控制:通过自然语言提示精确控制视频中的特定区域,避免语义错位。

- 特征分离:在编辑过程中保持不同区域之间的特征分离,避免特征耦合。

- 零样本(Zero-shot)编辑:无需额外训练或参数调整,直接在预训练的扩散模型基础上进行编辑。

- 高效性:在编辑速度和内存使用方面表现出色,适合实时视频编辑。

主要特点

- 时空注意力调节:

- 交叉注意力调节:增强每个局部提示对其对应空间区域的关注,同时抑制对无关区域的注意力,实现精确的文本到区域控制。

- 自注意力调节:增加区域内特征的聚焦,减少区域间特征的干扰,避免特征耦合。

- 多粒度控制:首次实现了在类别、实例和部件三个层次上的视频编辑。

- 无需额外训练:直接在预训练的扩散模型上进行编辑,无需对模型进行微调或额外训练。

- 高效性:在实验中,VideoGrain 在编辑速度和内存使用方面优于现有方法,适合实时应用。

工作原理

- 问题定义:

- 多粒度视频编辑包括三个层次:

- 类别级:修改同一类别的对象(如将所有人物替换为“钢铁侠”)。

- 实例级:对不同实例进行独立编辑(如将“左人物”替换为“钢铁侠”,“右人物”替换为“蜘蛛侠”)。

- 部件级:对对象的局部进行修改(如为人物添加“太阳镜”)。

- 多粒度视频编辑包括三个层次:

- 时空注意力调节:

- 交叉注意力调节:通过增强局部提示对其对应区域的关注,减少对无关区域的注意力,实现精确的文本到区域控制。

- 自注意力调节:通过增加区域内特征的聚焦,减少区域间特征的干扰,避免特征耦合。

- 整体框架:

- 使用预训练的扩散模型(如 Stable Diffusion)作为基础模型。

- 在 DDIM 反演过程中获取视频的噪声潜码。

- 使用 SAM-Track 或自注意力特征聚类获取语义布局。

- 在去噪过程中引入 ST-Layout Attn 模块,调节交叉注意力和自注意力。

- 实验验证:

- 通过大量实验验证了 VideoGrain 在多粒度视频编辑中的性能,包括类别级、实例级和部件级编辑。

- 与现有方法(如 Ground-A-Video、TokenFlow、ControlVideo 等)相比,VideoGrain 在编辑精度、特征分离和时间一致性方面表现出色。

应用场景

- 影视制作:在电影或电视剧后期制作中,快速替换场景中的角色或物体,同时保持背景和时间一致性。

- 广告制作:为广告视频添加或修改品牌元素,如将人物替换为品牌代言人,或在背景中添加品牌标志。

- 视频游戏开发:在游戏视频预告片中快速替换角色或场景元素,以适应不同的游戏版本或宣传需求。

- 社交媒体内容创作:为 TikTok 或抖音视频添加创意效果,如替换人物服装、添加虚拟道具或修改背景。

- 虚拟会议:在虚拟会议中实时替换背景或修改人物形象,提升用户体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...