近年来,3D生成模型在图像和视频领域取得了显著进展,但它们通常依赖于有限规模的3D“黄金标签”或2D扩散先验来进行3D内容创作。这种依赖性限制了模型的性能,因为现有的3D数据集规模较小且标注成本高昂,难以扩展到更广泛的场景。此外,传统的3D生成模型往往缺乏对开放世界中复杂多样场景的理解能力。

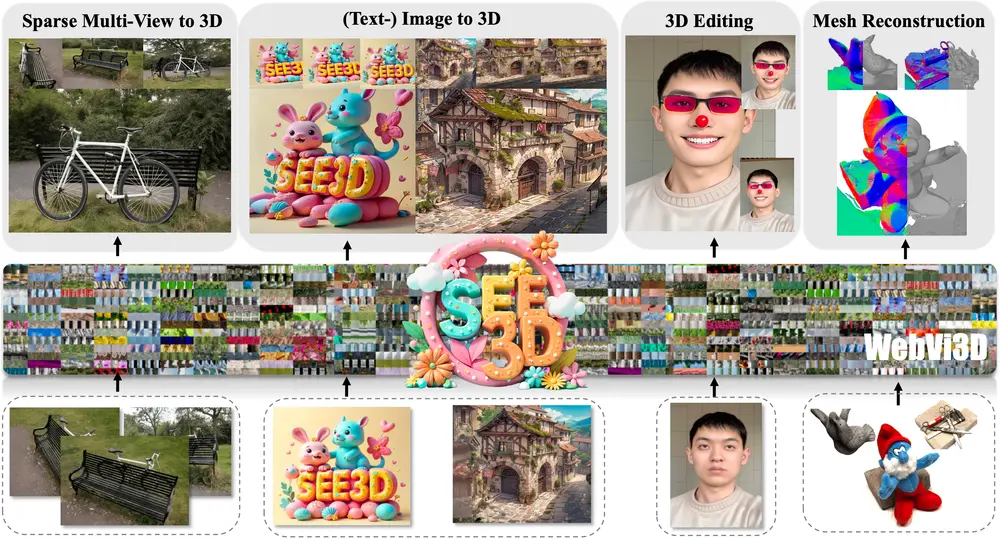

为了解决这些问题,北京人工智能研究院提出了 See3D,一个视觉条件的多视图扩散模型,旨在通过大规模互联网视频数据进行训练,从而实现开放世界的3D创作。See3D 的核心理念是“你看到它,你就得到了它”,即通过观看大量视频中的视觉内容,模型能够自动学习3D知识,而无需依赖显式的3D几何或相机姿态标注。

例如,你给See3D模型提供一系列从不同角度拍摄的同一场景的视频片段,它能够学习场景的3D结构,并从新的视角生成该场景的图像。这就像你通过观察一个房间的多个照片来想象房间的布局一样,See3D能够自动完成这个过程,并创造出新的视角图像。

核心技术与创新点

1. 大规模多视图图像数据集 WebVi3D

为了训练 See3D,研究人员首先构建了一个高质量、丰富多样的大规模多视图图像数据集 WebVi3D。该数据集包含来自1600万视频剪辑的3.2亿帧,涵盖了各种场景和视角。为了确保数据的质量和多样性,研究人员设计了一个自动化的数据整理管道,该管道能够:

- 过滤多视图不一致:自动识别并去除那些在不同视角下存在明显不一致的视频片段。

- 处理观察不足的情况:确保每个场景都有足够的视角覆盖,避免因视角过少而导致的3D重建失败。

通过这种方式,WebVi3D 成为了一个高质量、大规模的多视图图像数据集,为 See3D 的训练提供了坚实的基础。

2. 消除对姿态条件的需求

传统3D生成模型通常需要依赖显式的相机姿态标注来指导3D重建过程,但这在大规模互联网视频数据中是不可行的,因为标注这些信息的成本过高。为了解决这一问题,See3D 引入了一种创新的 视觉条件——一种纯2D归纳的视觉信号。具体来说,研究人员通过以下步骤生成这种视觉条件:

- 掩码视频数据:对输入的视频帧进行掩码处理,随机遮挡部分区域。

- 添加时间相关噪声:向掩码后的视频数据添加时间相关噪声,模拟不同视角下的视觉变化。

这种视觉条件能够在没有显式3D几何或相机姿态标注的情况下,提供丰富的时空信息,帮助模型学习3D结构。通过这种方式,See3D 消除了对姿态条件的依赖,使得模型可以在大规模未标注的视频数据上进行训练。

3. 基于扭曲的视觉条件3D生成框架

为了进一步提升生成质量,研究人员将 See3D 集成到一个基于扭曲(warping)的管道中,提出了一种新的 视觉条件3D生成框架。该框架的核心思想是通过视觉条件引导3D生成过程,确保生成的3D内容在不同视角下保持一致性和连贯性。具体来说,该框架包括以下几个关键步骤:

- 多视图一致性约束:通过视觉条件,模型能够在不同视角下生成一致的3D内容,避免出现视角切换时的不连续性。

- 高保真3D生成:通过结合视觉条件和扩散模型的强大生成能力,See3D 能够生成高质量、逼真的3D内容,适用于单视图和稀疏重建任务。

实验结果与性能评估

研究人员在多个基准上对 See3D 进行了评估,实验结果表明:

- 零样本生成能力:See3D 在从未见过的场景中表现出色,能够生成高质量的3D内容,展示了其强大的零样本生成能力。

- 开放世界生成能力:See3D 在开放世界场景中表现优异,能够处理复杂的多视图数据,生成逼真的3D内容。

- 成本效益高:与依赖昂贵3D数据集的传统模型相比,See3D 仅使用大规模互联网视频数据进行训练,具有更高的成本效益和可扩展性。

相关文章