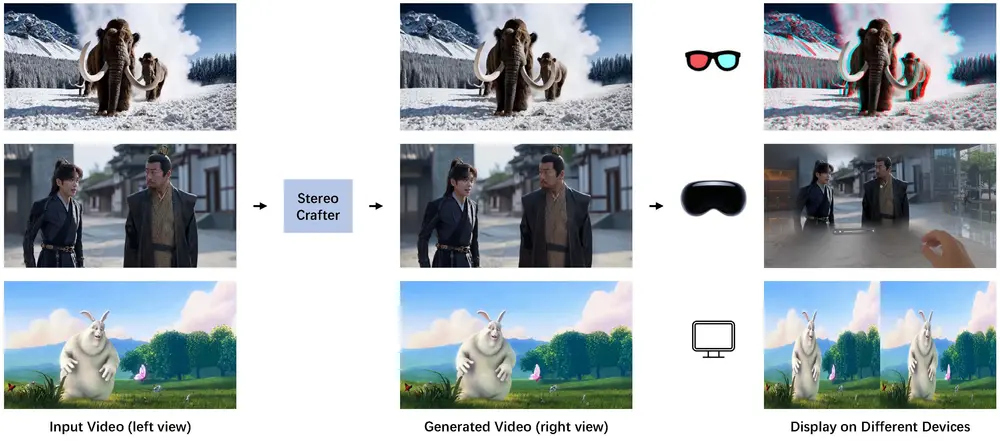

腾讯AI实验室和腾讯PCG ARC Lab的研究人员推出StereoCrafter框架,用于将单目视频转换为沉浸式立体 3D 视频,以满足人们对沉浸式数字体验的需求。该框架主要解决了传统 2D-to-3D 视频转换方法中存在的深度估计不准确、生成结果模糊以及处理复杂动态场景困难等问题,通过利用基础模型作为先验知识,结合深度估计、视频拼接和立体视频修复技术,实现了高质量、高保真的立体 3D 视频生成。例如,你有一段普通的2D电影片段,使用StereoCrafter框架后,你可以将这段影片转换成3D版本,让观众通过3D眼镜或专用的3D显示器体验到更加立体和沉浸式的电影效果。

- 项目主页:https://stereocrafter.github.io

- GitHub:https://github.com/TencentARC/StereoCrafter

- 模型:https://huggingface.co/TencentARC/StereoCrafter

主要功能

- 2D-to-3D 视频转换:能够将各种类型的单目视频(如电影、视频博客、3D 卡通和 AIGC 视频等)转换为立体 3D 视频,使观众可以通过 3D 眼镜、Apple Vision Pro 等设备获得沉浸式的观看体验。例如,将普通的 2D 电影转换为 3D 版本,增强观众的立体感和沉浸感。

- 高质量视频生成:利用预训练的稳定视频扩散模型(Stable Video Diffusion)作为骨干网络,并通过精心设计的数据处理管道和微调协议,确保生成的立体 3D 视频具有高质量、高保真的特点,包括清晰的图像细节、准确的深度感知和自然的视觉效果。

主要特点

工作原理

- 深度估计与视频拼接:首先使用深度估计模型(如 DepthCrafter 或 Depth Anything V2)对输入的单目视频进行深度估计,得到深度图。然后,根据深度图计算视差,利用提出的前向拼接方法将左视图视频扭曲为右视图视频,并在这个过程中生成遮挡掩码。前向拼接方法通过将源图像中的每个像素映射到目标图像的相应位置,并根据视差计算权重进行像素融合,解决了多个像素映射到同一目标像素时的模糊问题。

- 立体视频修复:以扭曲后的视频和遮挡掩码为输入,通过扩展的稳定视频扩散模型进行立体视频修复。在训练过程中,随机采样部分输入帧并用真实帧替换,使用标准扩散损失进行训练。在推理过程中,采用自回归建模,将上一轮生成的最后若干帧与当前轮的输入帧连接作为下一轮的输入,以保持时间上的一致性。对于高分辨率视频,采用分块扩散策略,将视频在空间维度上分成块,分别进行推理,然后在潜在空间中融合相邻块的重叠区域,最后通过 VAE 解码得到修复后的高分辨率视频。

- 数据集构建:为了支持模型训练,构建了一个包含约 180k 训练序列样本和约 2500 万帧的大规模数据集。数据处理管道包括收集各种类型的立体视频,使用 PySceneDetect 工具进行镜头检测,应用立体匹配方法预测视差图,通过视差处理步骤对齐视差分布,使用深度基于的视频拼接方法生成扭曲视频和遮挡掩码,并根据 PSNR 过滤数据以排除立体匹配误差较大的样本。

具体应用场景

- 影视娱乐产业:将传统的 2D 电影、电视剧等视频内容转换为立体 3D 版本,提升观众的观看体验,为影视制作公司提供一种新的内容创作和增值方式。例如,将经典电影重新制作成 3D 版本,在影院或家庭 3D 设备上播放,吸引更多观众。

- 虚拟现实(VR)和增强现实(AR)体验:为 VR 和 AR 应用提供高质量的立体 3D 视频内容,增强用户在虚拟环境中的沉浸感和真实感。比如,在 VR 游戏中使用生成的立体 3D 视频作为背景或交互元素,或者在 AR 应用中展示 3D 产品演示、虚拟展览等。

- 视频分享平台:用户可以将自己拍摄的单目视频转换为立体 3D 视频后分享在平台上,增加视频的趣味性和吸引力,提升平台的用户活跃度和内容多样性。例如,在社交媒体平台上分享 3D 旅行视频、3D vlog 等,让观众有身临其境的感觉。

- 教育与培训领域:在教育视频、培训教程等中应用立体 3D 视频,帮助学生或学员更好地理解和掌握知识。例如,通过立体 3D 视频展示复杂的科学实验、工程结构或历史场景,提高学习效果。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...