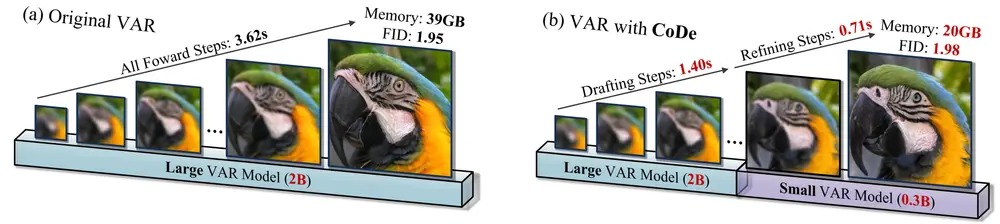

新加坡国立大学的研究人员推出一个名为“Collaborative Decoding(CoDe)”的新方法,旨在提高视觉自回归(Visual Auto-Regressive,简称VAR)模型在图像生成任务中的效率。VAR模型因其在效率、可扩展性和零样本泛化方面的显著改进而受到关注,但其固有的粗到细(coarse-to-fine)生成特性导致了漫长的令牌序列,从而引起内存消耗大和计算冗余。CoDe通过在大型和小型VAR模型之间分配解码任务,显著提高了推理效率,同时保持了与原始模型相当的图像质量。

- 项目主页:https://czg1225.github.io/CoDe_page

- GitHub:https://github.com/czg1225/CoDe

- 模型:https://huggingface.co/Zigeng/VAR_CoDe

例如,你想要生成一系列不同风格的图像,比如各种动物的图片,使用CoDe方法,你可以快速地在不同的尺度上生成这些图像,同时保持每个动物的特征和细节。例如,你可以在一个较小的尺度上生成一个大致的动物轮廓,然后在更大的尺度上细化这些图像,添加纹理和颜色等高频细节。

主要功能和特点

- 提高效率:CoDe通过在大型“起草者”模型和小型号“细化者”模型之间分配任务,减少了推理步骤,提高了图像生成的速度。

- 内存优化:通过在生成过程中适时释放大型模型的键值(KV)缓存,显著减少了内存使用。

- 保持图像质量:尽管推理速度提升,CoDe生成的图像在质量上与原始VAR模型相当,FID(Fréchet Inception Distance)仅略有增加。

- 零样本泛化:CoDe能够在没有额外训练的情况下,对新的图像类别进行泛化。

工作原理

CoDe的工作原理基于两个关键观察:

- 参数需求减少:在更大的尺度上,生成高质量令牌所需的参数显著减少,导致在长序列中的大部分令牌存在计算冗余。

- 不同尺度的生成模式独有:小尺度和大尺度的生成模式是互斥的,导致在学习低频和高频建模能力时相互干扰,从而阻碍了参数的有效利用。

基于这些观察,CoDe将多尺度推理过程分解为两个模型的无缝协作:

- 起草者模型(大型VAR模型):负责在较小尺度上生成低频内容,为图像提供大致结构。

- 细化者模型(小型VAR模型):专注于在较大尺度上预测高频细节,对图像进行细化。

此外,CoDe还采用了专门的微调策略,使两个模型在它们处理的特定尺度上进行优化,从而减少训练干扰,提高参数利用效率。

具体应用场景

- 图像生成:在需要快速生成高质量图像的应用中,如在线广告、游戏纹理生成等。

- 风格迁移:在艺术创作中,将一种风格快速应用到不同的图像上。

- 数据增强:在机器学习训练中,快速生成额外的训练数据以提高模型的泛化能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...