罗切斯特大学、普渡大学、延世大学、腾讯 AI 实验室和华盛顿大学的研究人员推出半策略偏好优化方法SePPO,用于优化和微调扩散模型(如用于生成图像的模型),使其更好地符合人类的审美和偏好,而无需依赖外部奖励模型或成对的人工注释数据。例如,你是一名设计师,需要根据客户的描述“一座山顶上的美丽房子,周围环绕着鲜艳的花朵和高大树”来生成一张图像。使用SePPO,模型能够根据这个描述生成一张图像,并在迭代过程中不断优化,直到生成的图像符合客户的偏好,而无需客户提供任何成对的示例或额外的奖励信号。

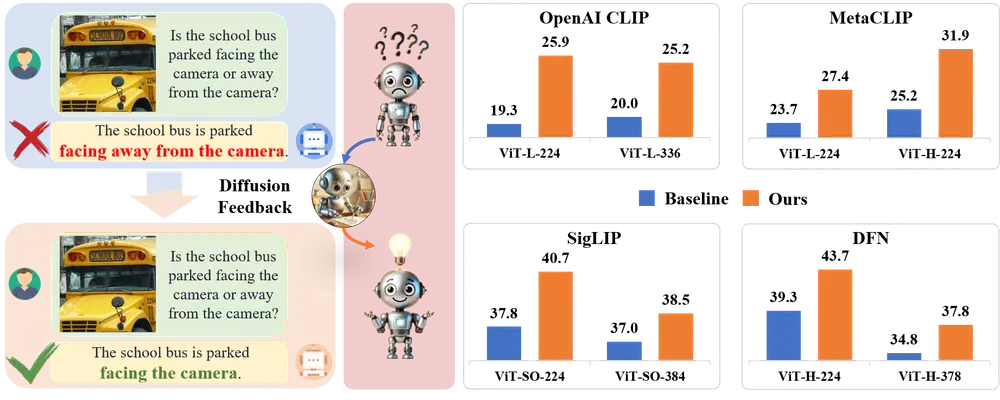

SePPO 利用之前的模型作为参考模型,同时使用它们生成在线参考样本,这些样本取代了偏好对中的“失败图像”。这种方法使研究团队能够仅使用离线“获胜图像”进行优化。此外,研究团队设计了一种参考模型选择策略,扩展了策略空间中的探索。值得注意的是,研究团队不仅仅将参考样本视为学习的负面示例。相反,研究团队设计了一个基于锚点的标准来评估参考样本是否可能是“获胜”或“失败”图像,从而使模型能够有选择地从生成的参考样本中学习。这种方法减轻了由于参考样本质量的不确定性导致的性能下降。

主要功能

- 偏好优化:调整模型生成的图像,使其更符合人类的选择偏好。

- 无需奖励模型:不依赖于传统的奖励模型来指导图像生成。

- 无需成对数据:不需要人工标注的成对比较数据来训练模型。

主要特点

- 半策略偏好优化:使用先前的训练检查点作为参考模型,生成策略内参考样本。

- 参考模型选择策略:设计了一种策略来选择参考模型,以扩大策略空间的探索。

- 基于锚点的自适应翻转器:评估参考样本相对于当前模型的胜负可能性,并据此调整学习过程。

工作原理

- 迭代优化:通过迭代的方式,逐步优化模型的输出,使其更符合人类的选择偏好。

- 选择参考模型:从所有先前的检查点中随机选择一个作为参考模型,生成参考样本。

- 基于锚点的评估:通过比较参考样本和当前模型生成的样本,决定是否接受参考样本作为学习材料。

具体应用场景

- 文本到图像的生成:根据文本描述生成图像,如根据“一只穿着西装的粉红色吉娃娃”生成相应的图像。

- 文本到视频的生成:根据文本描述生成视频,如生成描述“从夜晚到黎明的宁静风景”的时间流逝视频。

总的来说,SePPO提供了一种有效的方法来微调生成模型,使其输出更符合人类的偏好,同时减少了对大量人工注释数据的依赖。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...