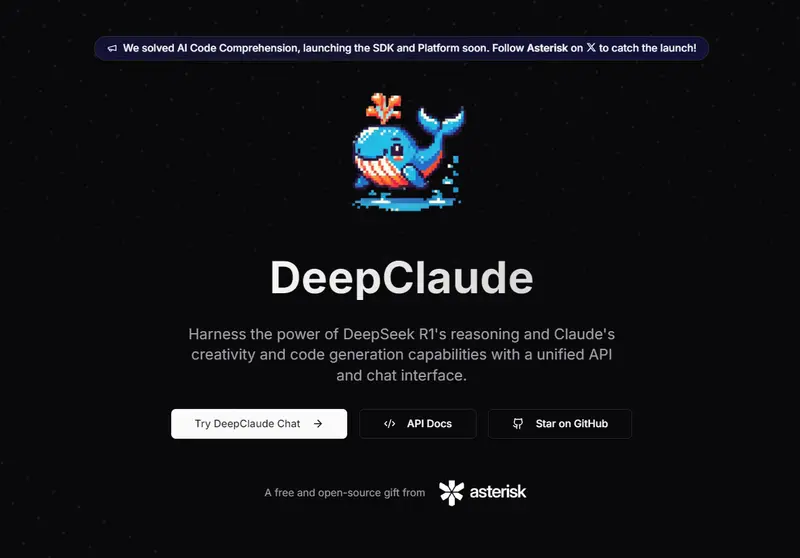

在大语言模型(LLM)的应用中,如何高效地结合不同模型的优势,一直是开发者和用户关注的焦点。今天,我们来介绍一个高性能的 LLM 推理 API——DeepClaude,它通过整合 DeepSeek R1 和 Anthropic Claude 的能力,为用户提供了强大的推理和创作支持。

什么是 DeepClaude?

DeepClaude 是一款开源的高性能 LLM 推理 API,它将 DeepSeek R1 的思维链(CoT)推理能力与 Anthropic Claude 的创造力和代码生成能力相结合,提供了一个统一的接口。用户可以在单个 API 调用中,同时享受两种模型的优势,同时还能完全控制自己的 API 密钥和数据。

DeepClaude 的核心在于将 DeepSeek R1 的深度推理能力与 Claude 3.5 Sonnet 的创造力和对话能力相结合。这种组合在代码生成、严肃文本输出和策划等任务中表现优异,被认为是目前阶段最佳的模型组合方式。

DeepClaude 的功能亮点

- 零延迟响应:借助高性能 Rust API,DeepClaude 能够在单个流中快速传输 R1 的 CoT 推理结果和 Claude 的响应,实现即时反馈。

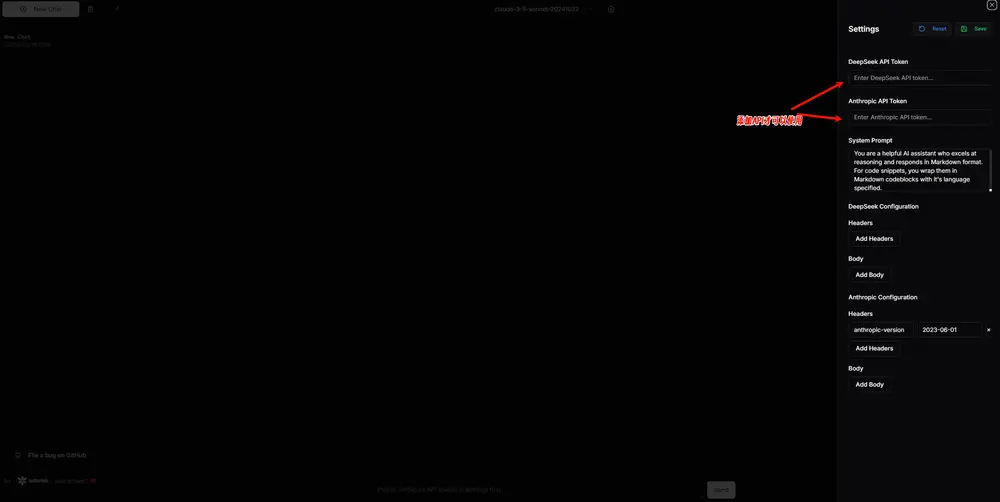

- 私密且安全:通过本地 API 密钥管理,DeepClaude 实现了端到端的安全性,确保用户数据的隐私。

- 高度可配置:用户可以根据自身需求,自定义 API 和界面的各个方面。

- 开源免费:DeepClaude 是一个完全开源的项目,用户可以自由贡献代码、修改和部署。

- 双重 AI 动力:结合了 DeepSeek R1 的推理能力和 Claude 的创造力与代码生成能力。

- 托管 BYOK API:用户可以使用自己的 API 密钥,通过托管基础设施实现完全控制。

为什么选择 R1 + Claude?

DeepSeek R1 的 CoT 推理能力非常强大,它能够进行深度推理,甚至达到“元认知”的水平——自我纠正、思考边缘情况,并以自然语言执行准蒙特卡罗树搜索。然而,R1 在代码生成、创造力和对话技巧方面稍显不足。而 Claude 3.5 Sonnet 正好在这些方面表现出色,两者结合堪称完美。

通过 DeepClaude,用户可以同时享受:

- R1 出色的推理和问题解决能力;

- Claude 卓越的代码生成和创造力;

- 在单个 API 调用中快速流式传输响应;

- 使用自己的 API 密钥,实现完全控制。

项目背景

最初,DeepClaude 由 Asterisk 团队发布,他们开源了项目代码,并上线了一个前端网站供用户体。然而,该项目并未完全遵循 OpenAI API 的兼容模式,这限制了其在开源大语言模型聊天客户端中的应用。

为了解决这一问题,开发者 Erlich 对该项目进行了 fork 和改造,完全用 Python 重写了一套支持 OpenAI 兼容模式的代码,同样命名为 DeepClaude,并将其开源:

经过改造后,用户可以轻松将 DeepClaude 集成到各种开源大语言模型聊天客户端中,例如 LobeChat、NextChat、Cherry Studio 和 Chatbox 等。此外,还可以搭配向量嵌入模型,进一步提升知识库检索(RAG)功能。

如何使用

方案一:自己部署

你可以访问 Erlich 的 DeepClaude 开源项目,按照文档说明进行本地或云端部署。部署完成后,你可以在任何支持 OpenAI API 的聊天客户端中使用 DeepClaude。需要注意的是,自行部署需要承担 DeepSeek R1 和 Claude 3.5 Sonnet 的 API 成本。

方案二:使用开发者提供的 API

如果你不想自己部署,可以直接购买 Erlich 提供的 DeepClaude API。购买后,你将获得详细的使用教程,支持 DeepClaude API、gpt-4o、gpt-4o-mini、Claude 3.5 Sonnet 以及 text-embedding-3-small 模型。

数据统计

相关导航

LiveKit Agents

LemonAI

OpenRouter

DeepSeek

OpenClaw汉化发行版

Chai.new

Poe