AI21 Labs 由 AI 领域的先驱于 2017 年创立,创始团队包括 Amnon Shashua 教授(Mobileye 创始人兼 CEO)、Yoav Shoham 教授(斯坦福大学名誉教授、谷歌前首席科学家)和 Ori Goshen(连续创业者、CrowdX 创始人)。他们的目标是构建能够成为人类思维伙伴的 AI 系统。

Jamba:开创性混合架构的生产级模型

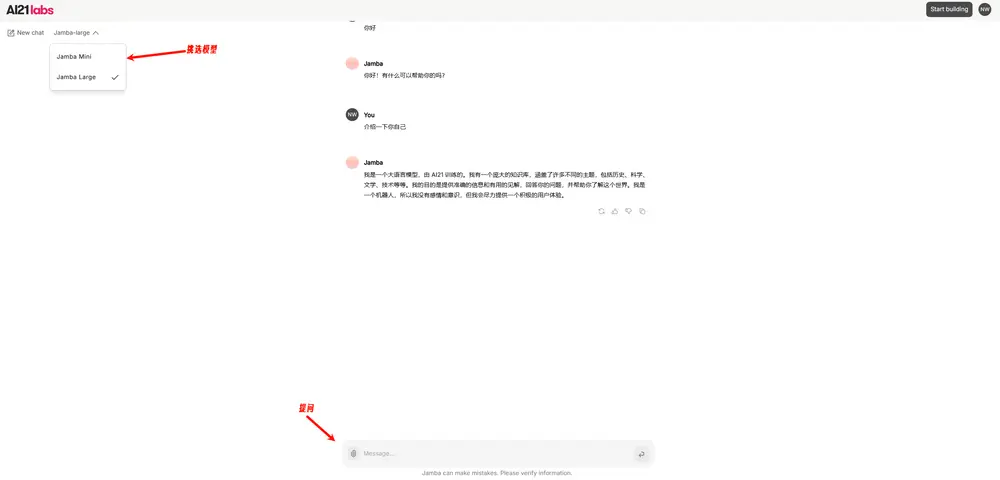

AI21 Labs 正式推出 Jamba,这是世界上第一个基于 Mamba 的生产级模型。Jamba 通过融合 Transformer 和 Mamba 架构的优势,实现了精度和速度的完美平衡,专为应对最严峻的挑战而设计,如分布式计算和无缝部署。

Jamba 将 Mamba 结构化状态空间模型(SSM)技术与传统 Transformer 架构相结合,弥补了纯 SSM 模型的固有局限性。它提供 256K 的上下文窗口,在吞吐量和效率方面展现出显著优势。目前,官方已开源 Jamba 1.6 和 Jamba 1.5 两个系列,分别包含 Large 和 Mini 两款模型。

Jamba 的创新架构

Jamba 的发布标志着大型语言模型(LLM)创新的两个重要里程碑:成功将 Mamba 与 Transformer 架构结合,并将混合 SSM-Transformer 模型推进到生产级规模和质量。

传统 Transformer 架构虽然强大,但存在两个主要缺点:

- 内存占用大:Transformer 的内存占用随上下文长度增加而增加,这使得在没有大量硬件资源的情况下运行长上下文窗口或大量并行批次变得困难,限制了广泛的实验和部署机会。

- 上下文增长时推理速度慢:Transformer 的注意力机制随序列长度呈二次方增长,降低吞吐量,因为每个 token 都依赖于之前的整个序列,这使得长上下文用例难以高效生产。

Mamba 架构由卡内基梅隆大学和普林斯顿大学的研究人员提出,解决了上述缺点,为语言模型开发开辟了新的可能性。然而,由于缺乏对整个上下文的注意力,这种架构难以匹配现有最佳模型的输出质量,尤其是在与召回相关的任务上。

为了结合 Mamba 和 Transformer 架构的优势,AI21 Labs 开发了 联合注意力与 Mamba(Jamba) 架构。Jamba 由 Transformer、Mamba 和专家混合(MoE)层组成,同时优化了内存、吞吐量和性能。

- MoE 层:Jamba 的 MoE 层使其在推理时仅使用 520 亿参数中的 120 亿,而其混合结构使这 120 亿活跃参数比同等规模的纯 Transformer 模型更高效。

- 生产级规模:虽然有些人尝试扩展 Mamba,但没有人将其扩展到超过 30 亿参数。Jamba 是首个达到生产级规模的此类混合架构。

Jamba 的优势

- 无与伦比的长上下文性能:Jamba 提供 256K 的上下文窗口,在 RAG(检索增强生成)和长上下文问答任务中表现出色。

- 领先的开源模型质量:Jamba Large 和 Jamba Mini 在质量上优于同类模型,与领先的闭源模型相媲美。

- 灵活的部署选项:支持从 AI21 Studio 使用、Hugging Face 下载以及私有化部署(本地或 VPC 内)。

相关:

数据统计

相关导航

LongCat(龙猫)

Fastino

新QClaw

Agency Agents

Chai.new

Agent S

Craft-Agent