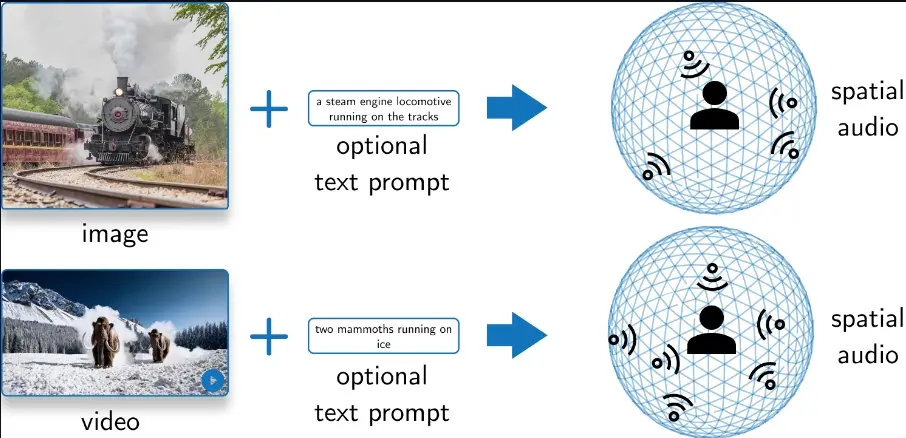

多伦多大学、Temerty 人工智能研究与医学教育中心和Sunnybrook 研究所的研究人员推出创新系统SEE-2-SOUND,它能够将视觉内容(如图片或视频)转换成具有空间感的音频输出。简单来说,这个系统可以为静态图片或动态视频生成与之匹配的立体声效果,增强观众的沉浸感和体验。SEE-2-SOUND的一些局限性,包括对图像细节的检测可能不够精确,以及目前还无法实现实时处理。此外,作者也对深度伪造技术的潜在滥用表示了担忧,并希望能够在未来研究中加入相应的防护措施。

例如,你正在观看一段关于蒸汽火车的视频,SEE-2-SOUND系统可以生成火车鸣笛声和轮子滚动声的空间音频,让你感觉就像火车真的在你的周围移动一样。或者,如果你在玩一个视频游戏,系统可以为游戏中的不同物体和事件生成空间音频,让你能够通过声音判断敌人的位置或了解周围环境。

主要功能:

- 空间音频生成:SEE-2-SOUND能够识别图片或视频中的视觉元素,并将它们转换成具有空间位置感的音频信号。

主要特点:

- 零样本学习(Zero-Shot):系统不需要针对特定任务的训练,能够直接应用到新的场景中。

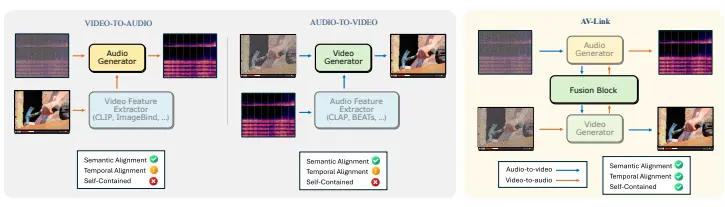

- 组合性方法:通过组合现有的模型来分别处理图像分割、深度估计、音频生成和空间音频合成。

- 易于使用和扩展:由于其组合性质,可以轻松替换或修改系统中的任何单独模块。

工作原理:

- 识别兴趣区域:系统首先识别输入图片或视频中的感兴趣区域(ROIs)。

- 3D定位:然后,系统估算这些视觉元素在三维空间中的位置。

- 单声道音频生成:对于每个视觉元素,系统生成相应的单声道音频。

- 空间音频合成:最后,系统将这些单声道音频根据它们在三维空间中的位置合成为立体声音频。

具体应用场景:

- 虚拟现实和增强现实:为VR和AR应用生成逼真的音频,提升沉浸式体验。

- 视频游戏:为游戏中的场景生成空间音频,使玩家能够根据声音判断物体的方向和距离。

- 电影和视频制作:自动化音频设计过程,为视频内容快速生成空间音频效果。

- 辅助技术:为视觉障碍人士提供音频描述,增加对视觉内容的可访问性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...