来自北京大学人工智能研究院、BIGAI通用人工智能国家重点实验室、北京大学CFCS计算机学院和北京理工大学的研究团队创建一个详细的人类与场景互动数据集trumans,并开发出一种先进的动作生成模型,为虚拟环境中的人类行为模拟提供了强大的工具。

想象一下,你在玩一个虚拟现实游戏,游戏中的人物不仅能够自然地在房间内行走,还能与房间里的物品如椅子、瓶子等进行真实的互动,比如坐下、拿起物品等。这就是人类与场景互动(Human-Scene Interaction, HSI)建模的目标。

主要功能:

- 捕捉和模拟人类在室内环境中与各种物体的互动行为。

- 生成无限长度的人类与场景互动动作序列。

- 实现实时生成与场景上下文和预期动作相匹配的动作。

主要特点:

- 引入了TRUMANS数据集,这是一个大规模的运动捕捉数据集,包含了100个室内场景中超过15小时的人类互动数据。

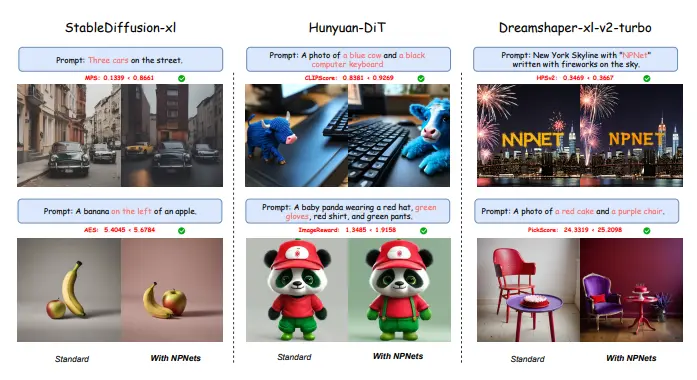

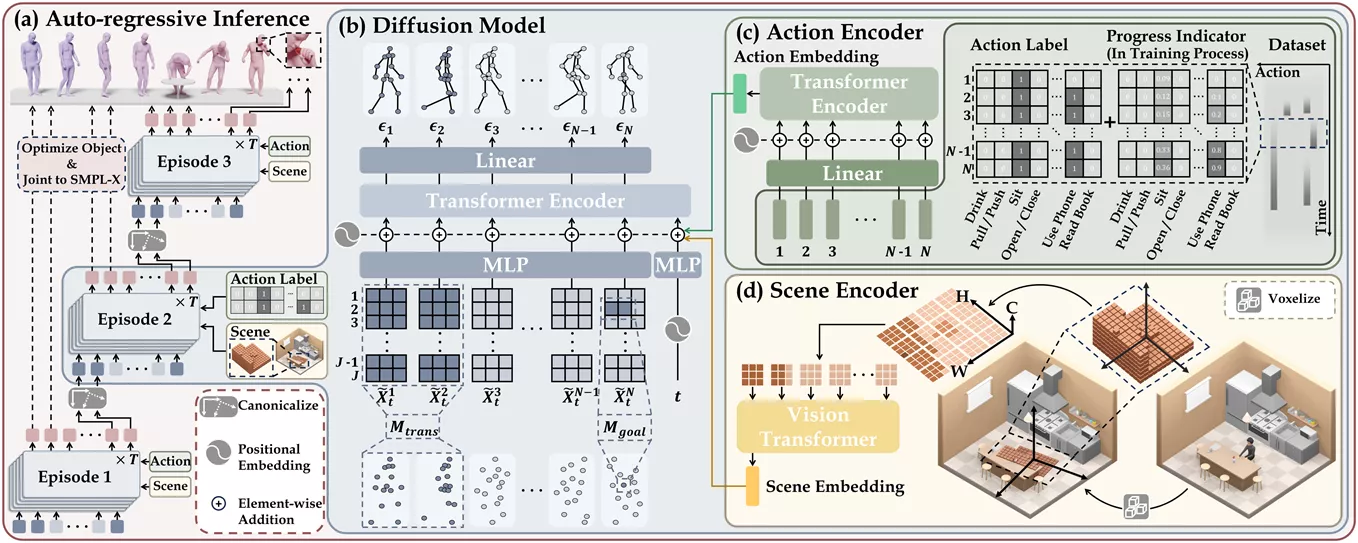

- 提出了一种基于扩散的自回归模型,能够高效地生成任意长度的HSI序列。

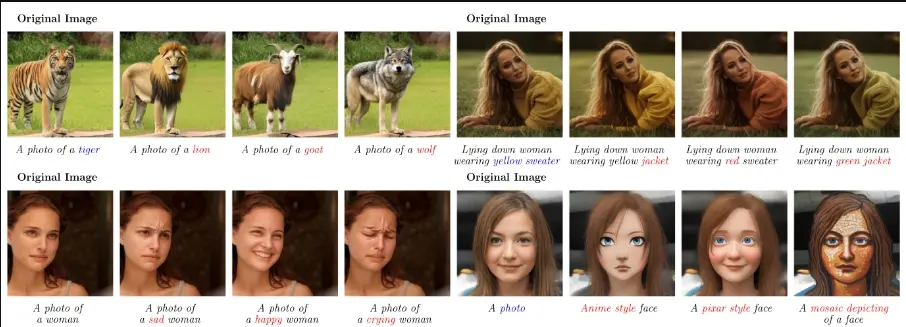

- 通过精确捕捉人体动作和物体动态,以及对接触的真实感进行细致的模拟,确保了交互的真实性。

- 数据集通过将物理环境转化为精确的虚拟模型,并在保持交互真实性的同时,对人物外观和动作进行大量增强。

工作原理:

- 首先,通过高级的运动捕捉系统(如VICON)记录演员在不同场景中的行动。

- 然后,将这些动作数据转换成标准的人体模型(如SMPL-X),并进行优化以确保动作的自然和流畅。

- 接下来,利用TRUMANS数据集训练一个扩散模型,该模型能够根据场景上下文和动作标签生成动作序列。

- 在生成过程中,模型会考虑到场景中的物体位置和动态变化,以及人物的动作意图,从而生成自然且连贯的动作。

具体应用场景:

- 虚拟现实(VR)和增强现实(AR)游戏,提供更加沉浸式的体验。

- 电影和动画制作,用于创造逼真的角色动作和场景交互。

- 机器人技术,用于模拟人类行为,提高机器人在复杂环境中的交互能力。

- 人机交互(HCI)研究,用于设计更加直观和自然的交互界面。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...