香港大学和字节跳动的研究人员推出新型视频生成模型Loong,它基于自回归大语言模型(LLMs),能够生成长达一分钟的连贯、内容丰富的视频。这在视频生成领域是一个挑战,因为视频通常包含大量的帧,每帧都需要精确的细节和动态。具体来说,研究人员将文本token和视频token建模为自回归LLMs的统一序列,并从头开始训练模型。研究人员提出了逐步短到长的训练方法,并采用损失重加权方案来减轻长视频训练中的损失不平衡问题。研究人员进一步研究了推理策略,包括视频token重新编码和采样策略,以减少推理过程中的误差累积。Loong可以在10秒的视频上训练,并扩展到根据文本提示生成分钟级别的长视频,结果证明了这一点。

主要功能

Loong的主要功能是:

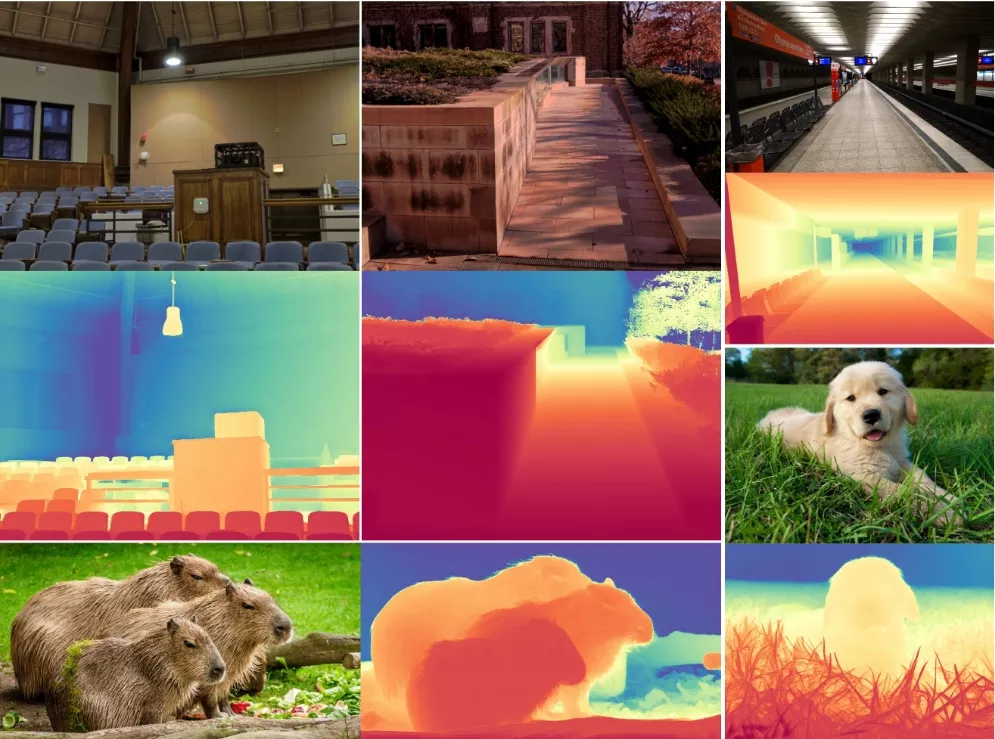

- 长视频生成:能够生成长达一分钟的视频,而不是只有几秒钟。

- 连贯性和一致性:生成的视频在视觉上和动作上都是连贯的,不会因为帧与帧之间的转换而出现跳跃或不自然的变化。

- 丰富的动态和场景转换:能够捕捉和生成复杂的动作和场景变化。

主要特点

- 自回归语言模型:使用自回归语言模型来生成视频序列,这使得模型能够捕捉长期依赖性和复杂的时间模式。

- 统一的文本和视频令牌序列:将文本和视频信息统一建模,提高了生成视频的质量和一致性。

- 渐进式短到长训练:通过逐步增加训练视频的长度,模型能够从短视频生成能力平滑过渡到长视频生成。

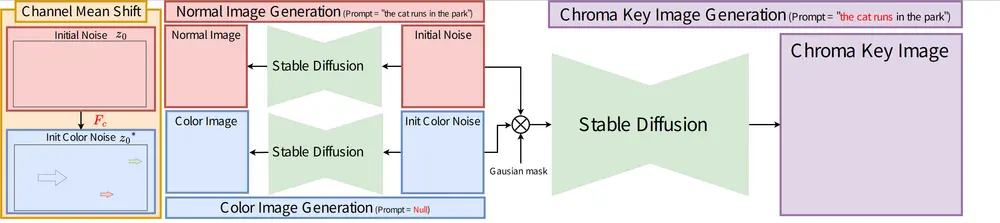

工作原理

Loong模型的工作原理包括以下几个关键步骤:

- 视频分词器:将视频帧压缩成离散的视频令牌序列。

- 自回归LLM:基于文本令牌,预测下一个视频令牌,生成连贯的视频序列。

- 渐进式训练:先在短视频上训练模型,再逐步增加视频长度,以训练模型捕捉更长期的依赖性。

- 损失重加权:在训练过程中,对早期帧的损失给予更高的权重,以确保模型不会只关注后期帧的预测。

- 推理策略:在推理时,通过重新编码视频令牌和采用Top-k采样策略,减少误差累积,提高长视频的生成质量。

具体应用场景

- 娱乐和社交媒体:用户可以提供文本描述,生成相应的视频内容,用于娱乐或社交媒体分享。

- 教育和培训:生成教学视频,如科学实验或历史事件的模拟。

- 电影和视频制作:辅助视频制作人快速原型设计或生成特效场景。

- 新闻和报道:生成新闻报道的背景视频,提高报道的可视化和吸引力。

总的来说,Loong模型通过结合文本和视频信息,使用自回归语言模型生成长视频,为视频内容的自动生成提供了新的可能性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...