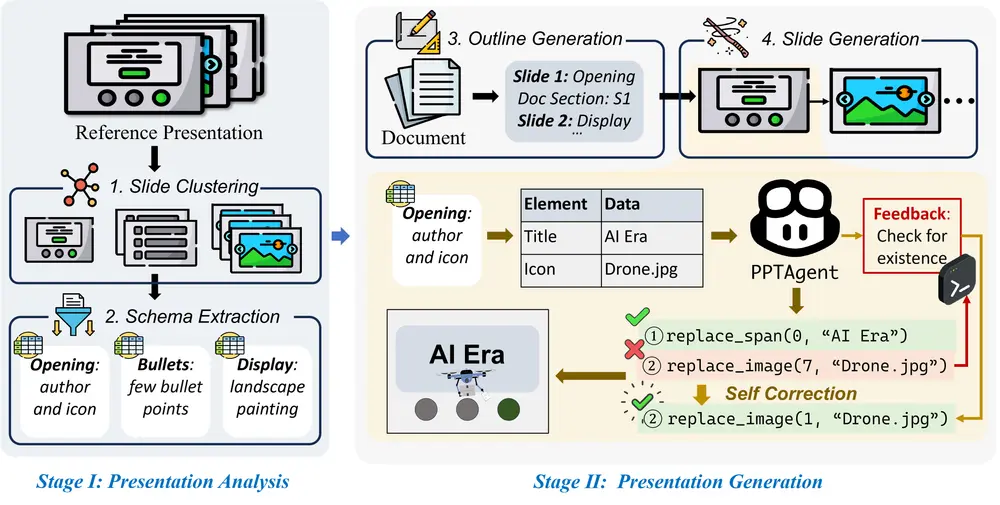

上海交通大学和腾讯优图实验室的研究人员推出新型高效微调方法SaRA,用于提升预训练扩散模型在新任务上的表现。扩散模型是一种强大的生成模型,能够生成图像、视频和3D模型等。但这些模型通常需要大量的参数,直接在新任务上进行微调既费时又费力。SaRA方法通过巧妙地利用模型中那些看似不重要的参数,使得预训练模型能够更高效地适应新任务。

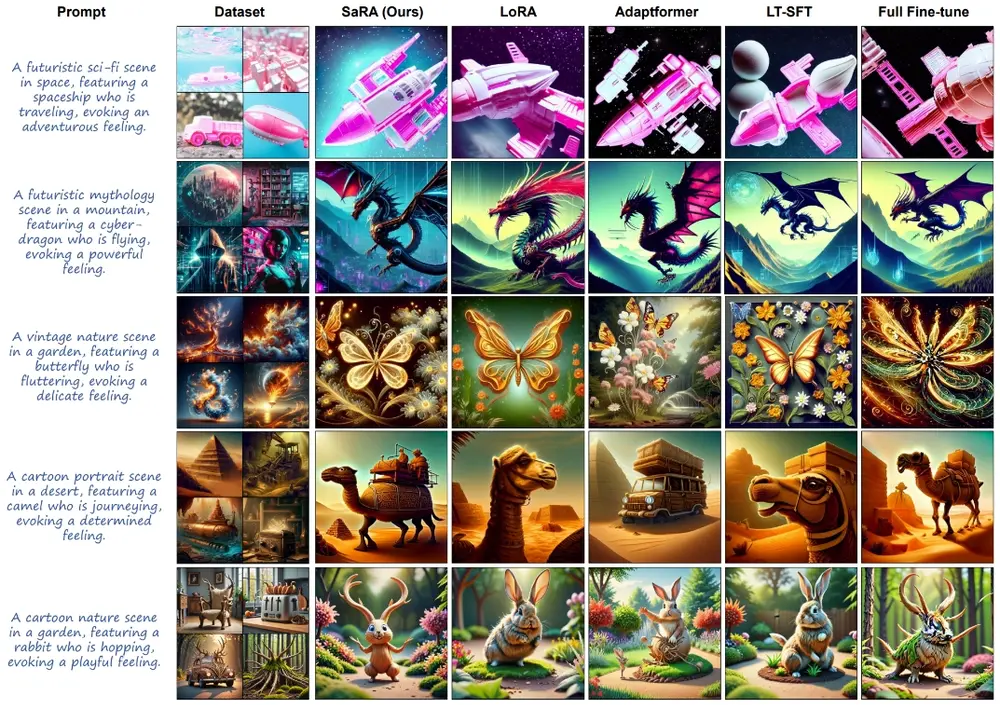

研究团队设计了一种新的渐进参数调整策略,以充分利用重新训练/微调的参数。最后,研究团队提出了一种新的无结构反向传播策略,显著减少了微调期间的内存成本,并进一步增强了选择性PEFT领域。SaRA方法在下游应用中增强了预训练模型的生成能力,并在保持模型泛化能力方面优于传统的微调方法如LoRA。研究团队通过对SD 1.5、SD 2.0和SD 3.0进行微调实验验证了我们的方法,并展示了显著改进。此外,研究团队在包括域转移、定制和视频生成的各种下游任务中将SaRA方法与之前的微调方法进行了对比,证明了其有效性和泛化性能。SaRA还提供了一个实用的优势,即只需修改一行代码即可高效实现,并且可以无缝兼容现有方法。

主要功能:

SaRA的主要功能是提高预训练扩散模型在特定下游任务上的效率和性能。它通过微调模型中那些原本不起作用的参数,使模型能够学习到新任务所需的特定知识,而不需要对整个模型进行大规模的调整。

主要特点:

- 参数重要性分析:SaRA首先分析预训练模型中的参数,找出那些对模型输出影响不大的参数。

- 稀疏低秩适应:通过优化这些参数,SaRA能够以稀疏的方式学习新任务的知识,同时避免过拟合。

- 渐进式参数调整:SaRA设计了一种策略,能够在微调过程中逐步调整参数,确保所有参数都能有效地贡献于新任务的学习。

- 非结构化反向传播:SaRA提出了一种新的反向传播策略,减少了微调过程中的内存消耗,提高了微调的效率。

工作原理:

SaRA的工作原理可以分为几个步骤:

- 参数筛选:识别出预训练模型中那些绝对值较小、对输出影响不大的参数。

- 稀疏矩阵优化:将这些参数表示为稀疏矩阵,并对其进行优化,以学习新任务的知识。

- 低秩约束:为了防止过拟合,SaRA通过核范数约束来限制稀疏矩阵的秩,确保模型的泛化能力。

- 反向传播优化:在训练过程中,只保留需要更新的参数的梯度,减少内存消耗,提高计算效率。

具体应用场景:

- 图像生成:在图像生成任务中,SaRA可以帮助模型更快地适应新的图像风格或内容。

- 视频生成:在视频生成领域,SaRA可以用于生成与特定场景或动作相关的视频。

- 3D模型生成:在3D建模中,SaRA可以用于生成特定形状或纹理的3D对象。

- 图像编辑:SaRA还可以用于图像编辑任务,如改变图像中的某些元素,而不影响其他部分。

总的来说,SaRA提供了一种高效且灵活的方法,使得预训练的扩散模型能够更容易地适应各种新任务,同时保持了模型的泛化能力和生成质量。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...