由清华大学、微软亚洲研究院、中国科学技术大学、约翰斯·霍普金斯大学和苏黎世联邦理工学院联合提出的Dummy Forcing,是一款针对自回归视频扩散模型的无训练(training-free)加速技术。其核心突破在于发现并利用了模型中约25%的“虚拟注意力头(dummy heads)”特性,通过异构内存分配、动态头编程等创新策略,在几乎不损失生成质量的前提下,实现了实时视频生成、高分辨率加速、长上下文扩展三大核心能力,且可直接适配现有预训练模型,无需微调或蒸馏,为视频生成的工程落地提供了高效可行的优化方案。

核心洞察:25%的注意力头,竟是“无效历史帧利用”的关键

自回归视频扩散模型的核心痛点是计算/内存开销随视频长度线性增长——每生成一帧都需通过KV缓存“回顾”所有历史帧,越长的视频生成速度越慢,高分辨率、长上下文生成更是受限于二次复杂度瓶颈。

而Dummy Forcing的核心发现,打破了这一固有困境:

自回归视频扩散模型中约25%的注意力头,存在严重的历史帧利用不足问题,这类头会将80%以上的注意力集中在当前帧,几乎不关注历史帧信息,研究者将其定义为虚拟注意力头(dummy heads)。

更关键的是,该现象还具备两大稳定特性:一是dummy heads的位置在不同条件下保持92%的核心集比率,不会随意变化;二是直接删除这些头的KV缓存,仅会导致模型0.26%的性能下降,几乎可忽略不计。

这一发现如同找到团队协作中的“低效环节”——部分成员从不参考过往资料,仅专注当前任务,无需为其准备历史档案,从而大幅节省资源与时间,Dummy Forcing正是基于此展开针对性优化。

核心创新:四大技术策略,让“虚拟头”成为加速利器

Dummy Forcing并非简单删除dummy heads的KV缓存,而是通过四大核心技术,实现对注意力头的精细化管理与计算优化,在降开销的同时最大限度保留生成质量,且全程无需额外训练。

1. 异构内存分配(Heterogeneous Memory Allocation, HMA)

将模型中的注意力头按历史帧利用方式分为三类,为每类头分配差异化的KV缓存策略,按需保留帧信息,从根源减少内存占用:

- Dummy Heads:仅保留当前帧,彻底删除历史帧KV缓存,专注当前帧细节精炼;

- Sink Heads:仅保留1个全局锚点帧(sink帧)+ 当前帧,负责维护视频的长期一致性,避免跨帧角色/场景“变脸”;

- Neighbor Heads:保留滑动窗口内的邻近帧 + 当前帧,聚焦视频的短期动态,保证帧间过渡的流畅性。

2. 动态头编程(Dynamic Head Programming, DHP)

将“头分类”转化为量化优化问题,通过贪心算法实现精准、高效的头类型判定,避免人工分类的误差:

- 优化目标:最大化模型的信息保留量(基于注意力分数);

- 约束条件:强制指定预设数量的dummy heads;

- 判定方法:计算每个头的机会成本,排序后选择成本最小的N个作为dummy heads,单次分类计算耗时<100ms,后续可固定使用。

3. 打包注意力前向(Packed Attention Forward, PAF)

解决头分类后的边界误差与计算开销问题,提升推理效率:

- 为dummy heads额外添加1个“打包帧”(前一帧),使其与Sink Heads拥有相同的有效上下文长度(2帧);

- 可将dummy heads与Sink Heads合并为一次注意力内核调用,减少内核启动的额外开销,进一步提升推理速度。

4. 训练无关(Training-Free)

这是Dummy Forcing的工程化核心优势:

- 无需对预训练模型做任何微调、蒸馏或重新训练,可直接插拔式应用于Self-Forcing、LongLive、CausVid等主流自回归视频扩散模型;

- 与TeaCache等现有加速方法正交兼容,可组合使用实现叠加加速效果。

核心能力:三大维度突破,兼顾速度、分辨率与上下文

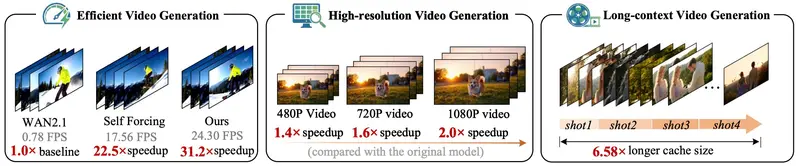

基于上述技术,Dummy Forcing在实时生成、高分辨率、长上下文三大视频生成核心维度实现突破性提升,且所有优化均以“几乎无损质量”为前提,具体性能如下:

1. 高效实时生成:24.3 FPS实现标准分辨率实时渲染

在832×480(480P)标准分辨率下,基于Self-Forcing基线模型测试,Dummy Forcing实现24.3 FPS的生成速度,达到实时视频生成标准(>24 FPS),相比基线实现1.4倍加速;

与TeaCache组合使用后,速度可进一步提升至30+ FPS,且质量分仅下降0.1%,语义分基本持平,实现“速度与质量兼得”。

2. 高分辨率加速:分辨率越高,加速效果越显著

针对720P、1080P高分辨率视频生成的复杂度瓶颈,Dummy Forcing的加速效果随分辨率提升而增强,完美克服高分辨率下的二次复杂度问题:

- 720P:从5.6 FPS提升至9.1 FPS,1.6倍加速,质量分完全无损失;

- 1080P:从1.3 FPS提升至2.6 FPS,2.0倍加速,质量分仅小幅下降0.75%,几乎可忽略。

3. 长上下文扩展:6.58倍上下文窗口,兼顾长视频一致性

在不增加计算开销的前提下,Dummy Forcing将模型的有效上下文窗口扩大6.58倍,解决了自回归模型长视频生成中“记不住历史信息”的问题:

- 相比传统滑动窗口方案,在保持18.14 FPS相近速度的同时,缓存帧数从36帧提升至237帧;

- 可在跨镜头、长叙事视频中,准确重现之前消失的角色、背景与场景设定,大幅提升长视频的生成一致性,总分反超滑动窗口方案。

实测结果:多维度验证,性能与泛化性双优

研究者在VBench基准数据集上,从基础性能、高分辨率、长上下文、组件有效性、跨模型泛化五个维度展开测试,全面验证了Dummy Forcing的优势,核心测试结果如下:

1. 基础实时生成(480P)

| 方法 | 分辨率 | FPS | 加速比 | 质量分 | 语义分 | 总分 |

|---|---|---|---|---|---|---|

| Self-Forcing(基线) | 832×480 | 17.56 | 1.0× | 84.73 | 81.03 | 84.00 |

| Self-Forcing+TeaCache | 832×480 | 21.82 | 1.2× | 84.22 | 80.47 | 83.47 |

| Self-Forcing+Dummy Forcing | 832×480 | 24.30 | 1.4× | 84.63 | 80.98 | 83.90 |

结论:1.4倍加速下,质量仅下降0.1%,是所有加速方案中“速度-质量”平衡最优的选择。

2. 高分辨率生成(720P/1080P)

| 方法 | 分辨率 | FPS | 加速比 | 质量分 | 语义分 | 总分 |

|---|---|---|---|---|---|---|

| Self-Forcing(基线) | 720P | 5.6 | 1.0× | 84.77 | 81.93 | 84.20 |

| Self-Forcing+Dummy Forcing | 720P | 9.1 | 1.6× | 84.77 | 81.61 | 84.14 |

| Self-Forcing(基线) | 1080P | 1.3 | 1.0× | 84.90 | 78.68 | 83.66 |

| Self-Forcing+Dummy Forcing | 1080P | 2.6 | 2.0× | 84.15 | 78.76 | 83.07 |

结论:分辨率越高加速效果越明显,且质量损失均<1%,完全满足实际应用需求。

3. 长上下文生成

| 设置 | 缓存帧数 | 上下文比率 | FPS | 加速比 | 总分 |

|---|---|---|---|---|---|

| LongLive w/o sw | 237 | 6.58× | 9.36 | 1.00× | 69.38 |

| LongLive w/ sw | 36 | 1.00× | 17.57 | 1.87× | 68.45 |

| Dummy Forcing | 237 | 6.58× | 18.14 | 1.93× | 69.48 |

结论:在6.58倍长上下文下,速度反超传统滑动窗口方案,且生成一致性更优。

4. 泛化性验证

Dummy Forcing不仅在Self-Forcing上表现优异,还可直接应用于CausVid、Rolling Forcing、RealTime-14B等不同架构的自回归视频扩散模型,均能实现稳定的加速效果,证明dummy head现象在自回归视频扩散模型中具有普遍性,该技术的适配性与泛化性极强。

相关文章