在图像生成领域,扩散模型已成为主流架构之一。其训练过程基于一个理论上的“最优去噪器”——即在给定噪声水平下,能够最小化重建误差的理想函数。有趣的是,这一最优解虽然数学上可定义,却只能复现训练集中的样本,无法创造出新颖内容。

而现实中,像U-Net这样的深层扩散模型却能生成高度逼真且前所未见的图像。这种“超越理论最优”的现象引发了一个关键问题:

为什么深度扩散模型可以突破最优去噪器的限制?

一种流行解释认为,这得益于卷积神经网络(CNN)所具有的归纳偏见(inductive bias),尤其是平移等变性和局部感受野结构,使模型更擅长捕捉图像的空间局部模式。

然而,麻省理工学院与丰田研究所的最新研究《Locality in Image Diffusion Models Emerges from Data Statistics》提出了不同观点。他们通过理论分析与实验验证指出:

图像扩散模型中观察到的“局部性”,并非源于CNN架构的设计偏好,而是自然图像数据本身统计特性的直接反映。

问题背景:为何“最优”反而受限?

扩散模型的核心思想是逆向去噪:从纯噪声出发,逐步恢复出清晰图像。理论上,在每个去噪步骤中都存在一个闭式最优解——称为最优参数化线性去噪器(Optimal Parameterized Linear Denoiser)。该解由训练数据的协方差结构唯一决定。

但这个“最优”方案有一个致命缺陷:

它仅能在训练集中插值,无法泛化到新样本,因此不具备真正的生成能力。

相比之下,实际使用的深度扩散模型(如基于U-Net或Transformer的架构)尽管并未达到理论最优,却表现出更强的创造性与多样性。

这就引出了核心矛盾:

如果最优解已被数学定义,为何非最优的深度模型反而表现更好?

现有假设 vs 新发现

流行假设:CNN 的归纳偏见导致局部性

此前研究推测,U-Net 等模型之所以成功,是因为其卷积结构引入了两种关键先验:

- 局部性(locality):每个输出主要依赖邻近输入区域;

- 平移等变性(shift equivariance):相同图案无论出现在何处,响应一致。

这些先验被认为帮助模型更好地建模图像局部结构,从而超越线性最优解。

本文挑战:局部性来自数据,而非模型

作者提出并验证了一个反直觉的观点:

即使不使用CNN,只要数据本身具有空间相关性,任何充分训练的模型都会自发学习出局部敏感性。

换句话说,局部性不是模型强加给数据的约束,而是数据教会模型的结果。

核心论证路径

1. 最优线性去噪器也展现局部敏感性

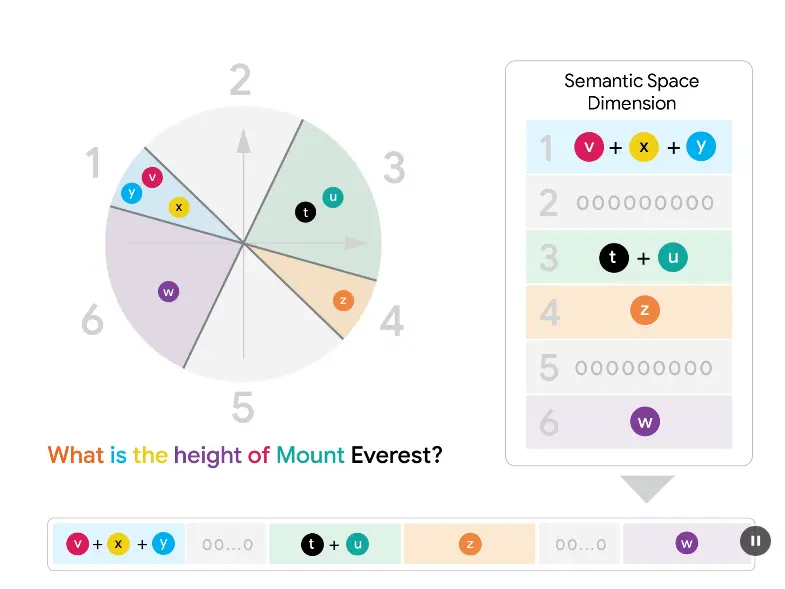

研究人员计算了基于训练数据协方差矩阵的最优线性去噪器,并可视化其“敏感性场”(sensitivity field)——即某个输出像素对所有输入像素的响应权重分布。

结果令人惊讶:即使这是一个全连接、无结构假设的线性模型,其敏感性场仍呈现出明显的局部聚集特征,类似于CNN的感受野。

这说明:局部性已隐含在数据协方差之中。

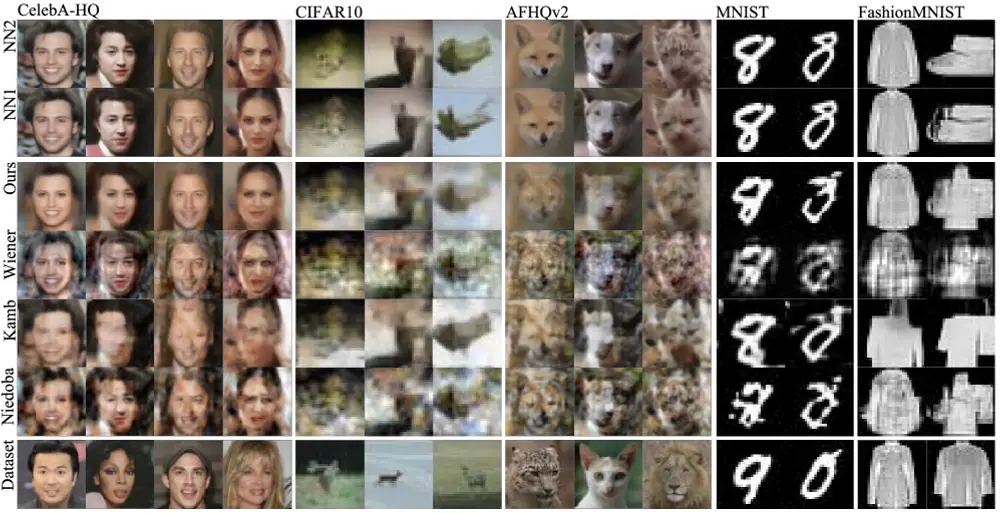

2. 不同架构均收敛于相似敏感性模式

为了排除架构影响,团队在相同数据集上训练了多种结构不同的模型:

- U-Net(典型CNN)

- Vision Transformer(全局注意力机制)

结果显示:尽管初始归纳偏见不同,两类模型在训练后均发展出高度相似的局部敏感性场,且与数据主成分方向高度对齐。

这意味着:无论是否内置局部先验,模型最终都被数据拉向同一行为模式。

3. 数据主成分决定去噪行为

进一步分析表明,图像数据的前几个主成分(通过PCA提取)在空间上具有局部支持特性(spatially localized support),并与去噪器的关键滤波方向高度相关。

由此得出结论:

自然图像中像素间的短程强相关性,是驱动去噪器形成局部响应的根本原因。

构建更准确的分析模型

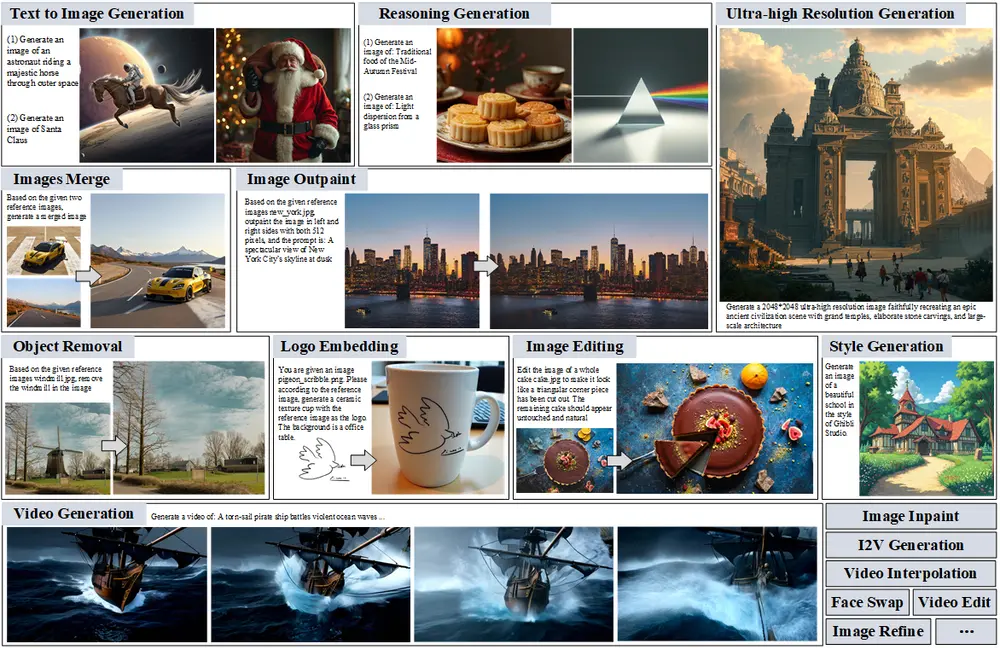

基于上述洞察,作者构建了一种新的无需训练的分析型去噪器(analytical denoiser),其构造方式如下:

- 对训练集进行PCA,提取主要变化方向;

- 利用这些方向构造低秩近似下的去噪算子;

- 将其应用于噪声图像,预测扩散模型的“分数”(score)。

实验结果亮点:

| 指标 | 表现 |

|---|---|

| 分数预测相关性 | 在CIFAR-10、CelebA-HQ等多个数据集上,新模型预测的分数与真实U-Net输出的相关性显著高于传统最优线性去噪器 |

| 敏感性场匹配度 | 更好地还原了深度模型的实际感受野结构 |

| 图像生成质量 | 使用该分析模型生成的样本,在视觉合理性与细节保真方面优于基线方法 |

这表明:仅依靠数据统计特性,就能构建出逼近真实扩散模型行为的解析模型。

意义与启示

这项工作重新审视了“模型先验 vs 数据驱动”的关系,带来几点重要启示:

- 局部性是数据的性质,不是模型的特权

CNN的局部结构虽有益,但并非局部感知的必要条件;只要有足够数据,其他架构也能学会。 - 扩散模型的成功源于对数据结构的忠实建模

其强大生成能力并非来自某种神秘的非线性魔法,而是有效捕捉了像素间复杂但有序的相关性。 - 为无训练生成模型提供新思路

基于数据协方差和主成分的分析模型,可能成为理解、诊断甚至替代部分训练流程的有效工具。

相关文章