上海AI实验室推出 Intern-S1-Pro —— 一款面向科学发现的万亿级混合专家(MoE)多模态大模型。该模型在保持强大通用能力的同时,专为 AI for Science(AI4Science)场景深度优化,在化学、材料科学、生命科学、地球科学等关键领域展现出领先性能。

- GitHub:https://github.com/InternLM/Intern-S1

- 模型:https://huggingface.co/collections/internlm/intern-s1

- Demo:https://chat.intern-ai.org.cn

核心规格

- 总参数量:1 万亿(1T)

- 专家数量:512 个

- 激活机制:每 token 动态激活 8 个专家(激活参数约 22B)

- 架构类型:稀疏激活的混合专家(MoE)模型

通过高效稀疏激活,Intern-S1-Pro 在推理时仅调用约 2.2% 的总参数,兼顾了性能与计算效率。

核心特性

1. 领先的科学推理能力

在多个 AI4Science 基准测试中,Intern-S1-Pro 的表现达到或超越当前顶尖闭源模型。

无论是分子性质预测、材料结构生成,还是生物序列分析、气候建模,模型均能进行多步、跨模态、可解释的复杂推理。

2. 强大的通用多模态能力

除科学任务外,模型在通用图像理解、图文生成、文档解析等标准多模态评测中同样表现强劲,无需牺牲通用性来换取专业性。

3. 高效 MoE 训练架构

- 采用 STE 路由机制(Sparse Training with Expert-dense gradients):在路由训练阶段使用稠密梯度,显著加速收敛;

- 引入 分组路由策略:在专家并行训练中实现负载均衡,提升硬件利用率与训练稳定性。

4. 傅里叶位置编码(FoPE) + 时序建模

针对科学数据中常见的高维信号(如光谱、地震波、EEG、遥感影像等),模型引入 傅里叶位置编码(FoPE),使其能:

- 敏锐捕捉物理信号的频谱特征;

- 统一处理从 10⁰ 到 10⁶ 采样点 的多通道时序信号;

- 有效建模长程依赖与多尺度动态。

这一设计让 Intern-S1-Pro 能直接处理原始科学仪器输出,无需繁琐预处理。

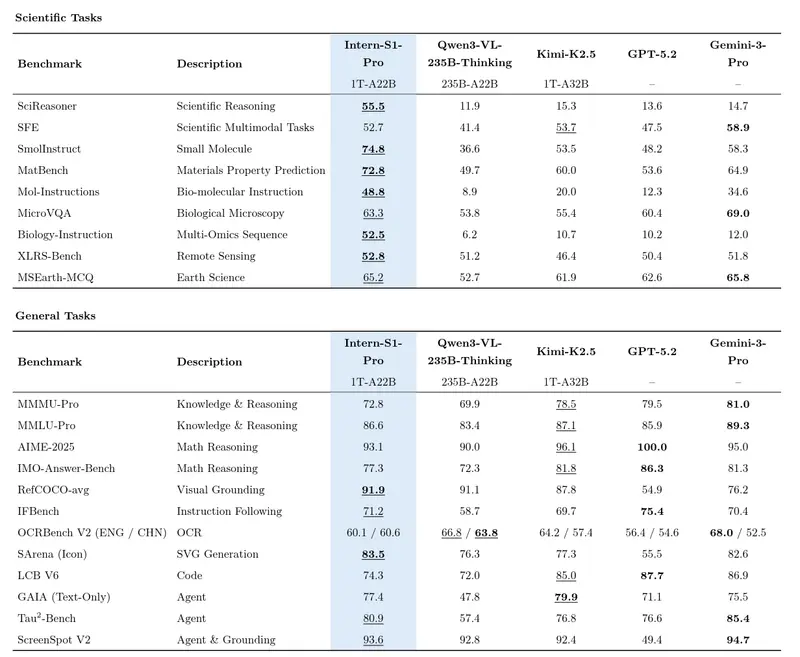

性能评估

研究团队在多个通用数据集和科学数据集上评估了 Intern-S1 的表现,并与近期的视觉语言模型(VLMs)和大语言模型(LLMs)进行了对比,结果如下表所示。

为什么重要?

传统大模型在科学任务上常因缺乏领域知识或信号建模能力而受限。Intern-S1-Pro 通过架构创新 + 科学数据对齐 + 高效 MoE 扩展,首次在一个统一模型中实现了:

- 专业深度:胜任前沿科研任务;

- 通用广度:支持日常多模态交互;

- 工程可行性:通过稀疏激活控制推理成本。

这标志着 AI4Science 正从“专用工具”迈向“通用智能科研助手”的新阶段。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)