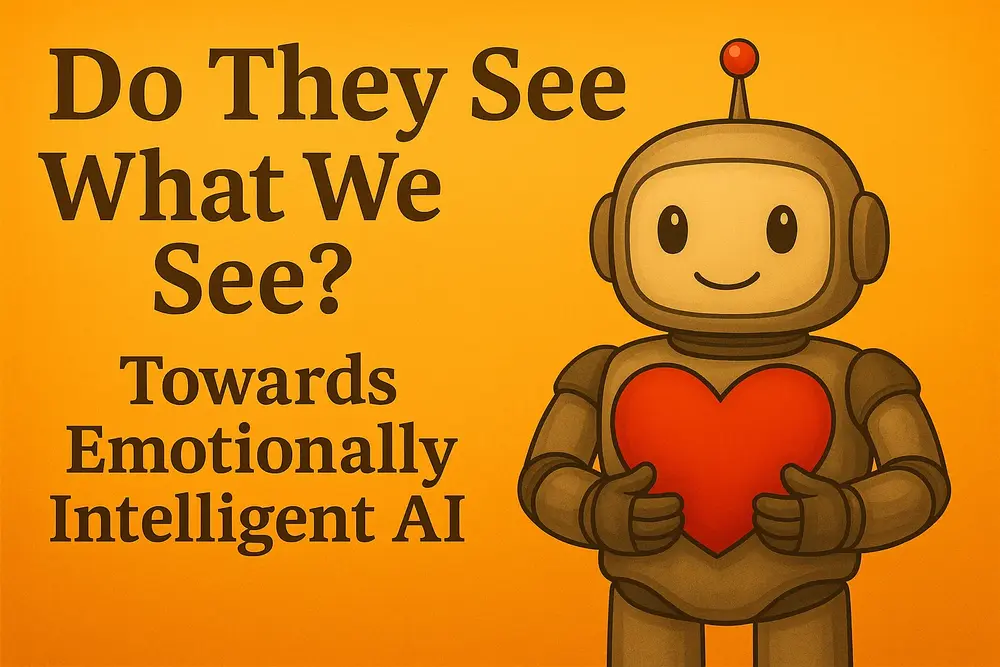

人工智能的发展正进入一个全新的阶段:从理解语言到理解情绪。尽管AI在语言处理、推理能力等方面取得了显著进展,但在情感智能(Affective Intelligence)这一维度上,仍然存在巨大空白。

今天,非营利组织 LAION AI 正式发布了 EmoNet 系列模型与数据集——一套面向全球开源的情感智能工具包。该项目由 LAION 与 英特尔(Intel) 联合推动,填补当前AI在情感识别与理解方面的研究空白,为构建更具同理心的人机交互系统提供坚实基础。

情感智能为何重要?

人与人之间的交流远不止于语言本身。面部表情的细微变化、声音中的情绪波动,甚至沉默中的心理状态,都是沟通中不可或缺的一部分。

如果AI能感知一个人眼角的喜悦、语调中的焦虑,或是在对话中捕捉复杂的情感混合,那么它将不再只是冷冰冰的“工具”,而是可能成为:

- 更具亲和力的教育助手;

- 更懂人心的心理健康陪伴者;

- 更自然的语音交互伙伴。

这正是 EmoNet 所追求的目标:让AI不仅能听懂你说什么,更能理解你为什么这么说。

EmoNet 是什么?

EmoNet 是一套专注于视觉与语音情感识别的模型与数据集集合,包含:

📷 视觉情感识别:EMONET-FACE

- 包含超过 20万张合成图像,涵盖多种种族、年龄、性别;

- 提供三个子集:BIG(预训练)、BINARY(微调)、HQ(高精度评估);

- 每个样本标注了 40类精细情感状态,包括喜悦、困惑、疲惫、羞耻等。

🎙️ 语音情感识别:EMONET-VOICE

- 基于 LAION's Got Talent 数据集,包含 5000+小时 合成语音;

- 覆盖 11种语音风格、40种情感类别、4种语言(英/德/法/西);

- 每条音频都经过心理学专家标注,强调情感强度而非单一标签。

🧠 先进模型:EMPATHIC INSIGHT

- EMPATHIC INSIGHT-FACE:在 HQ 数据集上超越 Gemini Pro 和 Hume AI;

- EMPATHIC INSIGHT-VOICE:为语音情感估计设定新基准;

- 支持多模态情感推理,具备接近人类专家级的表现。

🗣️ BUD-E Whisper:不只是转录,更是情感字幕

- 在 Whisper 基础上扩展,支持对语音内容进行:

- 情感语气识别(基于40类分类体系);

- 非词汇事件检测(如笑声、叹息);

- 说话者特征分析(年龄、性别、口音等)。

EmoNet 的核心创新点

| 创新点 | 描述 |

|---|---|

| ✅ 40类精细情感分类体系 | 超越传统“喜怒哀乐”基本情感,涵盖认知、物理、社交等多种状态。 |

| ✅ 跨模态统一架构 | 面部与语音使用相同情感分类体系,便于构建多模态情感系统。 |

| ✅ 强度感知注释 | 不仅判断是否存在某种情感,还标注其强度等级(无/轻度/重度)。 |

| ✅ 高质量专家标注 | 由心理学专业人员参与,确保数据科学性与一致性。 |

| ✅ 合成数据驱动 | 避免隐私问题,实现人口统计多样性与可控性。 |

技术背后的理念:构建情感理论(TCE)

EmoNet 的设计深受心理学框架 构建情感理论(Theory of Constructed Emotion) 影响。该理论认为,情感并非固定实体,而是大脑根据生理信号、文化背景和情境信息“构建”的结果。

因此,EmoNet 强调的是情感估计,而非简单识别。这意味着:

- AI应能理解“快乐”不是一种表情,而是一种复杂的组合;

- 应能区分“疲惫”与“困倦”,“尴尬”与“害羞”;

- 最终目标是让AI具备类似人类的情感推理能力。

开放与合作:推动情感AI民主化

EmoNet 的所有模型与数据均采用开放许可方式发布:

- 模型:Creative Commons 许可;

- 代码:Apache 2.0;

- 数据:遵循宽松许可,鼓励全球研究人员自由使用与改进。

此外,LAION 还计划在未来几年内推出 超过50万小时的多语言情感语音数据集,并借助 Intel® Tiber™ AI Cloud 提供高性能计算支持,进一步降低情感AI的研究门槛。

展望未来:通用语音演员的愿景

EmoNet 不只是一个技术项目,更是一个关于未来的构想:

让AI不仅会说话,还会“演戏”。

通过结合情感理解与语音生成技术,我们正在迈向一个新时代:AI可以像专业演员一样,根据提示扮演任何角色,传递真实的情感体验。例如:

- 教育领域:适应学生情绪的个性化教学;

- 心理健康:提供共情支持的虚拟陪伴;

- 内容创作:生成富有情感张力的语音故事。

这些应用的核心,正是 EmoNet 所提供的底层情感理解能力。(来源)

相关文章