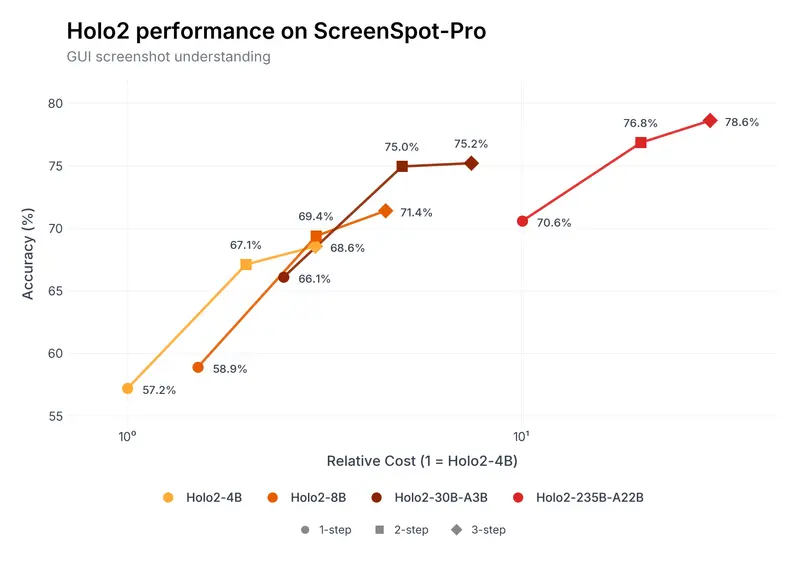

距离首款Holo2模型发布仅两个月,HCompany便推出迄今最大规模的UI定位模型Holo2-235B-A22B Preview,一举在ScreenSpot-Pro基准测试中创下78.5%的新纪录,OSWorld G测试中达到79.0%的高分,成为当前GUI领域性能顶尖的视觉-语言模型,现已在Hugging Face开放获取。

这款模型聚焦UI元素精准定位核心需求,专为多领域图形用户界面智能体打造,也是Holo2系列在大参数量方向的重要研究版本,进一步夯实了该系列在Web、桌面、移动端数字环境操作的技术优势。

核心突破:智能体式定位,攻克4K界面小元素定位难题

高分辨率4K界面的小UI元素定位,是长期困扰GUI模型的难点,而Holo2-235B-A22B凭借智能体式定位技术实现了关键突破。

该技术让模型能通过迭代优化预测结果,每一步推理都持续提升定位准确率,这一特性不仅适配235B大参数量版本,更让整个Holo2系列模型的定位性能实现10-20%的相对增益,彻底解决了4K大屏中按钮、输入框、小链接等元素定位不准的问题。

具体来看,Holo2-235B-A22B的推理性能表现亮眼:

- 单步推理下,ScreenSpot-Pro准确率已达70.6%;

- 开启智能体模式后,仅需3步迭代,准确率便飙升至78.5%,在最具挑战性的GUI基础基准测试中树立了新标杆。

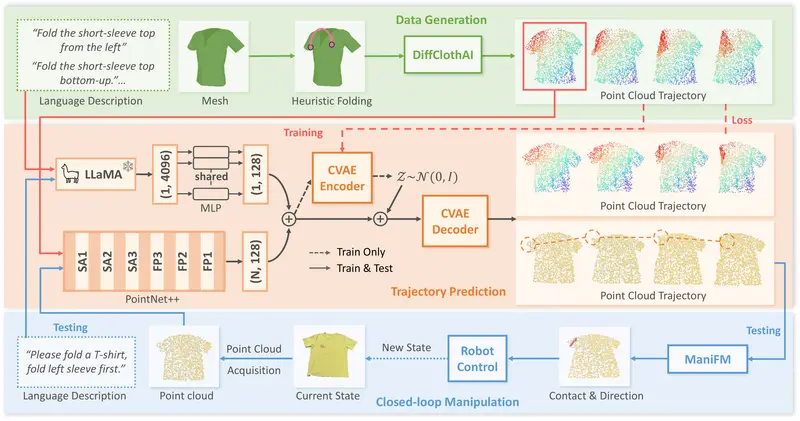

关于Holo2系列:多尺寸覆盖,开源与研究版双轨布局

Holo2系列是HCompany打造的新一代视觉-语言模型(VLM),核心定位是支撑计算机使用智能体的导航与任务执行,在Holo1.5的UI定位、屏幕内容理解优势基础上,完成了策略学习、动作基础、跨环境泛化三大维度的重大升级,实现从静态感知到多步骤、目标导向行为的跨越,可直接为Surfer-H等下一代计算机使用智能体提供核心技术支撑。

整个Holo2系列包含多尺寸模型,兼顾开源易用性与研究级高性能,许可证类型清晰区分:

- Holo2-4B/8B:完全开源,采用Apache 2.0许可证,个人、企业可免费使用、二次开发;

- Holo2-30B-A3B/235B-A22B:仅限研究许可(非商业用途),如需商业落地,可直接联系HCompany;

本次发布的235B版本,基于Qwen/Qwen3-VL-235B-A22B-Thinking微调打造,是系列迄今参数量最大的版本。

训练策略:多源数据+两阶段训练,打磨UI理解与动作预测能力

Holo2-235B-A22B的高性能,源于精心设计的训练策略与高质量数据支撑,模型全程针对UI理解和动作预测做专项优化:

- 多源高质量数据集:融合精心筛选的开源数据集、大规模合成数据、人工标注样本,覆盖Web、桌面、移动端多场景UI布局,贴合真实使用环境;

- 两阶段训练流程:先进行大规模监督式微调,夯实模型基础的UI理解与定位能力;再通过在线强化学习迭代优化,让模型在解释大型复杂屏幕UI、执行精准交互动作上达到SOTA性能。

快速上手:支持自托管+API调用,附完整使用示例

目前Holo2-235B-A22B Preview已开放使用,官方在模型仓库中提供了完整的使用示例,涵盖自托管部署和API调用两种方式,开发者可直接参考示例快速实现模型调用,无需复杂的二次开发。

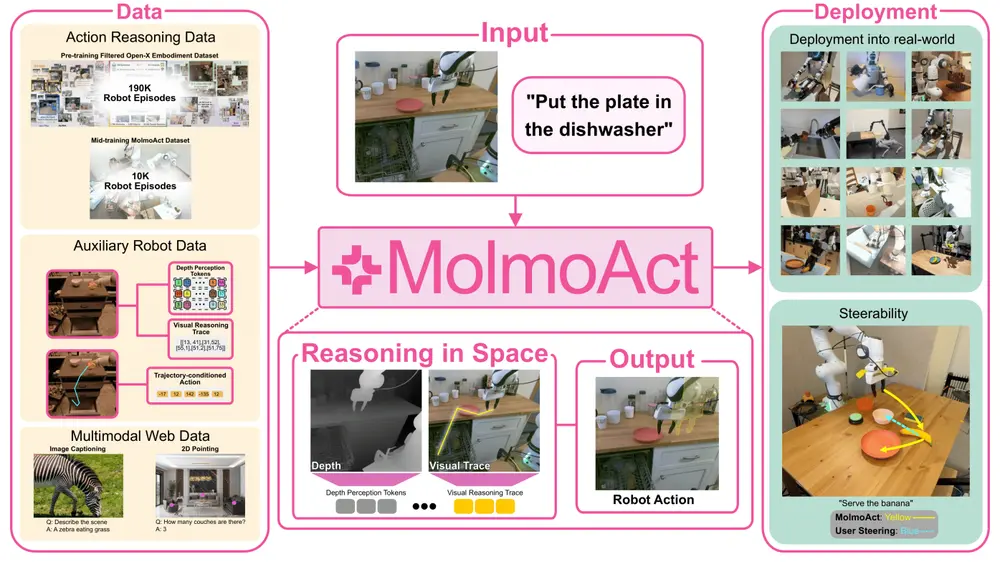

核心定位:打造下一代计算机使用智能体的可靠基础

从4B/8B轻量开源版,到30B/235B研究级大参数量版,Holo2系列的全尺寸布局,核心目标是为下一代计算机使用智能体打造可靠、准确、高效的技术基础。

这些模型能直接理解Web、桌面、移动端的GUI界面,精准定位各类UI元素,并基于定位结果执行多步骤的目标导向操作,未来可广泛应用于自动化办公、智能网页操作、移动端应用智能交互等场景,大幅提升数字环境下的人机协同效率。

相关文章