在现代电影与视频制作中,视觉特效(VFX)是实现创意表达的核心工具。然而,传统 VFX 制作成本高昂、周期长,依赖专业团队和复杂软件。

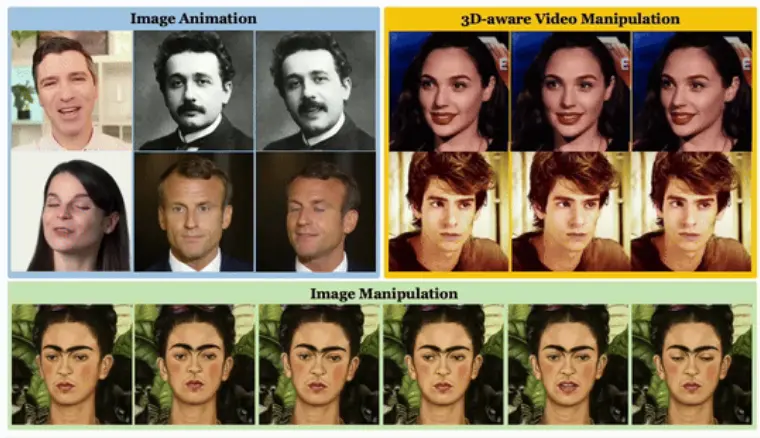

近年来,AI 视频生成模型为 VFX 提供了更具成本效益的替代方案。但现有方法大多基于单一 LoRA 模型训练,只能生成一种固定类型的特效,难以满足真实场景中对“多种特效在指定区域并行发生”的需求。

为突破这一瓶颈,阿里巴巴集团研究团队提出 Omni-Effects —— 首个能够通过文本提示生成空间可控、多类型复合视觉特效的统一框架。

- 项目主页:https://amap-ml.github.io/Omni-Effects.github.io

- GitHub:https://github.com/AMAP-ML/Omni-Effects

- 模型:https://huggingface.co/GD-ML/Omni-Effects

用户只需输入如“让左边的物体融化,右边的物体漂浮起来”这样的自然语言指令,Omni-Effects 即可自动生成符合描述的视频效果,实现前所未有的创意自由度。

核心挑战:多特效生成中的干扰与失控

当前 AI 驱动的 VFX 方法面临两大关键问题:

- 单模型单特效限制:每个 LoRA 模型通常只学习一种特效(如火焰、融化、漂浮),无法灵活组合。

- 空间控制能力弱:即使能生成多种效果,也难以精确指定其在画面中的位置和范围。

更严重的是,当尝试联合训练多个特效时,不同任务之间会产生特征干扰,导致生成结果混乱或失真。

Omni-Effects 通过三项核心技术,系统性地解决了这些问题。

技术创新

1. LoRA-MoE:基于混合专家的多样化特效融合

Omni-Effects 引入 LoRA 基础的混合专家模块(LoRA-MoE),将不同视觉特效分配给不同的“专家”(Expert LoRA)处理。

- 每个专家专注于学习一种特效模式;

- 通过可学习的门控路由器(Gating Router)动态激活相关专家;

- 引入平衡路由辅助损失(Laux),确保各专家负载均衡,避免某些专家被过度使用或忽略。

这一设计使得模型能在统一架构下支持多种特效,同时有效隔离任务间干扰,提升生成保真度。

2. SAP-IIF:空间感知提示与独立信息流

为了实现精确的空间控制,Omni-Effects 提出 空间感知提示(Spatial-Aware Prompt, SAP),将空间掩码信息嵌入文本标记中。

例如,输入提示:

“左侧区域:融化;右侧区域:漂浮”

系统会将“融化”与左半区域掩码绑定,“漂浮”与右半区域绑定,并通过全注意力机制进行联合建模。

为进一步防止不同特效间的信号串扰,框架引入 独立信息流模块(Independent Information Flow, IIF):

- 在注意力计算中应用定制化掩码;

- 隔离不同特效对应的控制路径;

- 确保“融化”指令不会错误影响“漂浮”区域。

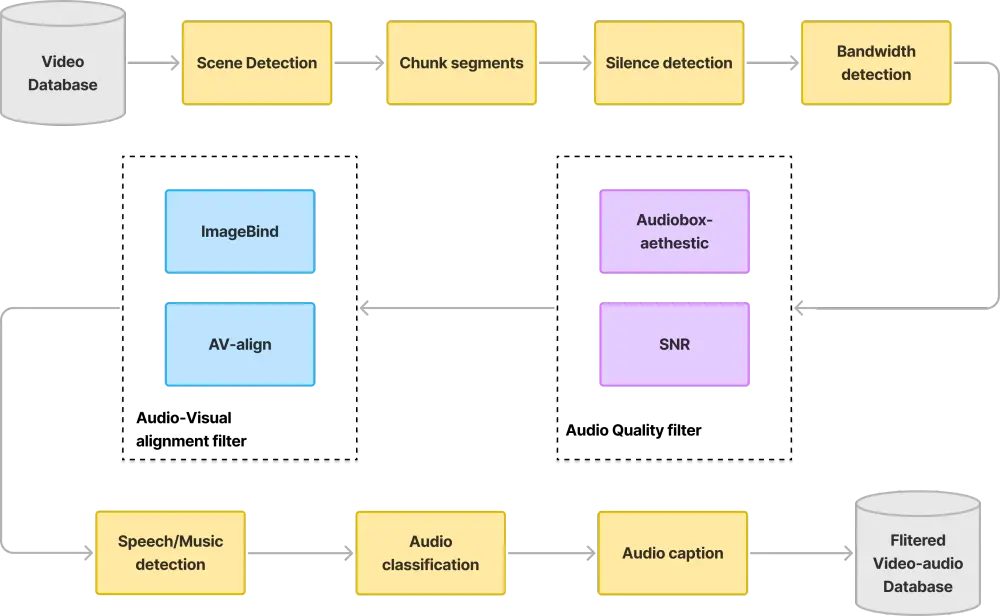

3. 高质量数据集 Omni-VFX 与专用评估体系

为支持该研究,团队构建了首个面向复合 VFX 生成的高质量数据集 —— Omni-VFX。

- 包含 55 种常见视觉特效(如燃烧、结冰、消失、变形、漂浮等);

- 数据生成流程结合 图像编辑(Step1X-Edit) 与 首尾帧到视频合成(FLF2V);

- 每个样本包含起始帧、结束帧、空间掩码、文本描述及中间过渡视频。

此外,团队还提出一套专门的评估指标,用于量化模型性能:

| 指标 | 含义 |

|---|---|

| RDD(Region Dynamic Degree) | 衡量特效在目标区域内动态变化的强度 |

| EOR(Effect Occurrence Rate) | 特效是否成功生成 |

| ECR(Effect Control Rate) | 特效是否准确出现在指定位置 |

主要功能

| 功能 | 说明 |

|---|---|

| 单特效生成 | 支持通过文本提示生成单一特效,如“让场景下雪” |

| 多特效生成 | 可在同一条视频中并发生成多个不同类型特效 |

| 空间可控性 | 支持通过掩码或区域描述精确控制特效作用范围 |

| 可扩展性 | 尽管训练时仅使用最多两种特效组合,推理时可扩展至 N>2 的复杂组合 |

实验结果:全面领先

单特效生成

在 EOR 和 ECR 指标上,Omni-Effects 分别达到 0.97 和 0.88,显著优于基线方法(如 ControlNet + LoRA)。

RDD 平均值为 2.93,表明生成效果具有强烈的动态表现力。

多特效生成

在“融化 + 漂浮”组合任务中:

- EOR:0.68

- ECR:0.41

远超现有方法。用户研究也显示,Omni-Effects 在整体质量和可控性方面均获得最高评分。

泛化能力

模型在训练时仅使用 N=2 的多特效样本,但在推理时能稳定支持 3 种甚至更多并发特效,展现出强大的组合泛化能力。

相关文章