阿里云 PAI 团队昨日正式推出 Wan2.2-Fun 系列模型,作为其 VideoX-Fun 项目的重要更新,进一步扩展了文生视频与可控视频生成的能力边界。

该系列基于此前广受关注的 Wan2.1-Fun 和 CogVideoX-Fun 技术路线持续演进,此次发布的 Wan2.2-Fun 在分辨率支持、控制能力、多语言理解等方面均有显著提升。

但对于普通用户来说,需注意:

🔴 模型体积大、显存要求高,4090以下显卡不建议运行官方完整版。

🚀 Wan2.2-Fun 模型概览

| 名称 | 存储空间 | Hugging Face | ModelScope | 功能描述 |

|---|---|---|---|---|

| Wan2.2-Fun-A14B-InP | 47.0 GB | 下载 | 下载 | 文图生视频权重,支持多分辨率训练,可进行首尾帧预测 |

| Wan2.2-Fun-A14B-Control | 47.0 GB | 下载 | 下载 | 支持 Canny、Depth、Pose、MLSD 等多种控制条件,新增轨迹控制功能;支持多分辨率(512/768/1024)视频生成 |

两个模型均基于 14B 参数规模,以 81 帧、16fps 的设定进行训练,支持长序列视频生成。

✨ 核心能力亮点

1. 多分辨率支持

- 支持多种分辨率输入与输出

- 训练过程中采用多尺度策略,增强模型对不同画幅的适应性

- 更高分辨率意味着更清晰的细节表现,适合高质量内容创作

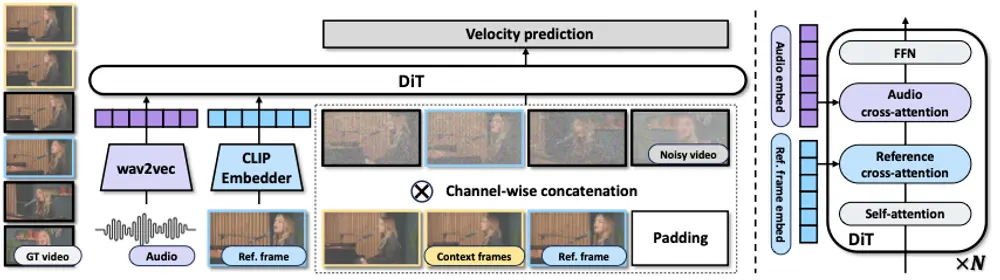

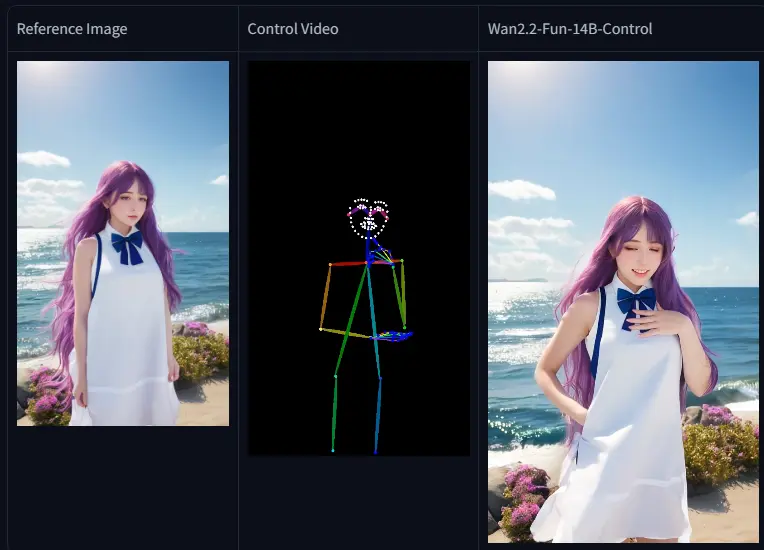

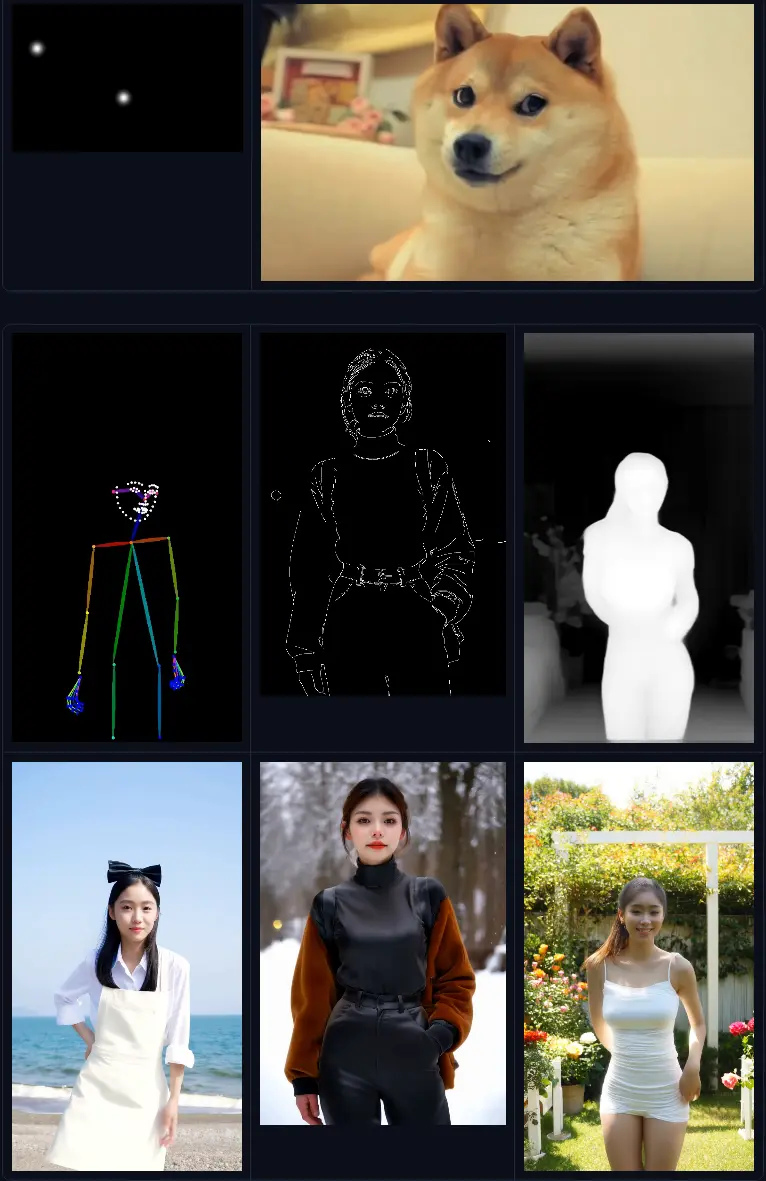

2. 强大的控制生成功能(Control 版专属)

Wan2.2-Fun-Control 支持多种视觉控制信号,实现精准构图:

| 控制类型 | 说明 |

|---|---|

| Canny 边缘控制 | 根据边缘图生成风格一致的动态画面 |

| Depth 深度图控制 | 控制场景空间结构与远近关系 |

| Pose 骨骼控制 | 实现人物动作精准复现 |

| MLSD 直线检测 | 适用于建筑、室内等结构化场景 |

| 轨迹控制(Trajectory Control) | 新增功能,可指定物体运动路径,提升动态可控性 |

这些控制能力让模型从“自由发挥”走向“按需生成”,极大提升了在动画、广告、影视预演等专业场景中的可用性。

3. 首尾帧预测(InP)

InP 模型支持“首尾图引导”生成:

- 提供起始帧与结束帧

- 模型自动补全中间过渡动画

- 适用于转场设计、形态变化类视频生成

4. 多语言支持

模型在训练中融合多语言文本数据,支持中文、英文等多种语言 prompt 输入,降低非英语用户的使用门槛。

⚠️ 显存要求高,本地部署门槛大

两个模型均为 47GB 的 FP16 权重文件,这意味着:

- ❌ 单卡消费级显卡基本无法本地部署

- ✅ 推荐使用阿里云 PAI 平台或具备多卡 A100/H100 的服务器环境

即便使用模型分片加载(如 offload),推理速度也将非常缓慢,体验不佳。

显存不足用户的替代方案

对于本地设备有限的用户,推荐使用社区开发者 Kijai 提供的优化版本与工具链:

推荐组合:轻量化 + 加速 + 易用

| 组件 | 说明 |

|---|---|

| FP8 量化版 Wan2.2-Fun | 由 Kijai 释出,将模型精度降至 FP8,显著降低显存占用 |

| ComfyUI-WanVideoWrapper | Kijai 开发的 ComfyUI 插件,提供图形化界面支持 Wan 系列视频模型 |

| 加速 LoRA | Kijai已发布多个轻量 LoRA,用于提升生成速度或稳定动作序列 |

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...