在视频编辑中,目标移除是一项关键任务:从视频中删除指定对象(如行人、车辆、水印),同时保持背景的视觉一致性与时间连贯性。然而,现有方法常面临三大挑战:

- 生成伪影或“幻觉对象”

- 推理速度慢,依赖高步数采样与 CFG(分类器自由引导)

- 在噪声扰动下鲁棒性差

为解决这些问题,香港中文大学、深圳大学、云天励飞、星尘智能与香港大学的研究团队联合提出 MiniMax-Remover —— 一种基于极小极大优化的两阶段视频目标移除框架。

- 项目主页:https://minimax-remover.github.io

- GitHub:https://github.com/zibojia/MiniMax-Remover

- 模型:https://huggingface.co/zibojia/minimax-remover

- Demo:https://huggingface.co/spaces/zibojia/MiniMax-Remover

它通过模型简化 + 对抗性蒸馏策略,在仅 6 步推理、无需 CFG 的条件下,实现高质量、高鲁棒性的视频修复,显著优于现有方法。

核心优势

| 特性 | 说明 |

|---|---|

| ⚡ 极速推理 | 仅需 6 步采样,无需 CFG,适合实时编辑场景 |

| 🎯 高质量生成 | 有效避免伪影与虚假对象,背景重建自然 |

| 🔒 强鲁棒性 | 在不同噪声条件下保持稳定输出 |

| 🧠 无需文本输入 | 移除交叉注意力与文本编码器,降低复杂度 |

方法概览:两阶段极小极大优化

MiniMax-Remover 采用两阶段训练框架,灵感来源于极小极大博弈思想:

- “极小”阶段:生成器尽可能修复被遮挡区域

- “极大”阶段:引入挑战性噪声,迫使模型在恶劣条件下仍能输出高质量结果

最终得到一个轻量、高效、抗干扰能力强的移除模型。

第一阶段:简化架构 + 对比条件控制

🏗️ 模型基础

- 基于预训练视频生成模型 Wan2.1-1.3B

- 移除文本输入与交叉注意力层,转为纯掩码驱动

- 显著降低模型复杂度,提升推理效率

🔍 引入对比条件标记(Contrastive Condition Tokens)

传统方法依赖文本提示或复杂注意力机制,MiniMax-Remover 改用两种可学习的条件标记:

| 标记类型 | 作用 |

|---|---|

| 正标记(Positive Token) | 引导模型移除目标对象 |

| 负标记(Negative Token) | 防止在掩码区域内生成虚假内容(如多出一个人) |

通过正负信号的对比监督,模型学会“该补什么、不该补什么”。

📈 训练策略

- 使用随机选取的无关视频掩码与精确目标掩码交替训练

- 增强模型对不同遮挡模式的泛化能力

- 学习在多样化背景下重建自然场景

第二阶段:对抗性优化蒸馏

这是 MiniMax-Remover 的核心创新。

⚔️ 构建“坏噪声”(Bad Noise)

在推理过程中,传统方法假设噪声服从标准分布(如高斯)。但实际应用中,输入常受压缩、传输或编码影响,存在非理想噪声。

MiniMax-Remover 主动寻找这些“坏噪声”——即最容易导致伪影或结构崩塌的噪声样本。

🔄 极小极大训练循环

- 最大化阶段(Max):搜索一组最具破坏性的噪声(对抗样本)

- 最小化阶段(Min):用这些噪声训练移除器,使其在挑战条件下仍能生成高质量结果

这一过程类似于“压力测试”,让模型在最差情况下也能表现稳健。

✅ 最终输出

- 移除 CFG(无需重复采样)

- 支持 6 步极低步数推理

- 模型更小、更快、更稳定

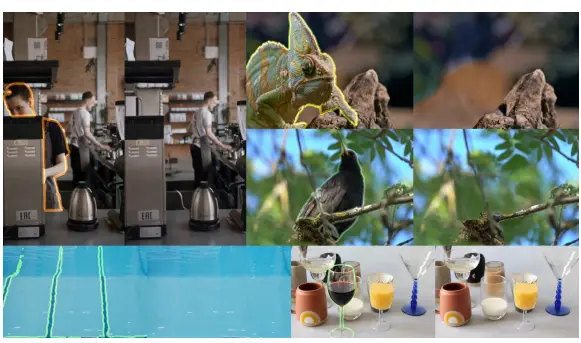

实验结果:全面领先

📊 定量评估

在多个标准数据集上,MiniMax-Remover 显著优于现有方法:

| 指标 | DAVIS 数据集 | Pexels 数据集 |

|---|---|---|

| SSIM | 0.9847(SOTA) | 最高 |

| PSNR | 36.66(SOTA) | 最高 |

| 时间一致性 | — | 显著优于对比方法 |

SSIM 接近 1.0 表示高度保真,PSNR 超 36dB 表明几乎无可见失真

🤖 GPT-O3 自动评估

使用大模型进行视觉质量打分(GPT-O3):

- 平均评分:6.48 / 10

- 成功移除率:91.11%

- 远超其他基线方法

👥 用户研究(定性评估)

在盲测中,用户被要求从多个方法生成的结果中选择最优视频:

- MiniMax-Remover 获得 最高偏好得分

- 用户普遍反馈其“背景自然”“无明显拼接痕迹”“运动连贯”

🛡️ 鲁棒性测试

在不同噪声水平(如 JPEG 压缩、高斯噪声、传输丢包模拟)下:

- 其他方法出现明显伪影或结构错乱

- MiniMax-Remover 仍能保持高质量输出,验证了对抗训练的有效性

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...