你是否想象过这样的场景?

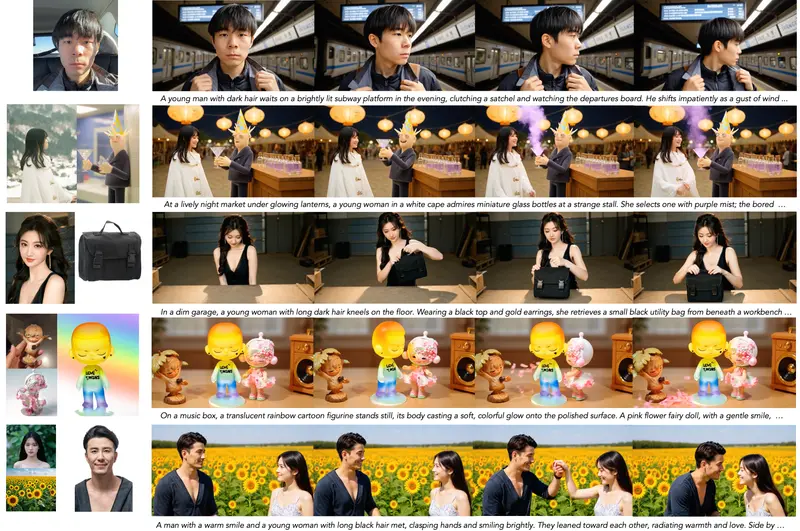

- 输入一段语音,AI 自动生成人物说话的视频,唇形精准对齐,表情自然生动;

- 给一张静态肖像,加上一句“他开始微笑并挥手”,画面立刻动起来;

- 结合提示词和参考图,生成一段人物动作连贯、背景稳定的短视频。

这些不再是多个独立模型拼凑的结果。蚂蚁集团支付宝终端技术部最新推出的 EchoMimicV3,在一个仅 1.3B 参数的统一模型中,实现了音频、文本、图像等多种模态驱动下的高质量人体动画生成。

- 项目主页:https://antgroup.github.io/ai/echomimic_v3

- GitHub:https://github.com/antgroup/echomimic_v3

- 模型:Hugging Face | 魔塔

它不是简单的功能叠加,而是一次架构级的重构——通过“任务混合”与“模态混合”的协同设计,让一个轻量模型胜任过去需要多个专用模型才能完成的任务。

核心突破:从“多模型”到“一模型多任务多模态”

以往的人体动画生成系统通常面临两个困境:

- 模型碎片化:每个任务(如唇形同步、图像驱动动作)都需要单独训练和部署模型;

- 模态割裂:音频、文本、图像等条件难以有效融合,导致生成结果不一致或动作僵硬。

EchoMimicV3 的目标正是打破这一局面。它将多种任务统一建模为空间-时间序列重建问题,在单一模型中实现:

- 文本到视频(T2V)

- 图像到视频(I2V)

- 音频到视频(A2V)

- 多条件联合驱动(如“音频+提示词+参考图”)

无需切换模型,也不需复杂调度,所有任务由同一个轻量级网络完成。

三大核心技术设计

1. Soup-of-Tasks:任务混合范式

传统做法是为每种任务训练独立模型。EchoMimicV3 则采用 任务混合输入机制,通过掩码控制告诉模型当前执行哪种任务。

更关键的是,它引入了一种反直觉的任务分配策略:在训练时故意混入错误任务标签的样本,迫使模型学会从输入内容本身判断任务类型,而非依赖标签记忆。

这不仅提升了泛化能力,还避免了多模型带来的部署复杂性。

2. Soup-of-Modals:模态混合范式

面对音频、文本、图像等不同模态输入,EchoMimicV3 提出两个核心模块:

✅ 耦合-解耦交叉注意力(CDCA)

- 在早期层进行耦合注意力,捕捉模态间的强关联(如语音与唇动);

- 在深层改为解耦注意力,允许各模态独立影响输出,防止干扰。

✅ 时间步相位感知动态分配(Multi-Modal PhDA)

不同模态在视频生成的不同阶段起主导作用。例如:

- 初始帧更依赖参考图像;

- 中间说话过程由音频主导;

- 动作趋势由文本提示引导。

PhDA 机制能根据当前生成的“时间相位”,动态调整各模态的权重,实现更自然的过渡。

3. 训练与推理优化:提升稳定性与连贯性

🔁 Negative DPO-SFT 循环训练

结合监督微调(SFT)与负向直接偏好优化(Negative DPO),利用无配对的负样本(如错位音画)训练模型主动拒绝不良分布,增强鲁棒性。

🎯 Phase-aware Negative CFG(PNG)

在推理阶段,引入相位感知负分类器自由引导,在关键时间点(如口型变化)抑制不合理的生成结果。

📏 Long Video CFG

针对长视频生成中的漂移问题(如身份变形、背景闪烁),设计专门的引导策略,保持长时间一致性。

工作流程简述

EchoMimicV3 的运行流程高度统一:

- 输入整合

将音频、文本提示、参考图像等编码为统一表示,配合任务掩码输入模型。 - 多模态融合

通过 CDCA 和 PhDA 模块动态融合各模态信息,生成时空潜变量。 - 视频解码

由解码器生成高分辨率视频帧,支持从首尾帧或单图生成完整动作序列。 - 质量控制

在推理阶段启用 PNG 和 Long Video CFG,确保输出稳定、连贯。

整个过程无需模型切换,真正实现“一模型通吃”。

性能表现:小模型,大能力

| 指标 | 表现 |

|---|---|

| 模型规模 | 仅 1.3B 参数(约为同类模型的 1/10) |

| 推理速度 | 比 14B 模型快 18 倍,适合实时应用 |

| FID / FVD | 在多个数据集上优于或媲美更大模型 |

| ASE(音频-唇动同步误差) | 显著低于基线,口型对齐更精准 |

| IQA(视频质量评分) | 用户调研中得分更高,画面更自然 |

✅ 多任务能力验证

- 唇部同步:语音驱动下唇形准确率高,无延迟或抖动;

- 图像到视频:保留原始身份特征,动作自然过渡;

- 长视频生成:支持数十秒连贯输出,无明显颜色偏移或结构崩塌。

为什么这很重要?

EchoMimicV3 的意义不仅在于性能提升,更在于它展示了轻量化、统一化人体动画生成的可行路径。

对于实际应用而言:

- 更低部署成本:1.3B 模型可在边缘设备运行;

- 更高灵活性:支持任意模态组合输入,适应多样化场景;

- 更强可控性:通过提示词精确控制动作语义。

它已在支付宝内部用于虚拟客服、数字人交互等场景,未来也有望应用于在线教育、直播、社交娱乐等领域。

结语

EchoMimicV3 并未追求参数规模的膨胀,也没有堆砌复杂的外部模块。它的突破来自于对任务本质的重新理解——将人体动画视为一个可统一建模的时空重建问题,并通过任务与模态的双重混合机制,实现了效率与质量的平衡。

从 V1 到 V3,蚂蚁终端技术团队持续迭代,正在构建一条通往“实时、可控、轻量”数字人生成的技术路径。

而 EchoMimicV3 的出现,或许意味着:高质量人体动画,正从“专用系统”走向“通用服务”。

相关文章