近年来,对比语言-图像模型(如CLIP)在多模态任务中表现出色,成为学习视觉表征的主流选择。这些模型通过大规模的图像-文本对进行训练,利用语言监督来融入语义信息,广泛应用于视觉问答(VQA)、文档理解等领域。然而,这种依赖语言的方式也带来了诸多挑战:获取高质量的对齐数据集成本高昂,可扩展性受限,并且对于某些任务,语言是否真的不可或缺仍存疑问。

- GitHub:https://github.com/facebookresearch/webssl

- 模型:https://huggingface.co/collections/facebook/web-ssl-68094132c15fbd7808d1e9bb

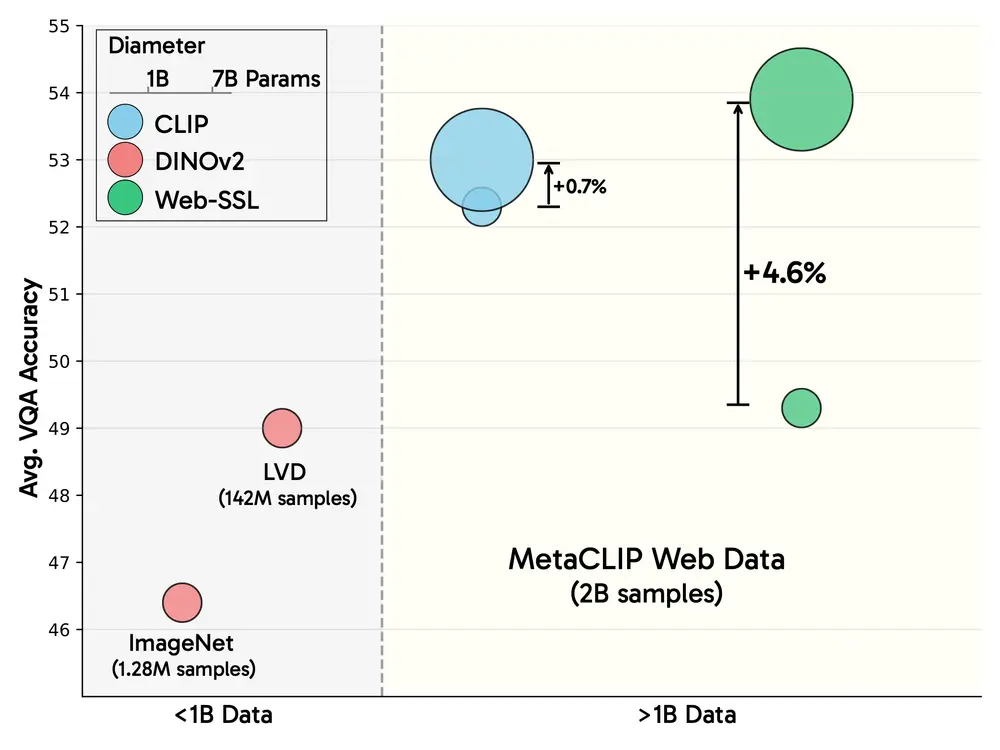

相比之下,视觉自监督学习(SSL)无需语言监督,在分类和分割等任务中表现不俗。但长期以来,它在多模态推理任务(如OCR和图表理解)中的性能始终不及语言驱动的方法。为了验证视觉自监督学习在更大规模下的潜力,Meta推出了Web-SSL系列模型,参数范围从3亿到70亿不等,现已通过Hugging Face开源发布。

Web-SSL:无语言视觉学习的新尝试

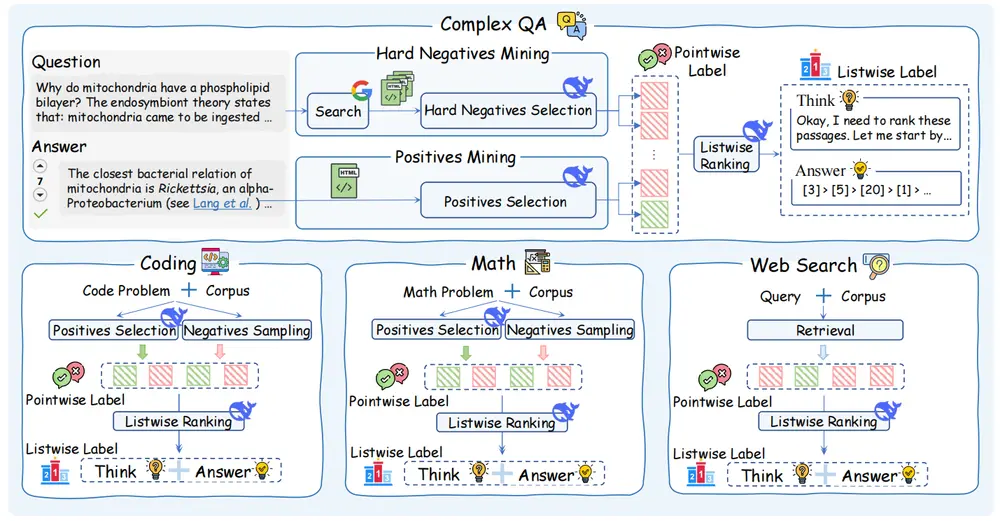

Web-SSL是一系列基于DINO和Vision Transformer(ViT)的模型,仅使用未标记的图像数据进行训练。这些模型在MetaCLIP数据集(MC-2B)的图像子集上完成预训练,这是一个包含20亿张图像的网络规模数据集。通过与CLIP在同一数据集上的对比实验,Web-SSL旨在探索无语言监督的视觉学习方法在大规模场景下的表现。

此次发布的重点不是取代CLIP,而是评估当模型规模和数据量不再受限时,纯粹的视觉自监督学习能达到何种高度。这为理解语言监督是否是训练高性能视觉编码器的必要条件提供了重要参考。

技术架构与训练方法

Web-SSL结合了两种主流的视觉自监督学习范式:

联合嵌入学习(通过DINOv2):通过对比学习将不同增强视图的嵌入拉近。 掩码建模(通过MAE):通过重建被遮挡的部分学习图像特征。

所有模型均遵循标准化的训练协议,输入分辨率为224x224,并在下游任务评估中保持冻结的视觉编码器,以确保结果差异完全归因于预训练方法的不同。

模型在五个容量级别(ViT-1B至ViT-7B)上进行了训练,仅使用MC-2B中的未标记图像数据。评估则通过Cambrian-1基准测试套件完成,该套件涵盖16项VQA任务,包括通用视觉理解、基于知识的推理、OCR以及图表解释等复杂场景。

此外,Web-SSL模型已集成到Hugging Face的transformers库中,提供开箱即用的检查点,便于研究人员快速接入和实验。

关键发现:无语言学习的优势与潜力

实验结果揭示了多个重要结论:

1. 模型规模的缩放效应

随着模型参数数量的增加,Web-SSL在VQA任务中的表现呈现接近对数线性的提升。相比之下,CLIP的性能在超过30亿参数后趋于平稳。在大规模视觉中心任务和OCR、图表相关任务中,Web-SSL的表现尤为突出,缩小了与语言驱动模型的差距。

2. 数据组成的重要性

通过对训练数据的过滤,仅保留包含少量富文本图像的数据(约占总数据的1.3%),Web-SSL在OCR和图表任务上的性能显著优于CLIP。例如,在OCRBench和ChartQA基准测试中,Web-SSL实现了高达**+13.6%**的性能提升。这表明,即使没有语言标签,图像中视觉文本的存在本身也能显著增强特定任务的表现。

3. 高分辨率微调的效果

在518像素分辨率下微调的Web-SSL模型进一步缩小了与SigLIP等高分辨率模型在文档密集型任务中的性能差距。这说明适当提高输入分辨率可以显著改善模型在细节敏感任务中的表现。

4. 隐式的语义对齐能力

尽管完全没有语言监督,随着模型规模和训练数据量的增加,Web-SSL展现出与预训练语言模型(如LLaMA-3)更好的对齐能力。这种涌现行为表明,更大的视觉模型能够隐式学习与文本语义高度相关的特征。

传统任务中的表现

除了在多模态任务中的优异表现,Web-SSL在传统视觉任务中同样表现出色。例如,在ImageNet-1k分类、ADE20K分割和NYUv2深度估计等基准测试中,Web-SSL的表现通常优于MetaCLIP甚至DINOv2,证明其在基础视觉任务中的鲁棒性。

未来多模态系统的开源基础

Meta发布的Web-SSL系列模型为研究社区提供了一个强大的工具,使更多人能够在无需配对数据或专有管道限制的情况下探索无语言视觉学习的潜力。这些模型不仅适用于学术研究,也为实际应用提供了灵活的选择。

通过这次发布,Meta展示了视觉自监督学习在大规模场景下的强大能力,挑战了语言监督对于多模态理解至关重要的传统假设。未来,随着模型规模的进一步扩大和训练数据的优化,无语言视觉学习可能会在更多领域展现其独特价值。

相关文章