在大模型持续演进的过程中,如何在提升性能的同时控制资源消耗,成为行业面临的关键挑战。腾讯最新推出的 Hunyuan-A13B 模型,正是这一问题的创新性解决方案。该模型采用混合专家(MoE)架构,在仅激活 130 亿参数的情况下,展现出媲美更大规模模型的能力,为研究者与开发者提供了兼具高效能与高性价比的新选择。

- GitHub:https://github.com/Tencent-Hunyuan/Hunyuan-A13B

- 模型:https://huggingface.co/tencent/Hunyuan-A13B-Instruct

- Demo:https://hunyuan.tencent.com/?model=hunyuan-a13b

核心特性一览

小参数量,高性能

尽管总参数高达 800 亿,但 Hunyuan-A13B 在推理时仅激活其中的 130 亿参数。这种“按需激活”的机制使其在多个基准任务中表现优异,甚至超越了一些更大参数量的模型。

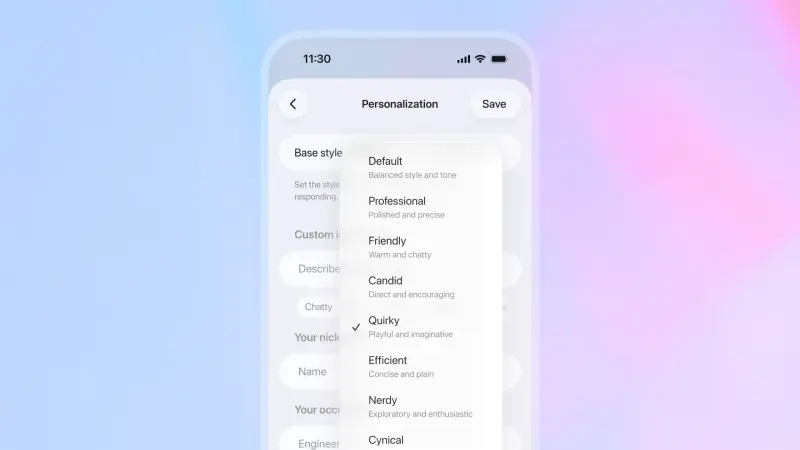

支持多种推理模式

Hunyuan-A13B 提供快思考与慢思考两种推理模式,用户可根据具体需求灵活切换,兼顾效率与精度。

长文本处理能力

模型原生支持 256K 上下文长度,在长文档理解、复杂对话等任务中表现出稳定的性能。

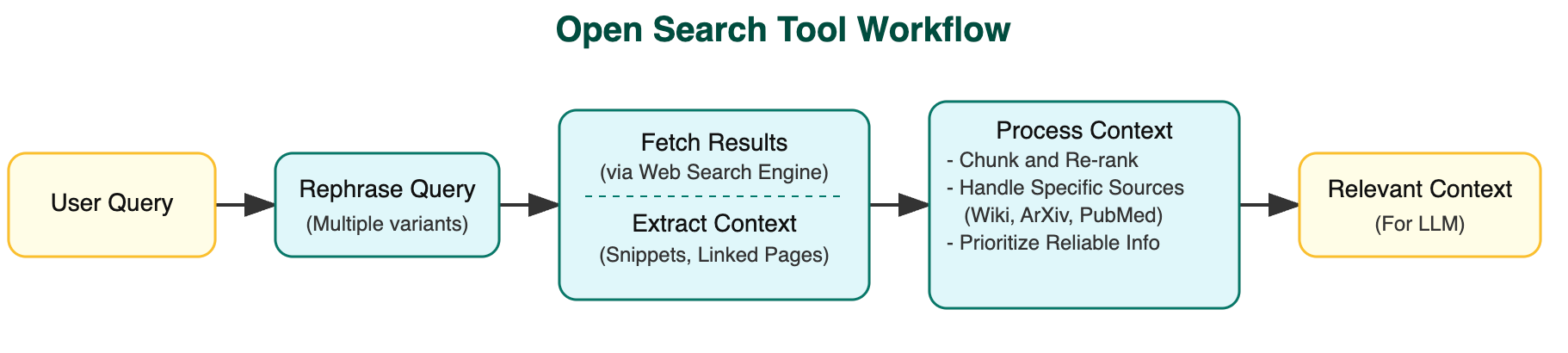

强化Agent能力

在 BFCL-v3、τ-Bench、C3-Bench 等智能体评估基准上,Hunyuan-A13B 表现出领先优势,适用于构建高效的 AI Agent 应用。

高效推理设计

通过分组查询注意力(GQA)策略与多量化格式支持,模型实现了更高的推理效率,适合部署在资源受限场景。

为何选择 Hunyuan-A13B?

对于研究者和开发者而言,Hunyuan-A13B 是一个理想的平衡点:它不仅具备强大的建模能力,同时在计算资源上的开销相对可控。无论是在学术研究、开发高性价比的 AI 解决方案,还是探索新的应用场景中,这款模型都能提供坚实的技术支撑。

模型结构详解

Hunyuan-A13B 采用细粒度混合专家(Fine-grained MoE)架构,总计训练了超过 20T tokens,其核心结构如下:

| 参数项 | 数值 |

|---|---|

| 总参数量 | 80B |

| 激活参数量 | 13B |

| 层数 | 32 |

| Attention Heads | 32 |

| 共享专家数 | 1 |

| 非共享专家数 | 64 |

| 路由策略 | Top-8 |

| 激活函数 | SwiGLU |

| 隐层维度 | 4096 |

| 专家隐层维度 | 3072 |

此外,模型支持长达 256K 的上下文窗口,进一步增强了对长文本的理解能力。

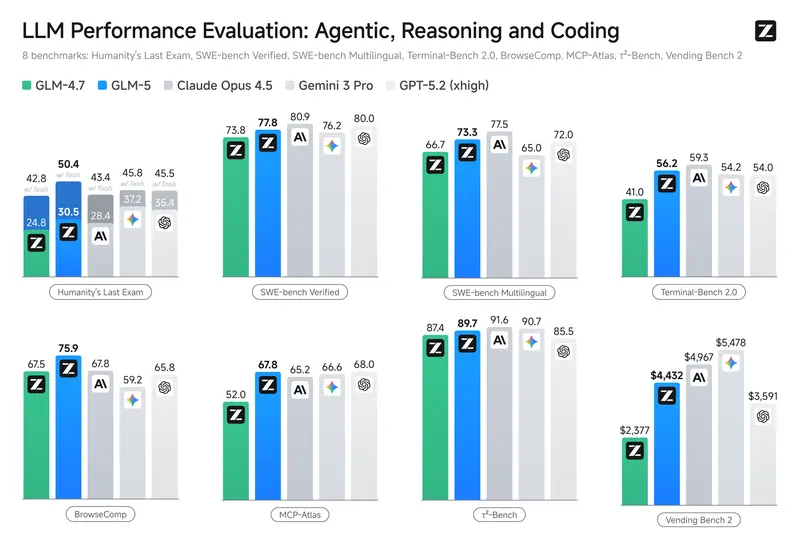

Benchmark测试表现

预训练阶段表现

在预训练任务中,Hunyuan-A13B-Pretrain 在 14 个任务中的 12 项超越了前代模型 Hunyuan-Large(激活参数达 520 亿),展现了更强的学习能力和泛化能力。

与其他大型密集模型和 MoE 模型相比,Hunyuan-A13B 在代码生成、数学推理等多个任务中均取得领先成绩。在 MMLU、MMLU-PRO 等综合评测中,其表现与 Qwen3-A22B 相当,显示出全面的竞争力。

| Model | MMLU | MMLU-Pro | BBH | EvalPlus | MultiPL-E | MBPP | MATH | GSM8k | GPQA |

|---|---|---|---|---|---|---|---|---|---|

| Hunyuan-Large | 88.40 | 60.20 | 86.30 | 75.69 | 59.13 | 72.60 | 69.80 | 92.80 | 25.18 |

| Qwen2.5-72B | 86.10 | 58.10 | 85.80 | 65.93 | 60.50 | 76.00 | 62.12 | 91.50 | 45.90 |

| Qwen3-A22B | 87.81 | 68.18 | 88.87 | 77.60 | 65.94 | 81.40 | 71.84 | 94.39 | 47.47 |

| Hunyuan-A13B | 88.17 | 67.23 | 87.56 | 78.64 | 69.33 | 83.86 | 72.35 | 91.83 | 49.12 |

指令微调后表现

在指令微调阶段,Hunyuan-A13B-Instruct 在数学、科学、编程、推理等多个领域都展现出极强的竞争力,尤其在 Agent 相关任务中表现突出。

| 领域 | 测试项目 | Hunyuan-A13B-Instruct |

|---|---|---|

| 数学 | AIME 2024 / AIME 2025 / MATH | 87.3 / 76.8 / 94.3 |

| 科学 | GPQA-Diamond / OlympiadBench | 71.2 / 82.7 |

| 编程 | Livecodebench / Fullstackbench | 63.9 / 67.8 |

| 推理 | BBH / DROP / ZebraLogic | 89.1 / 91.1 / 84.7 |

| 指令遵循 | IF-Eval / SysBench | 84.7 / 76.1 |

| 文本生成 | LengthCtrl / InsCtrl | 55.4 / 71.9 |

| 自然语言理解 | ComplexNLU / Word-Task | 61.2 / 62.9 |

| Agent能力 | BFCL v3 / τ-Bench / C3-Bench | 78.3 / 54.7 / 63.5 |

相关文章