智谱AI正式推出新一代通用大模型——GLM-5,这款模型在设计之初就明确了核心定位:面向复杂系统工程和长周期智能体任务,致力于打破基础模型“只能聊天、难以落地”的局限,实现从“氛围编程”到“智能体工程”的跨越。

- 项目主页:https://z.ai/blog/glm-5

- GitHub:https://github.com/zai-org/GLM-5

- 模型:https://huggingface.co/zai-org/GLM-5

- Coding Plan :https://z.ai/subscribe

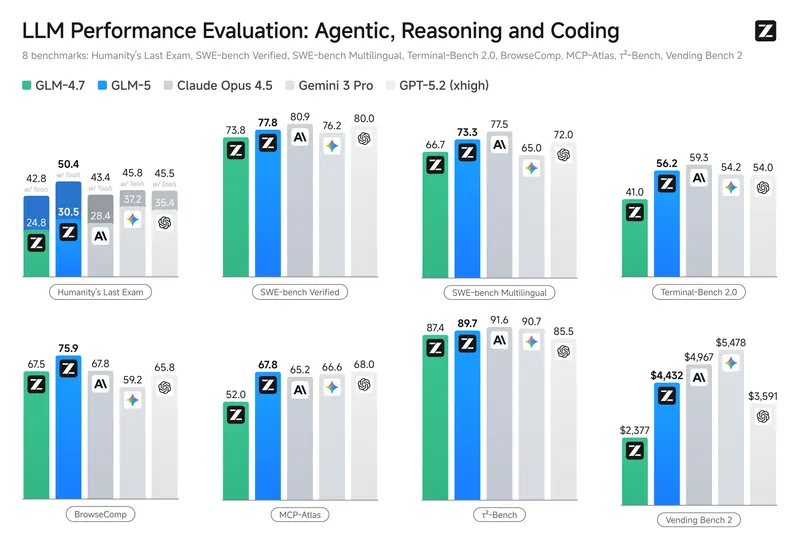

相较于上一代产品,GLM-5在模型规模、训练效率、部署成本、实用能力以及生态兼容等多个核心维度实现全面升级,最终凭借卓越的表现,成为当前所有开源模型中,在推理、编码和智能体任务上表现最佳的方案,同时进一步缩小了与行业前沿闭源模型之间的差距,为开发者、企业用户提供了更强大、更易用、更具性价比的AI生产力工具。

模型核心升级:规模与效率双突破,兼顾性能与部署成本

在通用人工智能的发展进程中,模型规模的合理扩展,始终是提升模型智能效率、拓宽能力边界的关键路径之一。GLM-5在上一代GLM-4.5的基础上,进行了全方位的规模扩容与技术优化,既保证了性能的跨越式提升,又通过创新技术解决了大规模模型部署成本过高的痛点。

具体来看,GLM-5的核心规模升级主要体现在三个方面:

- 参数量大幅提升:GLM-4.5的参数量为355B(其中激活参数量为32B),而GLM-5直接将参数量扩展至744B,激活参数量同步提升至40B,更大的参数量为模型承载更复杂的任务、学习更丰富的知识提供了坚实基础,让模型在处理长文本、复杂逻辑推理、多步骤任务时更具优势。

- 预训练数据量显著增加:预训练数据的质量与数量,直接决定了模型的知识储备和泛化能力。GLM-5的预训练数据从GLM-4.5的23T token,增加至28.5T token,新增的5.5T token涵盖了更多行业场景、专业领域的知识,进一步丰富了模型的知识体系,提升了模型在垂直领域的适配能力。

- 稀疏注意力技术优化部署体验:大规模模型往往面临部署成本高、资源消耗大的问题,为了解决这一痛点,GLM-5集成了DeepSeek稀疏注意力技术。这项技术的核心优势的是,在不降低模型长上下文处理能力的前提下,大幅减少模型推理过程中的计算量和资源消耗,从而显著降低了GLM-5的部署成本,让更多中小企业、开发者能够轻松部署和使用这款大规模模型。

全新异步强化学习基础设施:slime,破解大规模RL训练难题

强化学习(RL)是提升大模型能力的关键技术之一,其核心价值在于能够弥合预训练模型从“胜任任务”到“卓越完成任务”之间的差距,通过持续的反馈与迭代,优化模型的输出质量和任务适配能力。然而,传统强化学习技术在大规模语言模型上的部署,一直面临着训练效率低下、吞吐量不足、后训练迭代困难等问题,严重限制了强化学习在大规模模型上的应用效果。

为了解决这一行业痛点,智谱AI专门为GLM-5研发了一款新颖的异步强化学习基础设施——slime。这款基础设施经过针对性优化,完美适配GLM-5的大规模架构,其核心优势主要体现在两个方面:

- 大幅提升训练吞吐量与效率:slime通过异步训练架构的设计,打破了传统强化学习训练过程中的瓶颈,能够高效利用计算资源,显著提升训练吞吐量,让GLM-5的强化学习训练效率得到质的飞跃,缩短了模型的迭代周期。

- 支持更精细的后训练迭代:slime基础设施能够实现更精细的训练控制,让研发团队可以根据模型的表现,进行针对性的后训练优化,不断调整模型参数,提升模型在特定任务上的表现。正是得益于slime的支持,GLM-5在广泛的学术基准测试中,相比上一代GLM-4.7取得了显著提升,尤其在推理、编码和智能体任务上,表现超越了所有开源模型,进一步缩小了与前沿闭源模型的差距。

能力实测:复杂工程与长周期智能体表现领先,用数据证明实力

GLM-5的核心定位是面向复杂系统工程和长周期智能体任务,因此,模型的实际表现不仅需要通过学术基准来验证,更需要在贴近真实应用场景的测试中,证明其解决实际问题的能力。为此,智谱AI通过多项权威基准测试,全面验证了GLM-5在复杂任务处理、长期规划、资源管理等方面的实力,测试结果均表现优异。

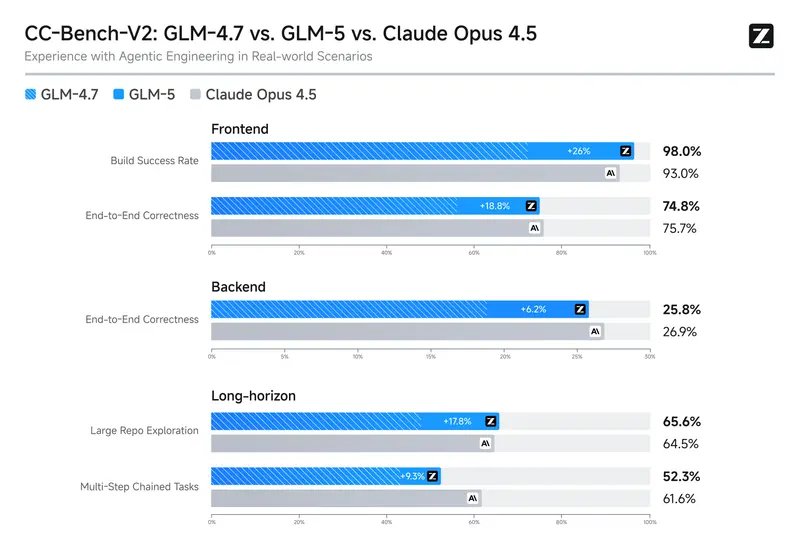

1. CC-Bench-V2 内部评估套件:复杂系统工程能力显著提升

CC-Bench-V2是智谱AI自研的内部评估套件,专门用于测试大模型在复杂系统工程任务中的表现,测试范围涵盖前端开发、后端开发以及长周期复杂任务三大核心维度,能够全面反映模型的工程实践能力和复杂逻辑处理能力。

测试结果显示,GLM-5在这三个维度上的表现均显著超越了上一代GLM-4.7,无论是前端页面开发的精准度、后端接口的稳定性,还是长周期复杂任务的推进效率和完成质量,都有了跨越式提升。同时,GLM-5与行业前沿闭源模型Claude Opus 4.5之间的差距也进一步缩小,成为目前开源模型中,复杂系统工程能力最强的模型之一。

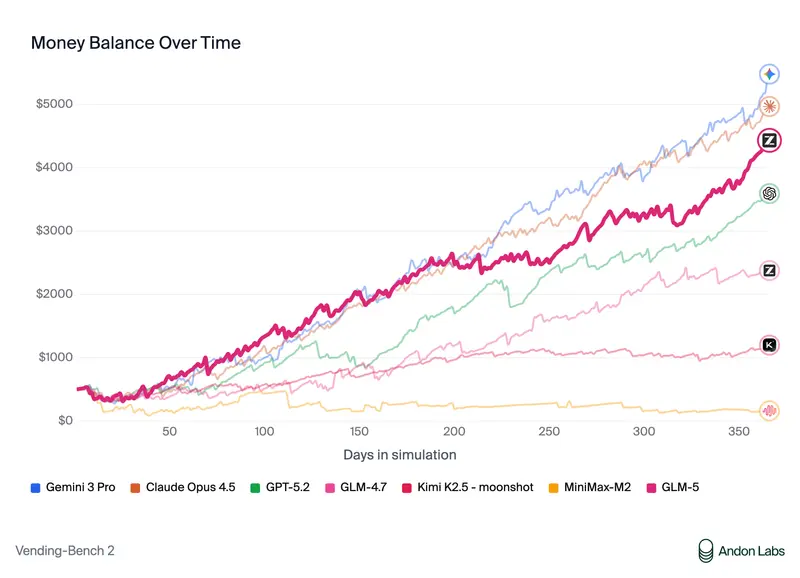

2. Vending Bench 2 长期运营基准:长周期智能体能力登顶开源第一

Vending Bench 2是行业内衡量大模型长期规划、持续决策和资源管理能力的权威基准测试,其测试场景高度贴近真实业务,能够有效验证模型在长周期任务中的表现。该测试的核心任务是:让模型在模拟环境中,独立运营一家自动售货机业务,运营周期长达一年,模型需要全程负责货物采购、定价策略、库存管理、成本控制等所有环节,最终以账户余额作为核心评估指标。

在这项测试中,GLM-5展现出了极强的长期规划和资源管理能力,最终实现的账户余额达到4,432美元,这一成绩不仅在所有参与测试的开源模型中排名第一,更接近闭源模型Claude Opus 4.5的表现。这一结果充分证明,GLM-5能够胜任长周期、多步骤、强逻辑、高不确定性的真实业务类任务,具备极强的落地价值。

从“聊天”到“工作”:办公套件能力全面落地,打造实用生产力工具

当前,基础模型的发展正经历一场重要的转型——从单纯的“聊天交互”,转向“赋能工作生产”,成为知识工作者的必备生产力工具,就像面向知识工作者的Office办公软件、面向工程师的专业编程工具一样,AI模型正在深度融入各类工作场景,提升工作效率、降低工作成本。

智谱AI在这一转型趋势中,始终走在行业前列:GLM-4.5作为过渡性产品,实现了模型在推理、编码、智能体方向的初步突破,让模型具备了完成复杂任务的基础能力;而GLM-5则在GLM-4.5的基础上,进一步强化了复杂系统工程和长周期智能体能力,同时重点优化了办公落地能力,让模型能够直接产出可交付的工作成果,真正实现从“聊天”到“工作”的跨越。

核心办公能力:直接生成可交付文档,端到端完成工作任务

GLM-5最具实用性的升级之一,就是能够直接将用户输入的文本、需求描述或原始素材,一键转化为标准格式的可交付文档,无需用户进行二次排版、修改,真正实现端到端的工作交付,大幅提升工作效率。

具体来说,GLM-5支持生成的文档格式包括.docx(Word文档)、.pdf(PDF文档)和.xlsx(Excel表格),覆盖的工作场景十分广泛,主要包括:

- 企业办公场景:产品需求文档(PRD)、财务报告、工作总结、会议纪要、流程图表等;

- 教育教学场景:教案、课件、各类试卷、知识点总结等;

- 日常工作场景:电子表格统计、菜单设计、简历制作、通知公告等。

无论是复杂的产品需求文档,还是数据繁多的Excel统计表格,GLM-5都能根据用户的需求,精准生成符合行业规范、格式标准的文档,用户可以直接将生成的文档用于工作交付,无需花费额外时间进行排版和修改,极大地节省了工作时间和人力成本。

Z.ai 官方应用:智能体模式上线,强化多轮协作与成果交付

为了让GLM-5的办公能力和智能体能力得到更好的落地,智谱AI的官方应用Z.ai同步推出了智能体模式,这款模式专门针对复杂工作任务设计,内置了PDF、Word、Excel等多种文档的创建技能,能够支持用户进行多轮协作式任务处理,真正将模型的对话输出,转化为可落地、可交付的工作成果。

例如,用户可以通过Z.ai的智能体模式,与GLM-5进行多轮沟通,逐步明确产品需求,模型会根据用户的每一次反馈,不断优化产品需求文档的内容,最终生成一份完整、规范的PRD文档;同时,用户还可以邀请团队成员一起参与协作,共同优化文档内容,提升工作效率和成果质量。相较于传统的聊天模式,智能体模式更注重任务的推进和成果的交付,更贴合实际工作场景的需求。

GLM-5 全渠道使用指南:多入口适配,覆盖各类用户需求

为了让不同类型的用户(开发者、企业用户、普通用户)都能轻松体验和使用GLM-5,智谱AI已开放了多渠道的使用入口,全面覆盖在线试用、编码智能体集成、API调用、本地私有化部署等多种场景,同时适配不同的硬件环境,最大限度地降低了用户的使用门槛。

1. 编码计划:在主流编码智能体中使用GLM-5,提升编码效率

GLM-5在编码任务上的表现处于开源模型领先水平,为了方便开发者在日常编码工作中使用,GLM-5已全面支持各类主流编码智能体,包括Claude Code、OpenCode、Kilo Code、Roo Code、Cline、Droid等,开发者可以在自己熟悉的编码智能体中,直接调用GLM-5,借助模型的强大编码能力,提升编码效率、优化代码质量。

不同计划用户的启用方式和开放进度有所不同,具体说明如下:

- Max 计划用户:无需等待,现在即可通过修改模型配置,将模型名称更新为“GLM-5”来启用GLM-5。例如,在Claude Code中,只需修改~/.claude/settings.json文件中的模型名称,即可完成启用,立即体验GLM-5的编码能力。

- GLM 编码计划订阅用户:由于GLM-5的计算资源消耗相对较大,目前受限于计算资源,智谱AI正在逐步向编码计划订阅用户推出GLM-5,后续将根据算力调配情况,逐步扩大开放范围,确保每一位订阅用户都能获得良好的使用体验。

- 其他计划层级用户:随着GLM-5部署范围的不断扩大,智谱AI将逐步增加对其他计划层级用户的支持,具体开放时间将通过官方渠道及时通知,用户可持续关注官方动态。

需要特别提醒的是,由于GLM-5的参数量更大、能力更强,请求GLM-5所消耗的计划配额,会比请求GLM-4.7更多,用户在使用过程中,可以根据自己的配额情况,合理安排使用频率。

如果开发者偏好图形化界面,智谱AI还提供了Z Code这一专用工具——Z Code是一款智能体化开发环境,能够让开发者直接控制(甚至远程控制)多个智能体,并让这些智能体在复杂的编码任务、工程任务上进行协作,进一步提升开发效率,适合处理多智能体协同的复杂项目。开发者可以通过https://z.ai/subscribe链接,立即开始使用Z Code构建自己的智能体开发项目。

2. OpenClaw 框架:将GLM-5转变为跨设备、跨应用的个人助理

除了编码智能体,GLM-5还全面支持OpenClaw框架——这是一款专门为GLM-5打造的个人助理框架,其核心优势在于,能够将GLM-5从单纯的“聊天模型”,升级为可以跨应用、跨设备操作的个人助理,真正实现“AI赋能生活”。

与传统的聊天模型不同,OpenClaw框架支持GLM-5执行各类跨端操作,例如,控制电脑上的办公软件生成文档、控制手机发送消息、联动智能家居设备进行操作等,让GLM-5真正融入用户的日常工作和生活,成为一款全方位的个人助理。值得一提的是,OpenClaw框架已免费包含在GLM编码计划中,编码计划订阅用户可以直接使用,无需额外付费。

3. Z.ai 在线体验:两种模式可选,适配不同使用场景

对于普通用户、非专业开发者而言,最便捷的使用方式就是通过智谱AI官方应用Z.ai,直接在线体验GLM-5的全部能力。用户只需访问Z.ai平台,即可免费试用GLM-5,若系统未自动将模型切换为GLM-5,用户可以手动在模型选项中,将模型切换为“GLM-5”,即可开始使用。

为了适配不同的使用场景,Z.ai上的GLM-5提供了两种模式,用户可以根据自己的需求灵活选择:

- 聊天模式:主打轻量级交互,能够为用户提供即时响应,适合进行日常对话、问题咨询、简单需求处理等场景,例如,询问知识点、查询信息、简单的文案创作等,操作便捷、响应迅速。

- 智能体模式:主打复杂任务处理,支持多工具调用、多样化技能组合,能够直接为用户交付最终成果,适合进行复杂的文档生成、多步骤任务推进、协作式工作等场景,例如,生成产品需求文档、制作Excel统计表格、规划复杂项目流程等。

4. 本地部署:开源权重+全硬件兼容,满足私有化需求

为了满足企业用户、开发者的私有化部署需求,GLM-5的模型权重已在Hugging Face和ModelScope两大开源平台上公开发布,用户可以直接从这两个平台下载模型权重,进行本地部署。同时,GLM-5对主流的推理框架也提供了全面支持,包括vLLM、SGLang等,这些推理框架能够大幅提升GLM-5的推理速度和部署效率,降低本地部署的技术门槛。

为了方便用户进行本地部署,智谱AI的官方GitHub仓库提供了全面、详细的部署说明,包括环境配置、依赖安装、模型加载、推理测试等各个环节的步骤,即便是非专业的技术人员,也能按照部署说明,顺利完成GLM-5的本地部署。

更值得一提的是,GLM-5不仅支持英伟达芯片的部署,还完成了对多种非NVIDIA芯片的深度适配,涵盖了华为昇腾、摩尔线程、寒武纪、昆仑芯、MetaX、燧原和Hygon等国产芯片和多元硬件平台。通过针对性的内核优化和模型量化技术,GLM-5能够在这些非NVIDIA芯片上,实现合理的推理吞吐量,满足不同企业用户的硬件适配需求,进一步降低了本地部署的硬件成本,推动GLM-5在更多行业、更多场景的落地应用。

相关文章