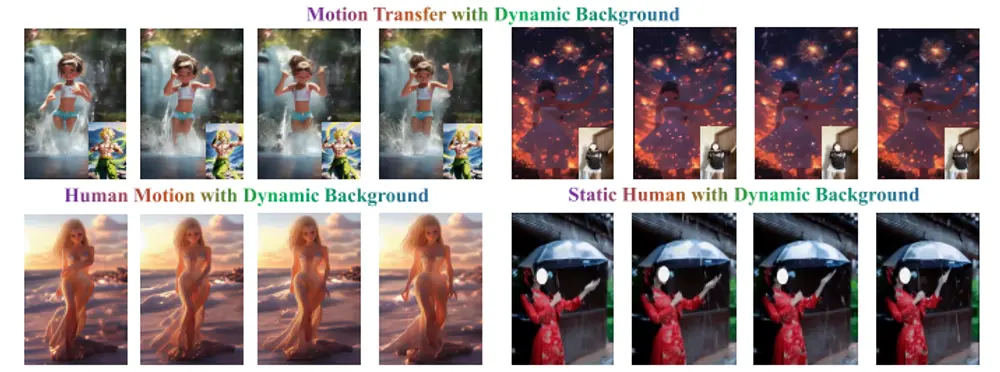

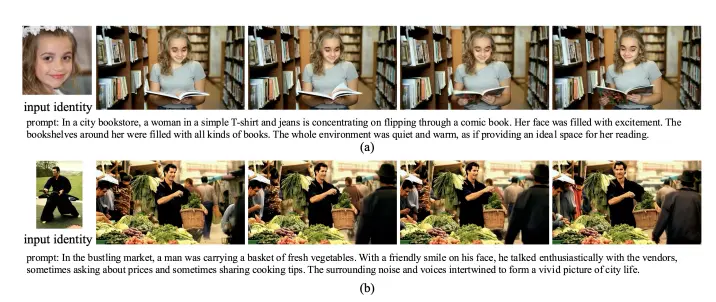

字节跳动推出新型身份保持视频生成方法EchoVideo ,旨在通过多模态特征融合解决传统方法中存在的“复制粘贴”现象和身份相似度低的问题。该方法能够生成高质量、连贯且一致的视频内容,同时保持人物的身份特征,如面部表情、服装和发型等。

例如,我们有一张包含人物面部的照片和一段描述该人物在不同场景中的活动的文本,例如:“一个年轻人在海边散步,随后在咖啡馆里喝咖啡”。传统的视频生成方法可能会在生成的视频中出现面部表情僵硬、背景与人物不匹配等问题。而 EchoVideo 能够生成一段视频,其中人物的面部特征、服装和发型与输入照片保持一致,同时视频内容准确反映了文本描述的场景。

主要功能

- 身份保持:确保生成视频中的人物面部特征、服装和发型与输入图像一致。

- 高质量视频生成:生成的视频具有高分辨率和高质量,能够准确反映文本描述的内容。

- 多模态融合:通过融合文本、图像和面部特征,解决不同模态之间的语义冲突。

- 灵活性:支持通过文本提示控制人物的姿态、表情和场景。

主要特点

- 多模态特征融合模块(IITF):通过融合文本描述、图像语义和面部特征,提取干净的身份信息,避免无关信息(如遮挡、姿势和光照变化)的干扰。

- 两阶段训练策略:在训练的第二阶段引入随机方法,平衡浅层特征的增强和过度依赖,鼓励模型更多地利用高层特征。

- 插件式设计:IITF模块设计为可插拔,能够无缝集成到其他预训练的生成模型中。

- 解决“复制粘贴”问题:通过高层语义特征的融合,避免生成视频中面部特征的僵硬和背景信息的直接复制。

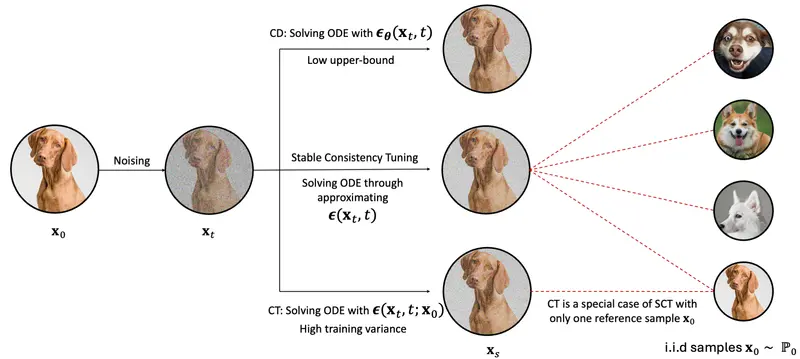

工作原理

1、输入处理:

- 输入包含一张人物面部图像和一段描述人物活动的文本。

- 使用人脸检测器提取面部区域,并通过双分支特征提取架构获取面部视觉特征(

Fvision)和身份信息(Fid)。

2、多模态特征融合(IITF模块):

- 面部特征对齐:将

Fid通过一个轻量级映射模块Prj对齐到Fvision的特征空间,生成Fface。 - 条件特征对齐:将

Fface与文本描述特征Fprompt融合,生成最终的条件特征Fcond,用于指导视频生成。

3、视频生成:

- 使用扩散模型(Diffusion Model)生成视频,通过条件特征

Fcond和VAE编码的面部视觉特征zface作为输入,确保生成视频中的人物身份一致性。 - 在训练过程中,通过随机丢弃

zface,避免模型过度依赖低层视觉信息,增强对高层语义特征的利用。

4、损失函数:

- 使用扩散模型的标准损失函数(如DDPM损失)监督噪声预测。

- 增加面部区域的额外损失函数,确保模型对人脸的正确感知。

具体应用场景

- 视频内容创作:为社交媒体、广告和娱乐行业生成个性化视频内容,保持人物身份一致性。

- 虚拟现实和增强现实:在虚拟环境中生成连贯的人物动作和表情,提升用户体验。

- 动画制作:快速生成高质量的动画视频,减少人工绘制的工作量。

- 视频会议和远程协作:生成虚拟人物视频,用于远程会议或在线教学,保持人物身份特征。

- 影视制作:辅助影视特效制作,快速生成人物在不同场景中的表现,减少拍摄成本和时间。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...