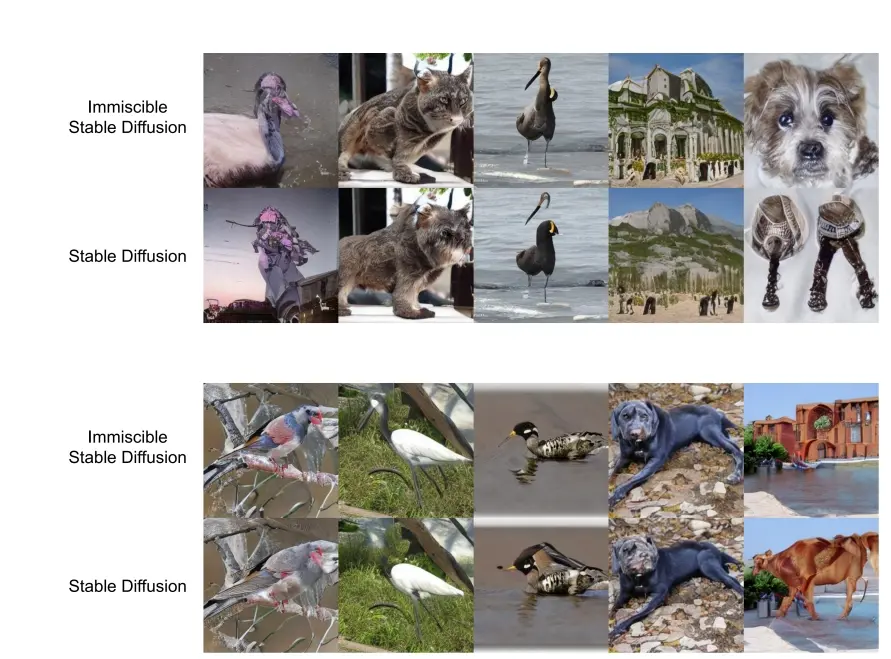

加州大学伯克利分校和清华大学的研究人员推出新技术“Immiscible Diffusion(不可混合扩散)”,它旨在加速扩散模型的训练过程。扩散模型是一类在图像生成领域取得显著进展的模型,但它们的训练通常非常消耗资源,并且效率不高。尽管Immiscible Diffusion在小规模数据集上表现出色,但对于更大规模数据集的验证还有待未来工作。此外,论文还讨论了该方法可能对数据中心工作负载的影响,以及它如何帮助降低模型开发的成本。

例如,我们有一个图像生成任务,需要生成清晰度高、细节丰富的图像。使用传统的扩散模型可能需要很长时间的训练,并且需要大量的计算资源。通过应用Immiscible Diffusion,我们可以在保持图像质量的同时,显著减少所需的训练时间和资源。例如,在CIFAR-10数据集上,使用Immiscible Diffusion的方法可以将训练效率提高至原来的3倍,同时生成的图像具有更低的Fréchet Inception Distance(FID)得分,这是衡量生成图像质量的一个指标。

主要功能与特点:

- 加速训练:Immiscible Diffusion通过改进噪声与数据的映射关系,显著提高了扩散模型的训练效率。

- 简单易实现:该方法仅需一行代码即可实现,对现有模型架构无需进行任何修改。

- 保持高保真度:在加速训练的同时,该方法还能保持生成图像的高质量,不牺牲模型性能。

工作原理:

- 扩散模型的训练过程可以类比为将图像逐渐加入噪声,然后再逐步去除噪声以恢复原图。传统的扩散训练中,每个图像在整个噪声空间中扩散,导致噪声层的每一点都混合了所有图像的特征。

- Immiscible Diffusion借鉴了物理学中不可混合物质的概念,通过在训练前先对图像数据和噪声进行分配,使得每个图像只与附近的噪声点相关联。这样,每个噪声点只与有限的图像匹配,避免了传统扩散过程中的混乱混合。

- 具体实施时,Immiscible Diffusion在图像数据扩散成噪声之前,通过最小化小批量中图像-噪声对的总距离来进行分配。这个过程使用了一种量化分配策略,显著降低了计算开销。

具体应用场景:

- 图像生成:在CIFAR-10、CelebA和ImageNet等数据集上,Immiscible Diffusion被用于加速生成高质量图像的扩散模型的训练。

- 视频生成:虽然论文中没有直接提到视频生成,但扩散模型也常用于视频生成,Immiscible Diffusion同样可以应用于此场景,以加速训练过程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...