尽管基于DiT架构模型的视频生成技术取得了显著进展,现有模型在捕捉关键细节方面仍面临挑战。为了提高视频质量,视频增强成为一种直观的方法,其主要目标是:

- 保持帧间一致性:确保相邻帧之间的视觉和语义一致性。

- 提高视觉质量:增强图像的清晰度、对比度和细节。

时间注意力机制在确保帧间一致性方面起着至关重要的作用。通过分析时间注意力模式,研究人员发现帧间(非对角线)的注意力权重显著低于对角线上的权重,这可能导致帧间不一致。受此启发,新加坡国立大学、上海人工智能实验室和德克萨斯大学奥斯汀分校的研究人员提出了一种新的方法——Enhance-A-Video,通过调整时间注意力的温度参数来增强视频质量。

- 项目主页:https://oahzxl.github.io/Enhance_A_Video

- GitHub:https://github.com/NUS-HPC-AI-Lab/Enhance-A-Video

目前已有开发者将该技术应用到HunyuanVideo、CogVideoX和LTX-Video等模型,大家可以通过以下插件应用到ComfyUI:

- ComfyUI-LTXTricks:https://github.com/logtd/ComfyUI-LTXTricks

- ComfyUI-HunyuanVideoWrapper:https://github.com/kijai/ComfyUI-HunyuanVideoWrapper

时间注意力的作用与挑战

时间注意力机制通过在不同帧之间分配注意力权重,确保帧间的一致性。然而,现有的时间注意力模式存在以下问题:

- 帧间注意力不足:非对角线上的注意力权重较低,导致帧间一致性较差,影响视频的流畅性和连贯性。

- 细节丢失:由于注意力集中在对角线上,跨帧的相关性较弱,导致关键细节的丢失。

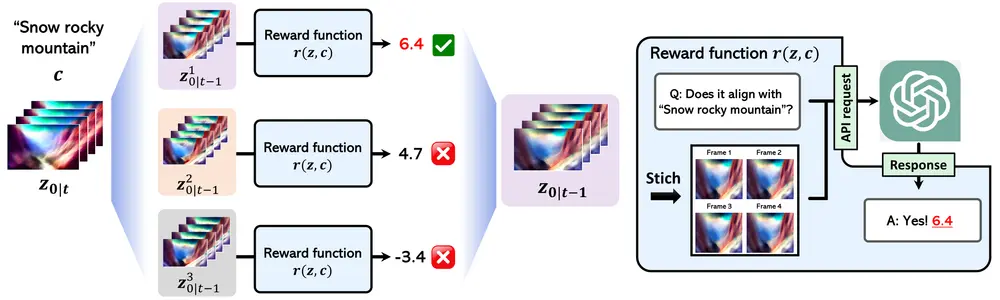

Enhance-A-Video 的核心思想

Enhance-A-Video 通过引入一个 增强块 作为并行分支,专门用于调整时间注意力输出。该方法的核心思想是:

- 计算跨帧强度(CFI):增强块计算时间注意力图中非对角线元素的平均值,作为跨帧强度(Cross-Frame Intensity, CFI)。CFI 衡量了帧间注意力的强度。

- 调整温度参数:引入一个增强的温度参数 ,将其乘以 CFI 以增强时间注意力输出。较高的温度值能够扩大注意力分布,增加跨帧相关性,从而提升帧间一致性。

- 无需重新训练:Enhance-A-Video 是一种无需重新训练的增强方法,可以直接应用于现有的视频生成模型,如 HunyuanVideo 和 CogVideoX。

方法概述

Enhance-A-Video 的具体实现步骤如下:

- 输入视频帧:给定一组连续的视频帧 ,模型首先通过时间注意力机制计算帧间的注意力图

。

- 计算跨帧强度(CFI):增强块提取时间注意力图 中的非对角线元素,计算其平均值作为跨帧强度

。CFI 反映了帧间注意力的强度。

- 调整时间注意力:引入温度参数,将其乘以 CFI,得到增强的时间注意力输出

- 生成增强后的视频:使用增强后的时间注意力输出,

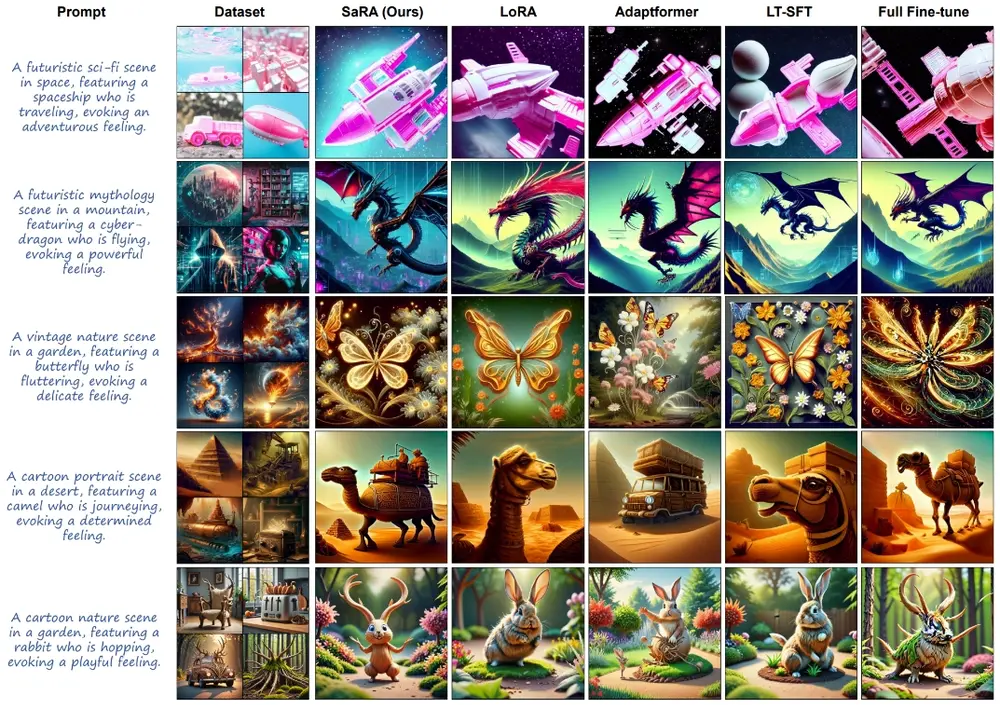

实验结果与评估

研究人员在多个视频生成模型上测试了 Enhance-A-Video 的效果,包括:

- HunyuanVideo

- CogVideoX-2B

- Open-Sora v1.2

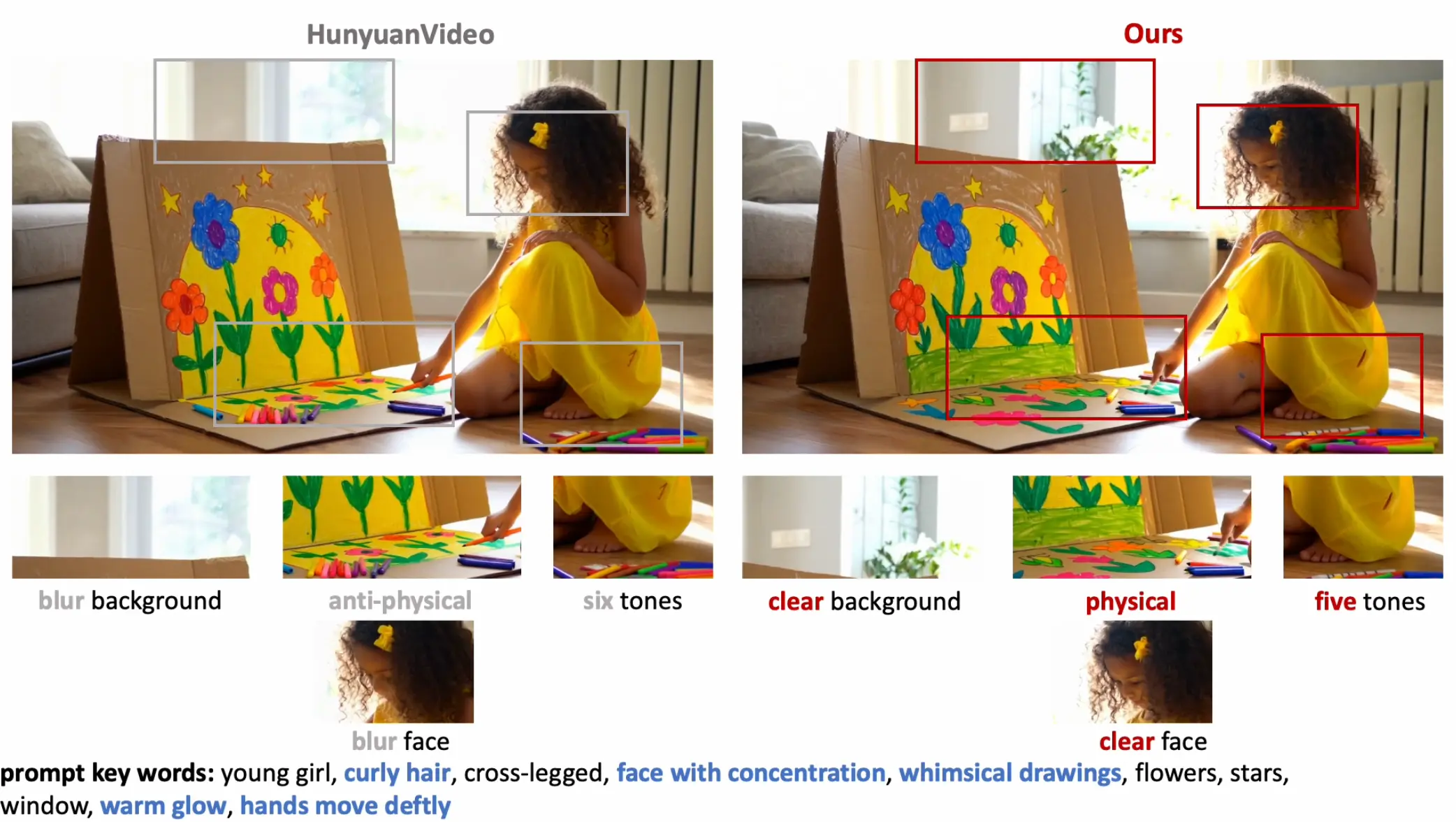

实验结果显示,所有测试模型在视频增强方面都有显著改进。具体来说:

- HunyuanVideo:增强版本显示出更高的对比度和清晰度,特别是在更真实的轮子和充电站等细节上表现尤为明显。

- CogVideoX-2B:增强后的视频在帧间一致性方面有显著提升,运动物体的轨迹更加平滑,减少了抖动现象。

- Open-Sora v1.2:增强后的视频在细节保留和视觉质量上有所提升,特别是在复杂场景中表现更好。

温度参数的影响

温度参数

在增强时间注意力输出中起着关键作用。通过调整

的值,可以控制跨帧相关性的强度:

- 较低的温度:导致注意力分布较为集中,帧间相关性较弱,适合处理简单的视频内容。

- 较高的温度:扩大注意力分布,增加跨帧相关性,适合处理复杂的视频内容,能够捕捉更多的细节和动态变化。

- 极高的温度:虽然能带来更多细节和创造力,但也可能导致不合逻辑的内容和视频失真。因此,选择合适的温度值至关重要。

定性与定量评估

为了全面评估 Enhance-A-Video 的效果,研究人员进行了定性和定量的实验:

- 定性评估:通过视觉检查,增强后的视频在帧间一致性和视觉质量上有显著提升。特别是对于复杂的运动场景和细节丰富的物体,增强后的视频表现更为出色。

- 定量评估:研究人员使用多种指标(如 PSNR、SSIM、VMAF 等)进行量化评估,结果显示增强后的视频在这些指标上均有显著提升。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...