音频语言模型(ALMs)在各种应用中发挥着关键作用,包括实时转录、翻译、语音控制系统和辅助技术。然而,许多现有解决方案面临高延迟、大量计算需求以及依赖云端处理等限制。这些问题对边缘部署提出了挑战,因为在边缘环境中,低功耗、低延迟和本地化处理至关重要。资源有限或隐私要求严格的环境使得大型集中式模型变得不切实际。解决这些限制对于在边缘场景中充分发挥ALMs的潜力至关重要。

- 官方介绍:https://nexa.ai/blogs/omniaudio-2.6b

- 模型:https://huggingface.co/NexaAIDev/OmniAudio-2.6B

- Demo:https://huggingface.co/spaces/NexaAIDev/omni-audio-demo

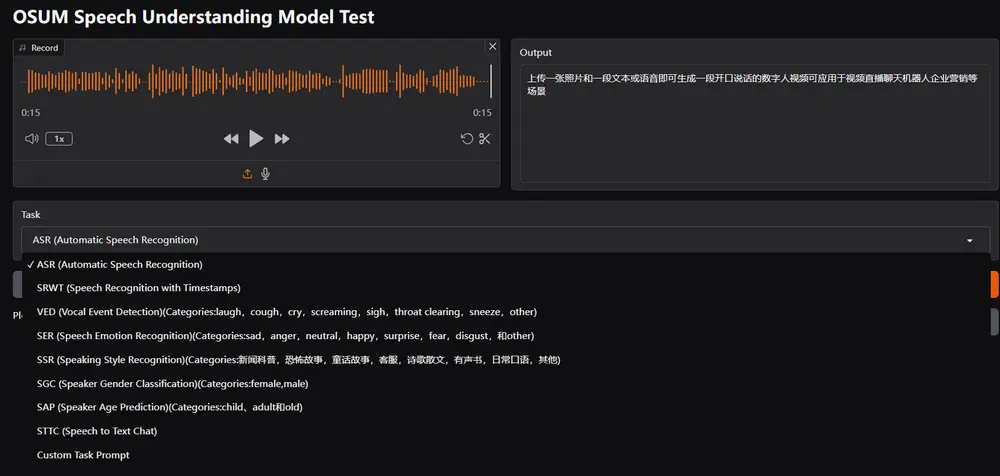

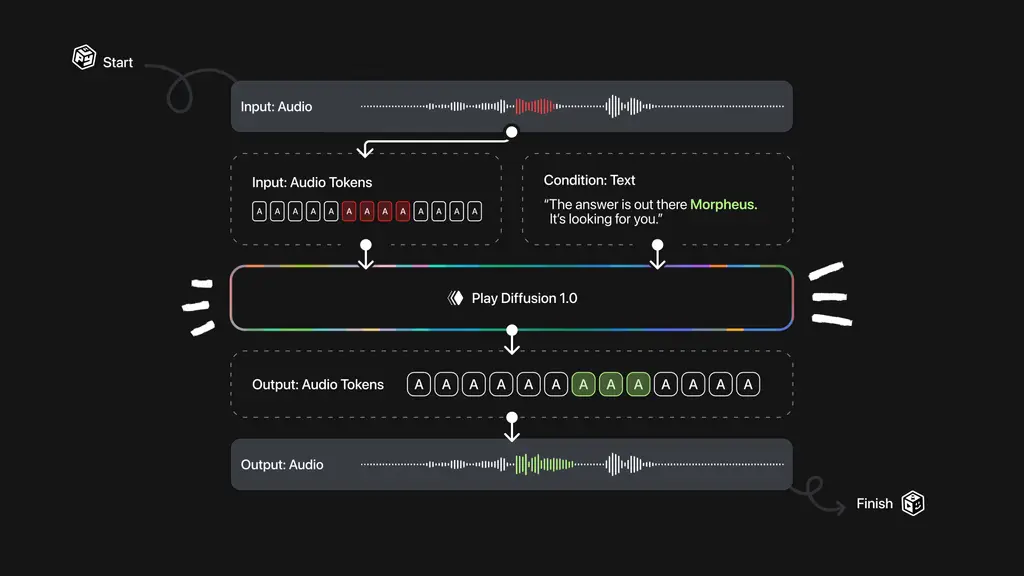

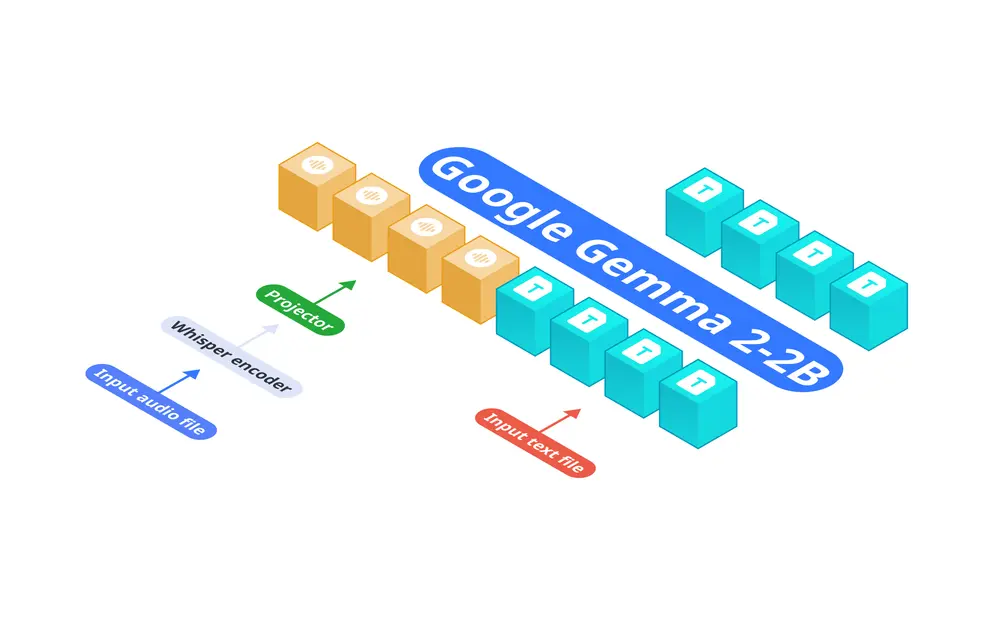

Nexa AI 宣布推出 OmniAudio-2.6B,这是一种专为边缘部署设计的音频语言模型。与传统的将自动语音识别(ASR)和语言模型分离的架构不同,OmniAudio-2.6B 将 Gemma-2-2b、Whisper Turbo 和一个自定义投影器集成到一个统一框架中。这种设计消除了链式分离组件带来的低效和延迟,非常适合计算资源有限的设备。

技术细节与优势

1. 统一框架设计

OmniAudio-2.6B 的核心在于其独特的统一框架设计,将 Gemma-2-2b(一个经过改进的大型语言模型)、Whisper Turbo(一个强大的ASR系统)和一个自定义投影器集成在一起。这种设计不仅提高了处理效率,还减少了延迟,确保了无缝的音频处理管道。

- Gemma-2-2b:作为语言模型部分,Gemma-2-2b 提供了强大的自然语言理解能力,能够生成高质量的文本输出。

- Whisper Turbo:作为ASR系统,Whisper Turbo 负责将音频输入转换为文本,具有高准确性和快速响应的特点。

- 自定义投影器:连接ASR和语言模型,减少了中间数据传递的开销,进一步提升了整体性能。

2. 处理速度

OmniAudio-2.6B 在处理速度方面表现出色,尤其是在边缘设备上。基准测试显示,在2024款 Mac Mini M4 Pro 上:

- 使用 FP16 GGUF 格式时,每秒可处理 35.23个token。

- 使用 Q4_K_M GGUF 格式时,每秒可处理 66个token,并且使用 Nexa SDK 进行优化。

相比之下,知名的替代方案 Qwen2-Audio-7B 在类似硬件上仅能处理 每秒6.38个token。这一显著的速度提升意味着 OmniAudio-2.6B 可以在边缘设备上实现实时音频处理,而无需依赖云端带来的延迟。

3. 资源效率

OmniAudio-2.6B 的紧凑设计使其能够在资源受限的环境中高效运行。它减少了对云资源的依赖,非常适合可穿戴设备、汽车系统和物联网设备等功耗和带宽有限的应用。通过在本地进行处理,OmniAudio-2.6B 不仅降低了网络延迟,还增强了用户隐私保护。

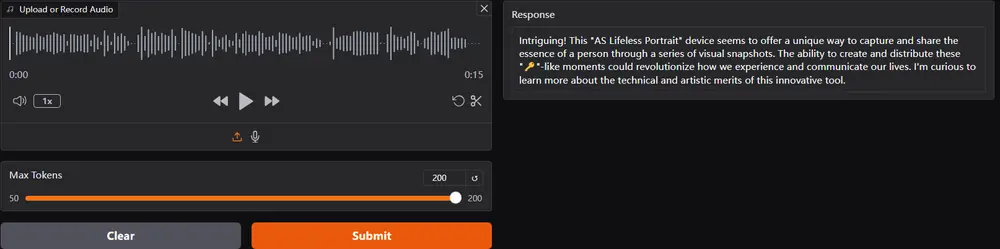

4. 准确性与灵活性

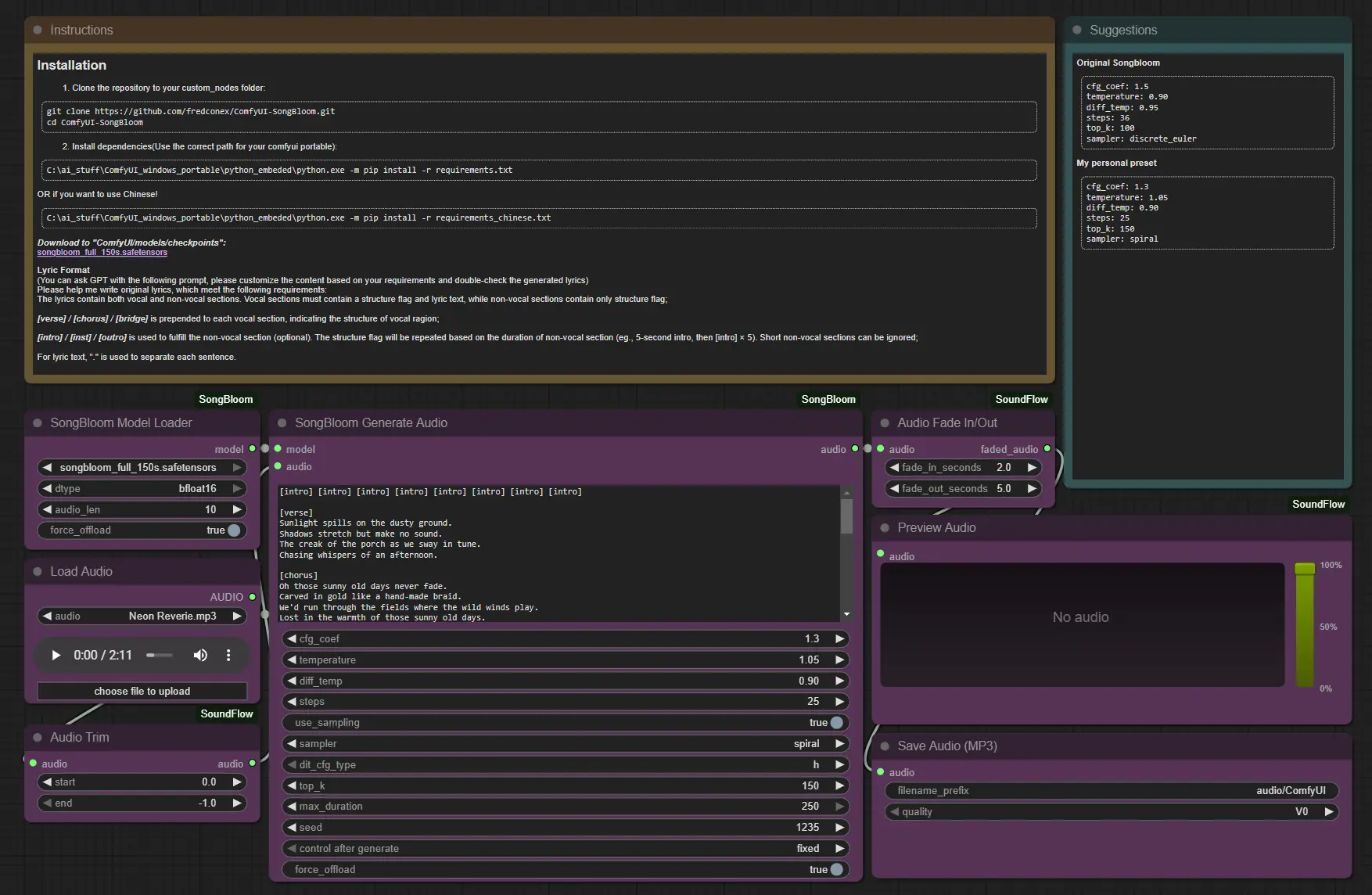

尽管专注于速度和效率,OmniAudio-2.6B 仍然保持了高准确性,适用于多种任务,如转录、翻译和摘要。该模型的灵活性使其能够适应不同的应用场景,无论是消费级产品还是企业级解决方案。

性能洞察

基准测试结果进一步证明了 OmniAudio-2.6B 的卓越性能。在2024款 Mac Mini M4 Pro 上,OmniAudio-2.6B 每秒可处理高达 66个token,远超 Qwen2-Audio-7B 的 每秒6.38个token。这一速度上的显著提升扩展了实时音频应用的可能性。

例如,OmniAudio-2.6B 可以通过实现更快的设备内响应来增强虚拟助手,而无需依赖云端带来的延迟。在医疗保健等实时转录和翻译至关重要的行业中,该模型的速度和准确性可以改善结果和效率。其边缘友好的设计进一步增强了其在需要本地化处理的场景中的吸引力。

应用场景

OmniAudio-2.6B 的高性能和低延迟特性使其适用于多种边缘应用,包括但不限于:

- 智能音箱和虚拟助手:通过本地化处理,减少云端依赖,提升响应速度和用户体验。

- 医疗保健:实现实时语音转录和翻译,帮助医生和护士更高效地记录患者信息。

- 智能家居:增强语音控制功能,使设备能够更快地响应用户的指令。

- 自动驾驶:提供实时语音交互,帮助驾驶员更好地与车辆系统互动。

- 物联网设备:支持边缘设备进行本地化的语音处理,减少网络带宽和功耗。

相关文章