在AI领域,将实时语音交互与视觉内容相结合一直是一个极具挑战性的课题。传统系统通常依赖于多个独立组件来实现语音活动检测、语音识别、文本对话和文本转语音合成,这种分段式的方法不仅容易引入延迟,还难以捕捉人类对话中的细微差别,如情感或非语言声音。这些局限性在为视障人士设计的应用中尤为显著,因为这些应用需要及时且准确地描述视觉场景。

- 项目主页:https://kyutai.org/moshivis

- GitHub:https://github.com/kyutai-labs/moshivis

- 模型:https://huggingface.co/kyutai/moshika-vis-pytorch-bf16

- Demo:https://vis.moshi.chat

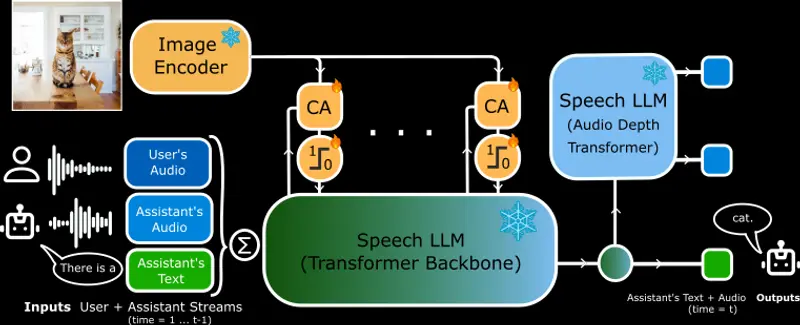

为了突破这些限制,Kyutai推出了MoshiVis,这是一个开源的视觉语音模型(VSM),能够实现关于图像的自然、实时语音交互。MoshiVis建立在Kyutai早期工作Moshi——一个专为实时对话设计的语音-文本基础模型——之上,并扩展了其功能以包括视觉输入。这一增强功能使用户能够流畅地讨论视觉内容,标志着AI发展的一个重要进步。

MoshiVis的技术亮点

轻量级跨注意力模块

从技术角度看,MoshiVis通过集成轻量级跨注意力模块增强了Moshi。这些模块将来自现有视觉编码器的视觉信息融入Moshi的语音令牌流中。这一设计不仅保留了Moshi原有的对话能力,还引入了处理和讨论视觉输入的能力。跨注意力模块中的门控机制使模型能够选择性地处理视觉数据,保持效率和响应性。

高效的实时性能

值得注意的是,MoshiVis在消费级设备(如配备M4 Pro芯片的Mac Mini)上每个推理步骤仅增加约7毫秒的延迟,总计每步55毫秒。这一性能远低于实时延迟80毫秒的阈值,确保了流畅自然的交互。

实际应用场景

为视障人士提供音频描述

在实际应用中,MoshiVis展示了通过自然语音提供视觉场景详细描述的能力。例如,当面对一幅描绘绿色金属结构被大树环绕、背景中有一座浅棕色外墙建筑的图像时,MoshiVis会说道:

“我看到两个顶部有网状结构的绿色金属建筑,它们被大树包围。在背景中,你可以看到一座浅棕色外墙和黑色屋顶的建筑,看起来像是用石头建造的。”

这一能力为诸如为视障人士提供音频描述、提升可访问性以及实现与视觉信息更自然的交互等应用开辟了新途径。

开源与社区合作

通过将MoshiVis作为开源项目发布,Kyutai邀请研究社区和开发者探索并扩展这项技术,促进视觉-语音模型的创新。模型权重、推理代码和视觉语音基准的可用性进一步支持了协作努力,以改进和多样化MoshiVis的应用。

相关文章