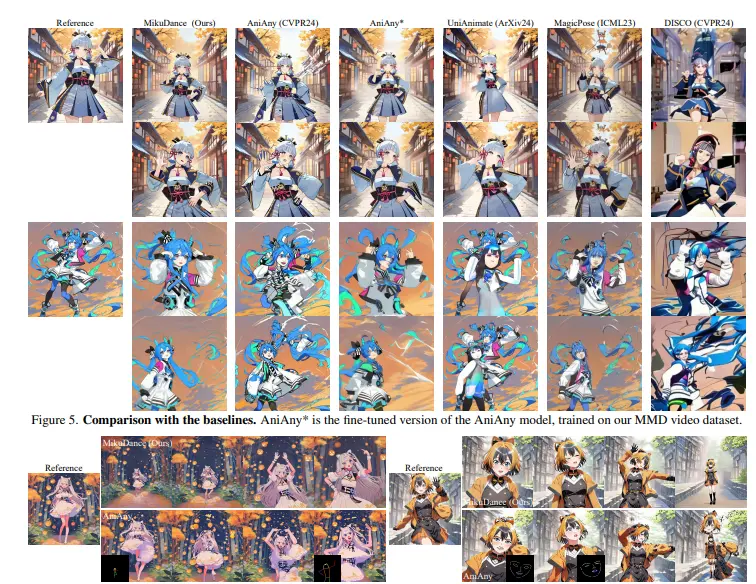

武汉大学、阶跃星辰和字节跳动的研究人员推出MikuDance,它是一个基于扩散的动画制作流程,用于为风格化的角色艺术作品添加混合运动动力学,使其动起来。MikuDance的核心在于它能够处理复杂的角色艺术作品中的高动态运动和参考引导错位问题。简单来说,MikuDance类似于阿里Animate Anyone,只是其专注于二次元角色,能轻松将二次元角色根据 Open Pose 姿势生成对应动画。

例如,一个静态的动漫角色图像,MikuDance能够根据给定的动作指导视频(如舞蹈动作),生成该角色的动画视频。在这个过程中,MikuDance不仅要考虑角色的身体动作,还要考虑背景的运动,如相机的移动和场景的变化,以产生连贯且视觉上吸引人的动画。

主要功能和特点

主要功能:

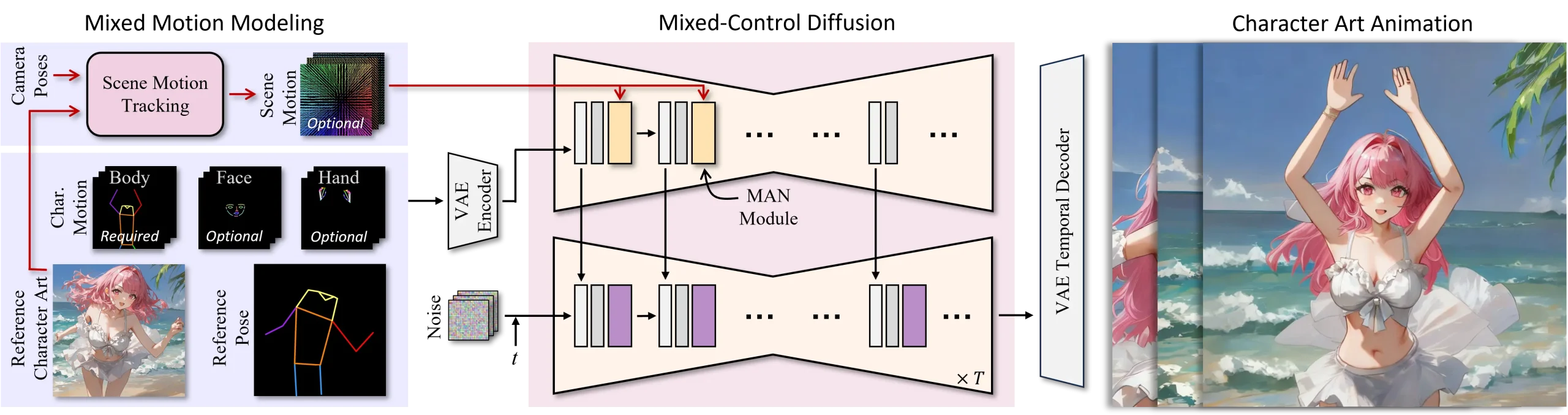

- 混合运动建模(Mixed Motion Modeling): 能够在同一像素空间内显式地表示角色运动和3D动态相机运动,实现对前景和背景的局部和全局运动指导。

- 混合控制扩散(Mixed-Control Diffusion): 通过将所有参考和运动指导整合到统一的参考UNet中,实现对角色艺术动画的对齐运动控制。

- 运动适应归一化(Motion-Adaptive Normalization, MAN)模块: 有效注入全局场景运动,保持角色艺术动画的局部一致性。

主要特点:

- 能够处理高动态运动指导,包括复杂的前景和背景运动。

- 能够隐式对齐不同比例和身体形状的角色与运动指导。

- 通过混合源训练方法,提高了对多种艺术风格的适应性。

工作原理

MikuDance的工作原理可以分为以下几个步骤:

- 场景运动跟踪(Scene Motion Tracking, SMT): 通过将参考图像投影到场景点云,并跟踪连续相机帧中相应的点,将相机姿态转换为像素级场景运动表示。

- 混合控制扩散: 将参考图像和运动指导编码到潜在空间,然后通过混合控制扩散在潜在空间中生成动画。

- 运动适应归一化(MAN)模块: 在参考UNet的每个下采样块之后加入MAN模块,以实现场景运动的空间感知归一化,增强前景和背景动画的时间一致性。

具体应用场景

MikuDance可以应用于多种场景,包括但不限于:

- 电影和游戏行业: 为电影和游戏中的静态角色图像创建动态动画。

- 数字设计: 在数字媒体和广告中为静态艺术作品添加动态效果。

- 虚拟现实(VR)和增强现实(AR): 在虚拟或增强现实环境中为角色提供动态表现。

- 社交媒体和娱乐: 允许用户为社交媒体平台创建个性化的动态角色内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...