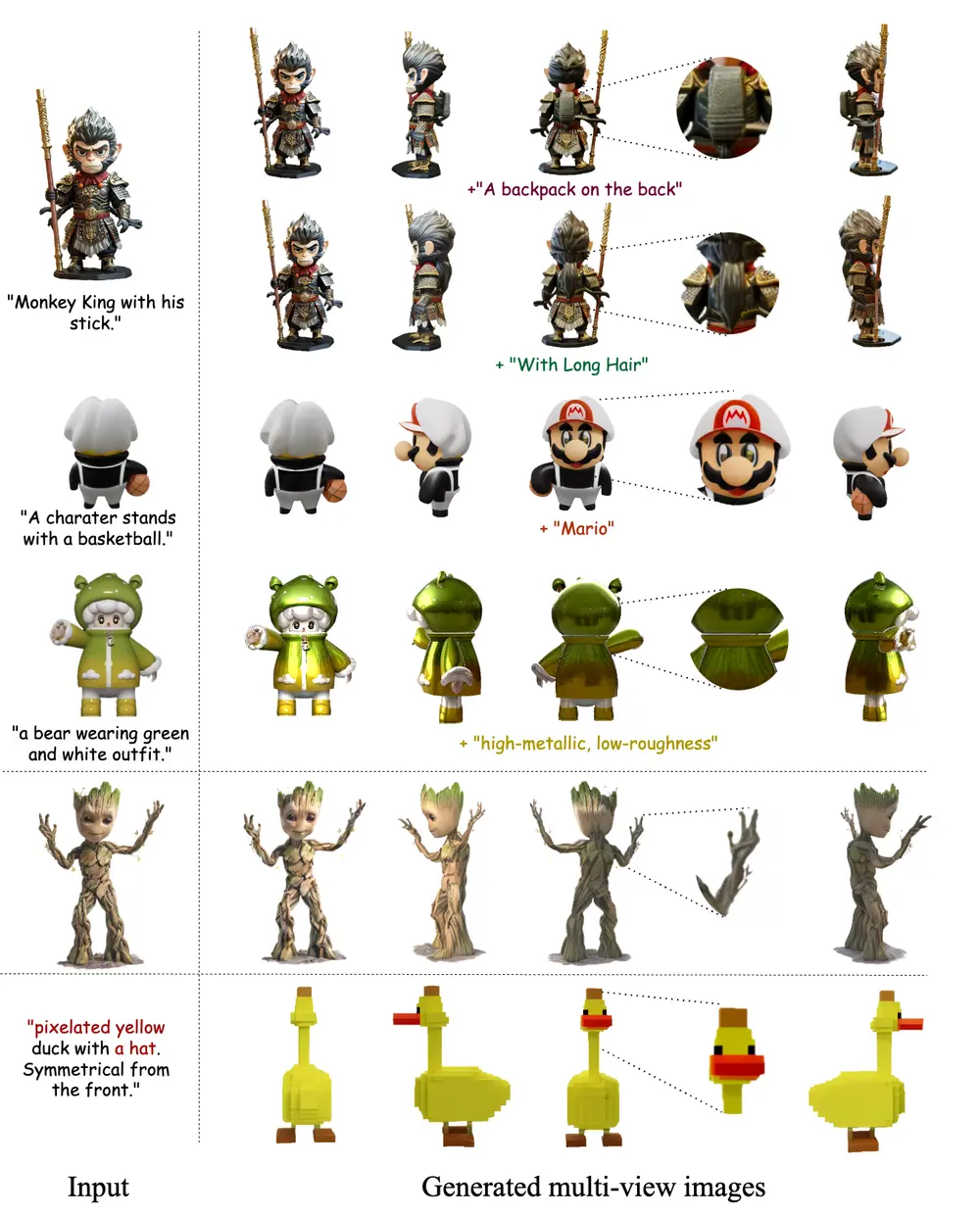

来自香港科技大学(广州)、香港科技大学和趣玩的研究人员开发了一个名为FlexGen的框架,它能够根据单一视角的图像、文本提示或两者的结合来灵活生成可控制且一致的多视图图像。想象一下,你给FlexGen一张某个物体的照片或者一个描述这个物体的文本,比如“一个穿着学校制服、站着的年轻女孩”,它就能生成这个物体从不同角度(正面、侧面、背面和顶面)看起来的样子。

研究人员利用 GPT-4V 的强大推理能力来生成 3D 感知的文本注释。通过分析排列为平铺多视图图像的对象的四个正交视图,GPT-4V 可以生成包含 3D 感知信息和空间关系的文本注释。通过将控制信号与提出的自适应双控制模块集成,FlexGen可以生成与指定文本相对应的多视图图像。FlexGen 支持多种可控能力,允许用户修改文本提示以生成合理且相应的新部分。此外,用户可以影响外观和材料属性,包括金属性和粗糙度。广泛的实验证明,FlexGen提供了增强的多重可控性,标志着对现有多视图扩散模型的显著进步。这项工作对需要快速和灵活的 3D 内容创建的领域具有重大意义,包括游戏开发、动画和虚拟现实。

主要功能和特点

- 多视图生成:FlexGen可以生成一个物体的四个视角(正面、左侧、背面和右侧)的图像,这些图像被排列成一个2x2的布局。

- 文本和图像输入:它可以接受文本提示或单视图图像作为输入,甚至可以同时使用两者来生成多视图图像。

- 3D感知文本注释:利用GPT-4V的强大推理能力,FlexGen能够生成包含3D信息和空间关系的文本注释。

- 自适应双控模块:这个模块允许模型同时根据图像和文本提示进行条件化,实现更精确和灵活的多视图图像生成。

工作原理

FlexGen的工作原理包括以下几个步骤:

- 3D感知文本注释:通过分析物体的四个正交视图,GPT-4V生成包含全局上下文和局部特征的详细描述,这些描述被用来指导图像生成。

- 自适应双控模块:这个模块整合了参考图像和文本提示,通过交叉注意力机制实现图像和文本之间的信息交互,使得生成的多视图图像既忠实于输入图像,又与文本描述一致。

- 训练和推理:在训练阶段,FlexGen可以处理单模态或双模态输入,增加了模型的灵活性。在推理阶段,如果提供了图像和文本,模型会结合这两种信息生成多视图图像;如果只提供了其中一种,模型会根据提供的信息生成相应的多视图图像。

具体应用场景

- 游戏开发:在游戏开发中,设计师可以使用FlexGen快速生成游戏中角色或物体的多视图图像,以检查设计在不同角度下的外观。

- 动画制作:动画师可以利用FlexGen生成角色或场景的多视角视图,以便于制作动画时更好地理解和设计动作和视角变化。

- 虚拟现实:在虚拟现实应用中,FlexGen可以帮助开发者生成一致的多视角内容,提升用户体验的沉浸感和真实感。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...