KRAFTON和韩国科学技术研究院AI研究生院的研究人员推出一种在推理阶段组合定制扩散模型的新方法TweedieMix,它用于改进多概念融合在基于扩散的图像和视频生成中的应用。简单来说,TweedieMix能够帮助我们在生成图像或视频时,更有效地结合多个个性化的概念或元素。

- GitHub:https://github.com/KwonGihyun/TweedieMix

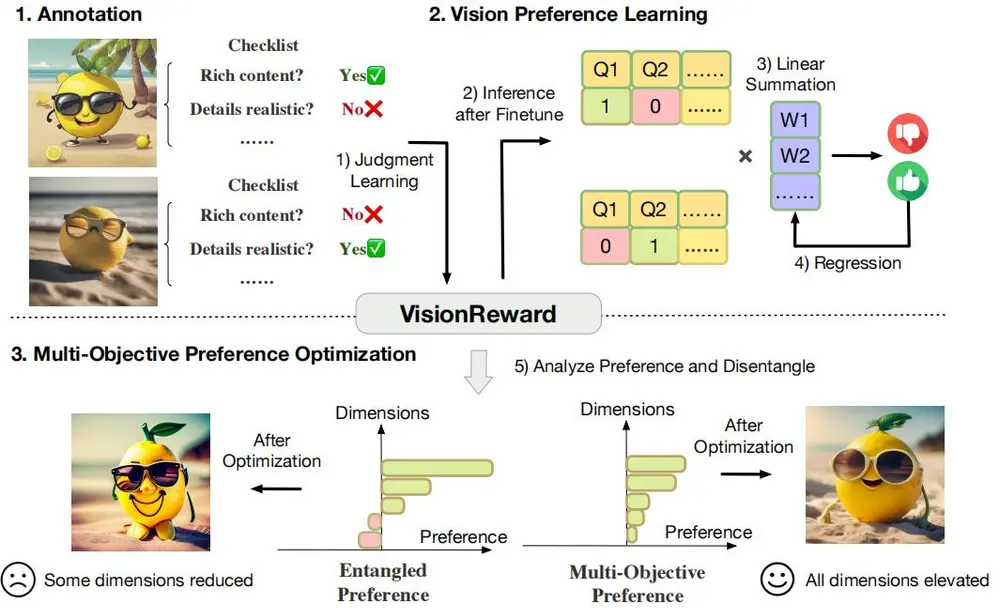

通过分析反向扩散采样的特性,TweedieMix将采样过程分为两个阶段。在初始步骤中,研究团队应用一种多对象感知采样技术,以确保包含所需的目标对象。在后期步骤中,研究团队使用 Tweedie 公式在去噪图像空间中融合自定义概念的外观。研究结果表明,TweedieMix 可以生成比现有方法更高保真度的多个个性化概念。此外,TweedieMix的框架可以轻松扩展到图像到视频扩散模型,从而生成具有多个个性化概念的视频。

主要功能:

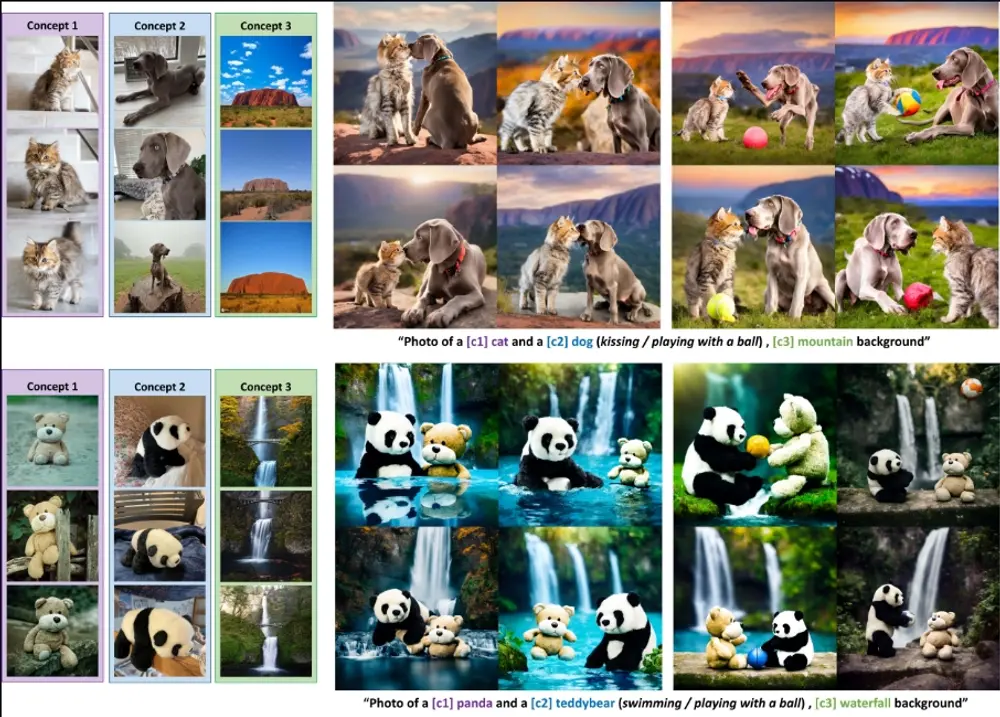

TweedieMix的主要功能是生成能够体现多个个性化概念的高质量图像和视频。例如,如果你想生成一张图片,里面有一只猫和一只狗在玩球,而且背景是山脉,TweedieMix可以帮助你更准确地实现这样的多元素组合,而不会混淆或丢失任何一个元素的细节。

主要特点:

- 两阶段采样过程:TweedieMix将采样过程分为两个阶段,首先确保目标对象的出现,然后在后期步骤中融合定制概念的外观。

- 多对象感知采样技术:在初始步骤中,使用多对象感知采样技术,确保所需的目标对象被包含在生成的图像或视频中。

- Tweedie公式:在后期步骤中,使用Tweedie公式在去噪图像空间中混合定制概念的外观,以实现稳定和高质量的采样。

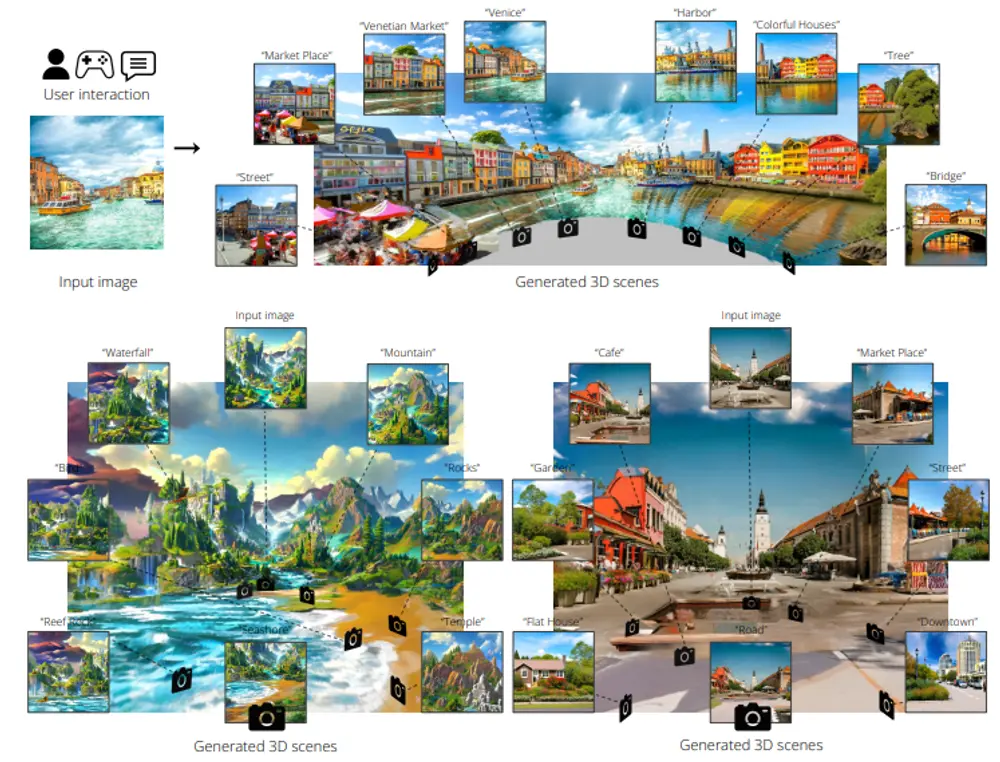

- 扩展到视频领域:该框架可以轻松扩展到图像到视频的扩散模型,使得能够生成包含多个个性化概念的视频。

工作原理:

TweedieMix的工作原理基于分析反向扩散采样的特性。它首先使用一个未经微调的基础模型进行多对象感知采样,并引入了一个新颖的重采样策略来进一步提高生成质量。在中间步骤中,通过预训练的文本引导分割模型提取区域掩码。在第二阶段,它应用定制的概念模型,并通过对象-wise区域引导进行集成。最后,它使用Tweedie公式在中间去噪图像空间中混合每个定制概念样本。

具体应用场景:

- 个性化内容创作:艺术家和设计师可以使用TweedieMix来创作包含多个个性化元素的作品,如特定的角色、场景或风格。

- 社交媒体:用户可以在社交媒体上分享包含多个概念的个性化图像或视频,如旅行时拍摄的照片,其中包含多个朋友和特定的地标。

- 广告和营销:公司可以利用TweedieMix生成包含其产品和特定营销信息的图像或视频,以吸引潜在客户。

- 游戏和娱乐:游戏开发者可以使用这项技术来创造具有丰富细节和个性化元素的游戏环境或宣传材料。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...