生成一段包含多个镜头、角色一致、场景连贯、时长达一分钟的叙事视频,是当前视频生成模型的重大挑战。主流方法要么局限于单镜头,要么在跨镜头切换时出现角色崩坏、场景断裂等问题。

由南洋理工大学与字节跳动联合提出的新框架 StoryMem,从人类记忆机制中获得启发,提出了一种全新范式:将长视频叙事重构为“基于显式视觉记忆的迭代镜头合成”。

- 项目主页:https://kevin-thu.github.io/StoryMem

- GitHub:https://github.com/Kevin-thu/StoryMem

- 模型:https://huggingface.co/Kevin-thu/StoryMem

它不需要从头训练大规模视频模型,而是通过一种轻量设计,将现有单镜头扩散模型“升级”为多镜头叙事者。

核心思想:让模型“记住”之前拍了什么

传统视频生成模型在生成新镜头时,往往“忘记”了前几秒的内容。StoryMem 的关键创新在于引入了一个动态更新的视觉记忆库:

- 在生成每个镜头后,系统会从该镜头中提取语义关键帧;

- 通过 CLIP 特征选择与 HPSv3 审美质量过滤,只保留信息丰富且视觉高质量的帧;

- 这些帧被存入记忆库,作为后续镜头生成的视觉上下文。

这种机制模拟了人类在观看电影时对角色、场景的持续认知——故事在推进,但记忆在延续。

技术实现:记忆如何注入生成过程?

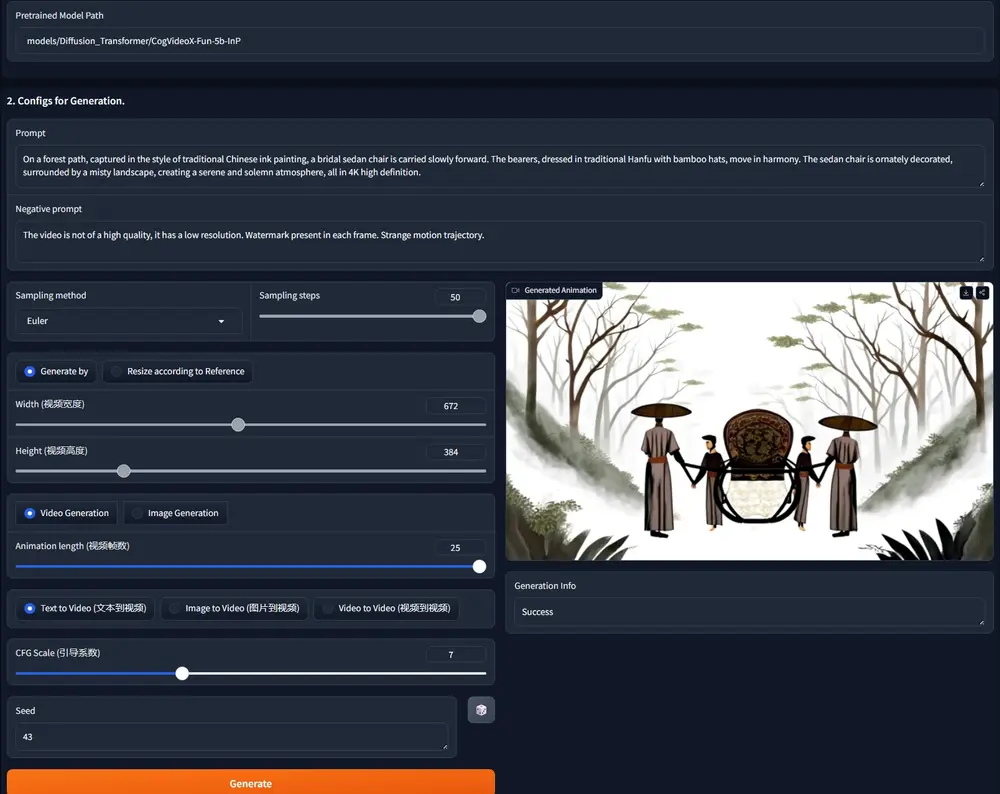

StoryMem 提出 Memory-to-Video(M2V) 架构,将记忆融入预训练的单镜头视频扩散模型(如 Video DiT),仅需 LoRA 微调,即可实现跨镜头一致性。

具体流程如下:

- 记忆编码:记忆库中的关键帧通过 3D VAE 编码为潜在表示;

- 记忆注入:在去噪过程中,记忆潜在与当前含噪视频潜在在潜在空间拼接,并通过负 RoPE(旋转位置嵌入)偏移对齐时空位置;

- 条件生成:微调后的 DiT 模型以记忆为条件,生成与历史镜头角色一致、场景连贯的新镜头;

- 记忆更新:新镜头生成后,再次提取关键帧,更新记忆库,进入下一迭代。

整个过程无需重新训练基础模型,仅用少量 LoRA 参数即可激活“叙事记忆”能力。

关键优势

多镜头长视频生成

支持生成跨越多个场景、时长达 60 秒的连贯故事,每个镜头均可由文本精确控制。

跨镜头一致性

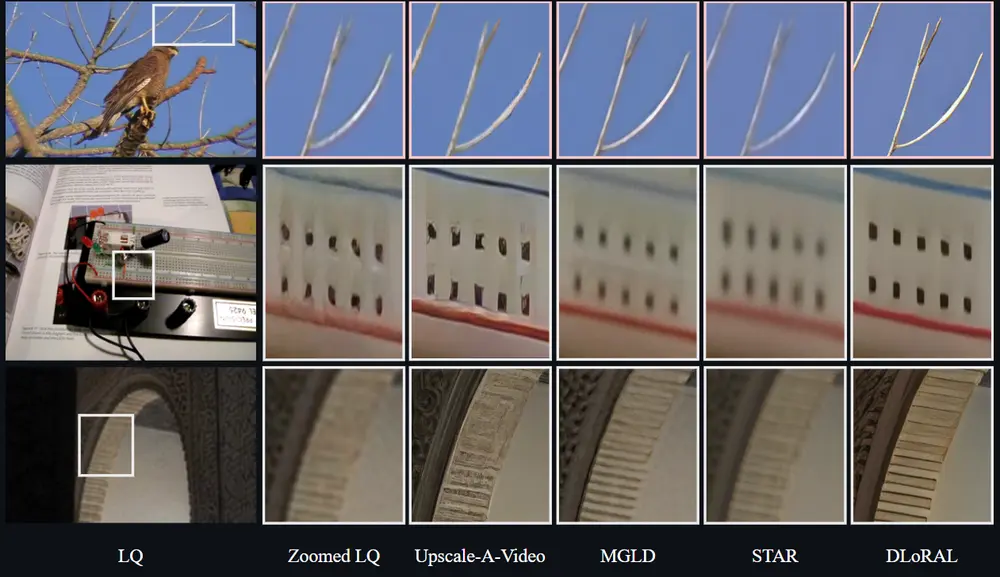

在 ST-Bench 基准测试中,StoryMem 的整体一致性比预训练基线提升 28.7%,比当前最佳方法 HoloCine 高出 9.4%。

电影级视觉质量

继承单镜头模型的高美学质量、精准提示跟随与摄像机动态控制能力,画面细节丰富、运镜自然。

灵活扩展

- 支持平滑镜头过渡(如淡入淡出、匹配剪辑);

- 可结合 参考图像(R2V)初始化记忆库,实现角色或风格定制;

- 天然兼容 I2V、R2V 等现有生成范式。

评估:新基准 ST-Bench

为系统评估多镜头叙事能力,团队构建了 ST-Bench:

- 包含 30 个长故事脚本,涵盖动画、写实、科幻、教育等多种风格;

- 每个故事含 4–8 个镜头,总时长 45–60 秒;

- 评估维度:跨镜头一致性、视觉质量、文本对齐度、叙事连贯性。

用户研究表明,StoryMem 在角色身份保持与场景过渡自然性上显著优于所有基线。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...