在视频编辑、虚拟合成、游戏特效和社交媒体创作中,带有透明背景(Alpha 通道)的视频素材具有不可替代的价值——它们可以无缝叠加到任意场景中,无需后期抠像或遮罩处理。

然而,当前主流的文生视频(Text-to-Video)模型大多仅输出 RGB 视频,缺乏对 Alpha 通道的支持。少数尝试生成 RGBA 视频的方法,又普遍存在透明度边缘模糊、半透明区域失真、细节丢失等问题,难以满足实际生产需求。

- 项目主页:https://donghaotian123.github.io/Wan-Alpha

- GitHub:https://github.com/WeChatCV/Wan-Alpha

- 模型:https://huggingface.co/htdong/Wan-Alpha

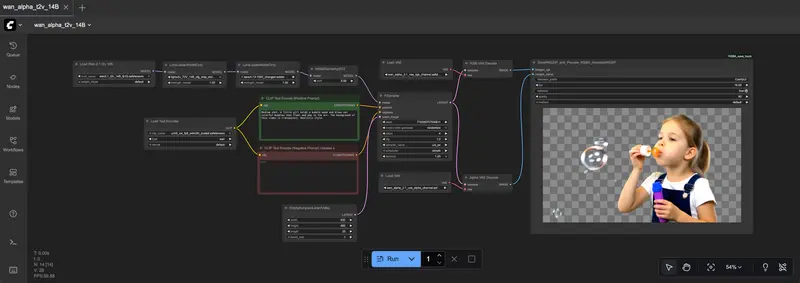

- ComfyUI:https://huggingface.co/htdong/Wan-Alpha_ComfyUI

为解决这一难题,天津大学研究团队基于阿里开源的 Wan2.1 文生视频模型,推出 Wan-Alpha ——一个专注于高质量透明视频生成的新框架。它通过联合建模 RGB 与 Alpha 通道,在保持高效推理的同时,实现了对半透明物体、发光效果、毛发等精细结构的精准渲染。

为什么需要“带 Alpha”的视频生成?

传统视频生成模型输出的是完整的三通道画面(RGB),其像素值隐含了背景信息。如果要将其中的角色或物体提取出来用于合成(如 PPT 动画、直播贴片、AR 效果),必须依赖人工或 AI 进行耗时的“抠像”操作,且结果常因复杂边缘(如发丝、烟雾)而失败。

相比之下,RGBA 视频直接提供第四通道(Alpha)作为透明度掩码,具备以下优势:

| 应用场景 | Alpha 通道价值 |

|---|---|

| 视频剪辑 | 快速合成人物/物体,无需绿幕 |

| 游戏开发 | 生成带透明特效的技能动画、粒子 |

| 社交媒体 | 制作可复用的表情包、动态贴纸 |

| 虚拟人/AI 主播 | 输出无背景角色,适配多直播间 |

Wan-Alpha 的目标,就是让 AI 原生具备生成这种“开箱即用”透明视频的能力。

核心技术:如何实现高质量 Alpha 生成?

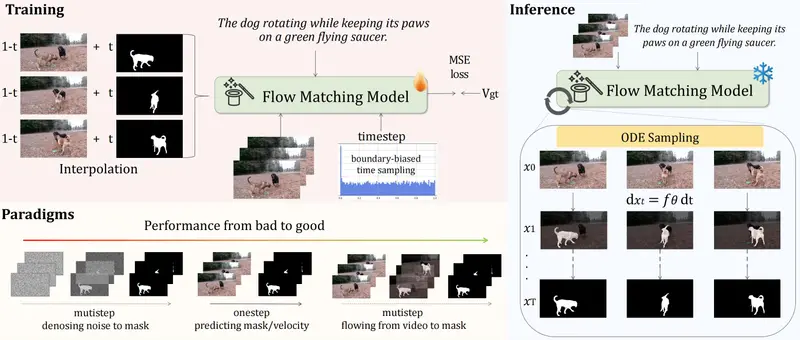

Wan-Alpha 并非简单地将 Alpha 作为第四个颜色通道拼接输入,而是设计了一套端到端的联合学习框架,核心包括两个部分:支持 Alpha 的 VAE 架构 和 轻量级微调策略。

1. 联合编码:RGB 与 Alpha 共享潜在空间

传统方法通常分别编码 RGB 和 Alpha,导致两者语义不一致(例如头发区域 Alpha 掩码与实际颜色错位)。

Wan-Alpha 提出一种特征融合机制:

- 将 RGB 和 Alpha 输入送入共享编码器;

- 在中间层通过因果 3D 卷积模块进行跨通道特征融合;

- 输出统一的潜在表示,供扩散模型使用。

这确保了颜色与透明度在时空维度上的高度对齐。

2. 高效解码:LoRA + DoRA 微调,不增计算负担

为了兼容原始 Wan2.1 模型并降低部署成本,Wan-Alpha 采用轻量级适配方案:

- VAE 解码器:仅用 LoRA 微调 RGB 和 Alpha 分支,保留原权重;

- 扩散变换器:使用 DoRA(Weight-Decomposed Low-Rank Adaptation)进行参数调整,兼顾性能与效率。

✅ 推理时只需加载两个 LoRA 模块和一个 DoRA 模块,不增加额外显存或计算开销。

3. 数据驱动:构建高质量 RGBA 训练集

模型表现很大程度取决于数据质量。团队从多个公开数据集中筛选出高分辨率、标注准确的 RGBA 视频片段,并进行清洗与增强,覆盖多种透明/半透明场景:

- 发光文字与粒子特效

- 玻璃、水滴、烟雾等半透明材质

- 人物发丝、羽毛、纱巾等细粒度边缘

该数据策略有效提升了模型对复杂透明结构的理解能力。

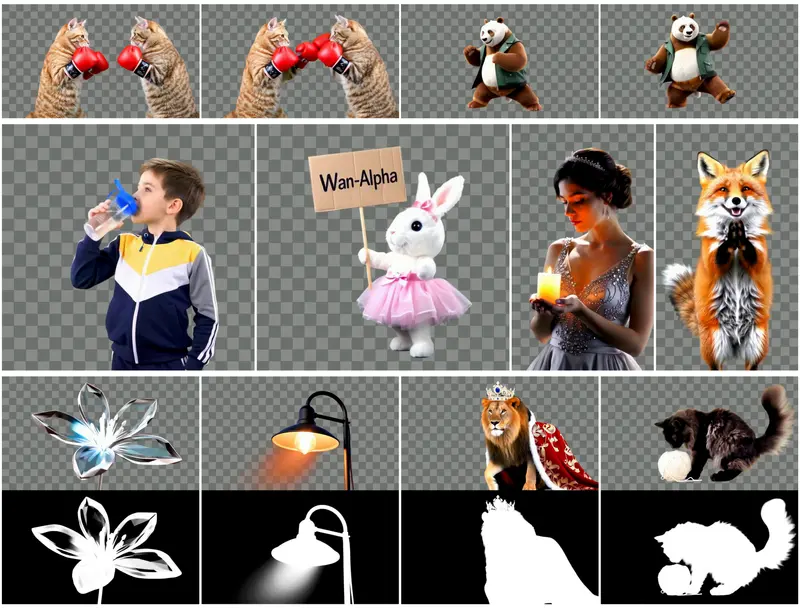

性能表现:更快、更清、更可用

在标准测试任务中,Wan-Alpha 展现出显著优于现有方法的表现:

| 指标 | Wan-Alpha | TransPixeler (open) | 提升 |

|---|---|---|---|

| 推理时间(81帧, 480×832) | 128 秒 | 1920 秒(32分钟) | ↓ 15倍 |

| 视觉质量(用户调研) | 显著更优 | 边缘模糊、闪烁严重 | — |

| 细节还原能力 | 成功生成发丝、光晕、渐变透明 | 多数失败或伪影明显 | — |

定性结果显示,Wan-Alpha 能够稳定生成以下高难度内容:

- 半透明气泡随水流漂动

- 发光粒子沿轨迹运动并逐渐消散

- 人物甩动长发,发丝边缘清晰透明

这些结果表明,模型不仅学会了“什么是透明”,还掌握了其物理规律和动态变化。

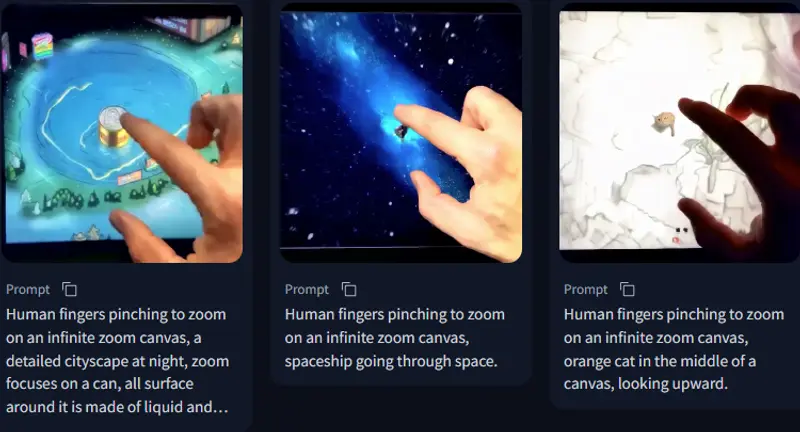

四、多语言支持与实用性

尽管主要训练数据为中文提示,Wan-Alpha 同样支持英文输入生成高质量 RGBA 视频,具备一定的跨语言泛化能力。

典型可用提示示例:

"一个发光的蓝色精灵在森林中飞舞,身后留下半透明的光轨"

"A translucent jellyfish floating in the ocean with soft glowing tentacles"

输出视频可直接导出为 WebM 或 MOV 格式(支持 Alpha),便于集成到主流创作工具(如 After Effects、Premiere、Unity)中。

应用场景展望

Wan-Alpha 的出现,为自动化视觉内容生产开辟了新路径:

✅ 动态素材库自动生成

按需生成带透明背景的图标、表情、转场动画,降低设计成本。

✅ 个性化 AR/VR 内容

结合用户指令实时生成专属贴纸或虚拟装饰。

✅ 智能视频编辑辅助

自动补全缺失帧、扩展背景、添加特效层,提升后期效率。

✅ 具身智能与机器人仿真

为 AI Agent 提供包含深度与透明信息的环境输入。

相关文章