在文本到视频(T2V)生成领域,高分辨率、长时长与低延迟三者往往难以兼得。现有大模型虽能生成高质量视频,但动辄数千秒的推理时间与高昂的训练成本严重限制了其落地应用。

为此,由英伟达、香港大学、麻省理工学院、清华大学、北京大学和阿卜杜拉国王科技大学联合研究团队推出 SANA-Video ——一款专注于高效、低成本、长时序视频生成的小型扩散模型。

该模型能够在单张消费级 GPU 上快速生成分辨率达 720×1280、时长接近一分钟的连贯视频,在保持高质量的同时,将推理速度提升数十倍,训练成本降至主流方案的 1%。

更重要的是,SANA-Video 并非依赖参数堆叠,而是通过两项核心架构创新,从根本上重构了视频扩散的效率边界。

核心挑战:传统注意力为何拖累长视频生成?

当前主流视频扩散模型多基于 DiT(Diffusion Transformer)架构,使用标准自注意力机制处理时空序列。然而,当视频长度增加时,其计算复杂度呈平方级增长:

自注意力复杂度:O(N²),其中 N 是视觉 token 总数

以一段 5 秒、720p、16fps 的视频为例:

- 每帧约 46,656 个 latent token

- 80 帧共产生超过 370 万 token

- 导致显存占用极高,推理耗时长达数十分钟甚至小时级

此外,传统 KV 缓存机制在自回归生成中内存随帧数线性增长,无法支持分钟级连续输出。

SANA-Video 正是为解决这些问题而生。

两大核心技术突破

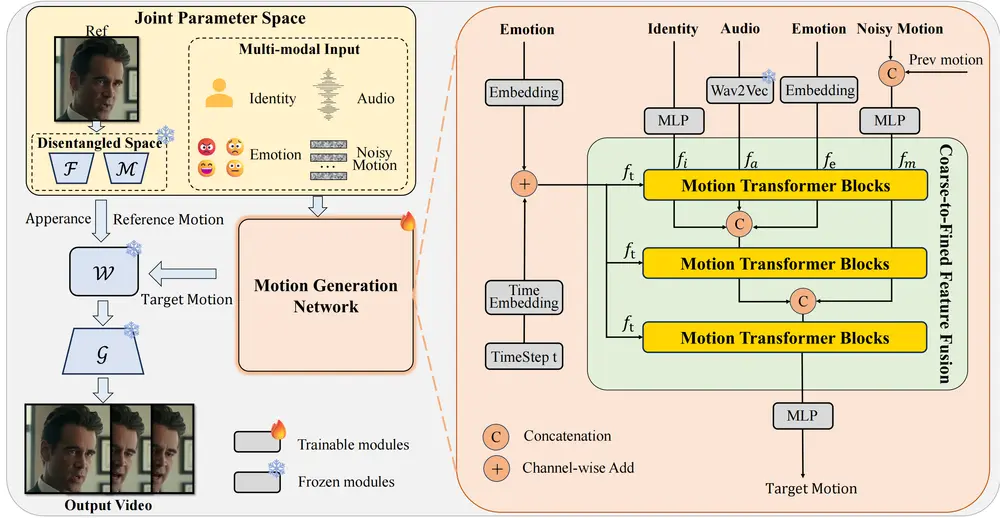

1. 线性 DiT:用 O(N) 替代 O(N²)

SANA-Video 提出 Linear DiT 架构,将传统的 softmax 自注意力替换为线性注意力(Linear Attention),使计算复杂度从 O(N²) 降至 O(N)。

其关键在于:

- 将注意力分解为“核函数映射 + 全局聚合”两个步骤;

- 避免构建巨大的注意力矩阵;

- 显著降低显存占用与计算开销。

在此基础上,模型引入:

- 旋转位置编码(RoPE):增强对时空相对位置的感知能力;

- 时间卷积模块:显式建模帧间运动动态,提升时间连贯性。

这使得模型能在极低资源下处理超长序列。

2. 块线性注意力 + 恒定内存 KV 缓存

为了实现真正意义上的长视频自回归生成,SANA-Video 设计了 Chunk-wise Linear Attention 模块,并构建了一种固定内存的 KV 缓存机制。

工作原理如下:

- 视频被划分为多个时间块(chunks);

- 每个块在去噪过程中,仅需维护一个累积状态向量作为全局上下文;

- 该状态通过线性注意力的可组合性不断更新,无需存储所有历史 Key/Value;

✅ 内存占用恒定,不随视频长度增加

✅ 支持无限时长流式生成(理论上)

这一设计打破了传统 Transformer 在长序列生成中的内存瓶颈,为分钟级乃至更长视频生成提供了可行性基础。

性能表现:快 53 倍,成本降 99%

1. 推理速度大幅提升

| 模型 | 分辨率 | 时长 | 推理时间 | 加速比 |

|---|---|---|---|---|

| Wan2.1-14B | 720p | 5s | 1897 秒 (~31.6 min) | 1× |

| SANA-Video | 720p | 5s | 36 秒 | 53× |

在 RTX 5090 上结合 NVFP4 精度后,生成 5 秒 720p 视频进一步缩短至 29 秒(2.4 倍加速),接近实时交互门槛。

同时支持多种任务:

- 文本到视频(T2V)

- 图像到视频(I2V)

- 条件控制生成(如布局引导)

2. 生成质量对标大型模型

尽管参数规模较小,SANA-Video 在权威评测基准 VBench 上表现优异:

| 任务 | SANA-Video 得分 | 对比模型 |

|---|---|---|

| T2V 综合得分 | 83.71 | ≈ Open-Sora-2.0 (14B),> Wan2.1-1.3B |

| I2V 综合得分 | 88.02 | > Wan2.1-14B, > HunyuanVideo-I2V (11B) |

尤其在运动平滑性、主体一致性、美学质量等维度领先明显,表明其不仅“快”,而且“好”。

3. 训练成本大幅降低

除了核心设计优化,SANA-Video在训练环节也实现了成本突破。研究团队通过探索有效的数据过滤策略与模型训练方法,将训练成本压缩至64个H100 GPU上运行12天——这一成本仅为同类模型MovieGen的1%,大幅降低了高性能视频生成模型的研发门槛。

| 指标 | SANA-Video |

|---|---|

| 训练周期 | 12 天 |

| 硬件需求 | 64 × H100 GPU |

| 总成本 | 仅为 MovieGen 的 1% |

这一成本水平使得中小型机构也能复现和微调先进视频模型,推动技术民主化。

性能与部署:速度快16倍,RTX 5090可落地

低成本并未牺牲性能,SANA-Video在多项关键指标上表现突出,同时兼顾实际部署需求。

- 性能对标先进模型:与现代小型扩散模型(如Wan 2.1-1.3B、SkyReel-V2-1.3B)相比,SANA-Video性能持平,但测得延迟降低16倍,生成效率显著提升。

- 部署效率优化:在RTX 5090 GPU上以NVFP4精度部署时,生成5秒720p视频的推理速度从71秒加速至29秒,实现2.4倍提速;若对比更早期模型(如Wan2.1-14B),生成5秒720p视频的速度更是快了53倍(36秒 vs 1897秒)。

- 多任务支持:除了文本到视频(T2V),还能实现图像到视频(I2V)任务,在VBench评估中,T2V总分达83.71(与大型模型Open-Sora-2.0相当),I2V总分88.02(优于Wan2.1-14B、HunyuanVideo-I2V等模型)。

相关文章