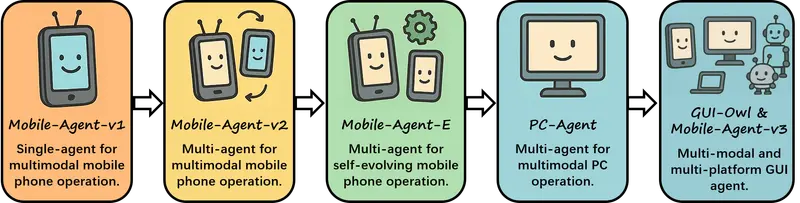

在当今数字化时代,自动化技术的发展日新月异。阿里通义实验室作为行业内的创新先锋,于近期推出了令人瞩目的Mobile-Agent-v3框架,为图形用户界面(GUI)任务的自动化带来了全新的解决方案。

- GitHub:https://github.com/X-PLUG/MobileAgent

- 模型:https://huggingface.co/collections/mPLUG/gui-owl-68a563a2fca8f601c9b53f00

该框架基于GUI-Owl基础模型构建,融合了多模态感知、推理、规划以及动作执行等多种关键能力,能够在移动设备和桌面计算机等多种环境中高效实现GUI自动化,极大地提升了任务执行的效率与便捷性。

Mobile-Agent-v3框架:跨平台GUI自动化的得力助手

Mobile-Agent-v3是一款专为GUI任务自动化打造的框架,依托GUI-Owl模型,它具备在多种设备上执行任务的卓越能力。无论是在移动设备上预订外卖这样涉及多个页面跳转、信息填写的复杂流程,还是在桌面环境中处理文档时的格式调整、内容编辑等操作,Mobile-Agent-v3都能轻松应对。

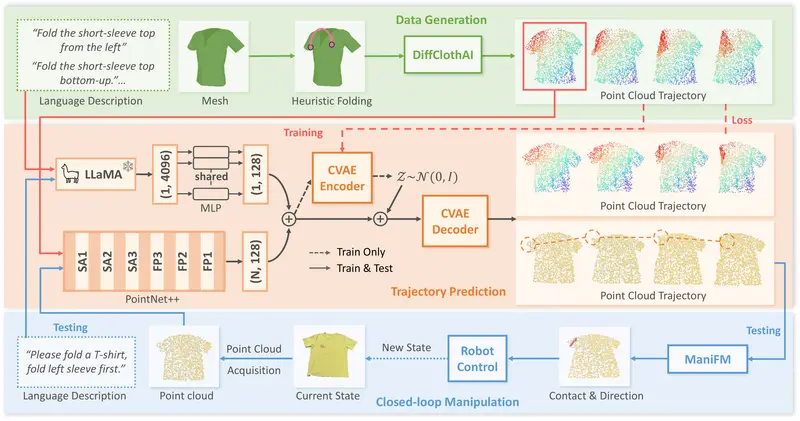

为了提升模型性能,该框架借助大规模的环境基础设施,利用云技术构建起支持多种操作系统的虚拟环境,从而生成丰富多样的交互数据。同时,通过自进化轨迹生成框架,自动对交互轨迹进行评估与优化,减少了对人工标注的依赖,持续提升数据质量,让模型在学习过程中不断进化。

GUI-Owl模型:多模态跨平台的智能核心

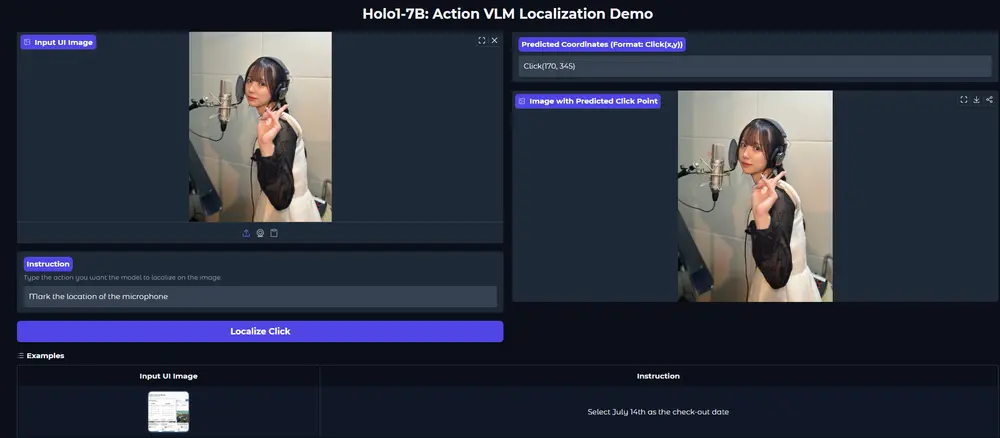

GUI-Owl作为多模态跨平台GUI虚拟层模型(VLM),堪称Mobile-Agent-v3框架的智慧核心。它在7B参数规模下便实现了SOTA(state-of-the-art,即当前最优)结果,是原生的端到端多模态代理,专为GUI自动化而生。

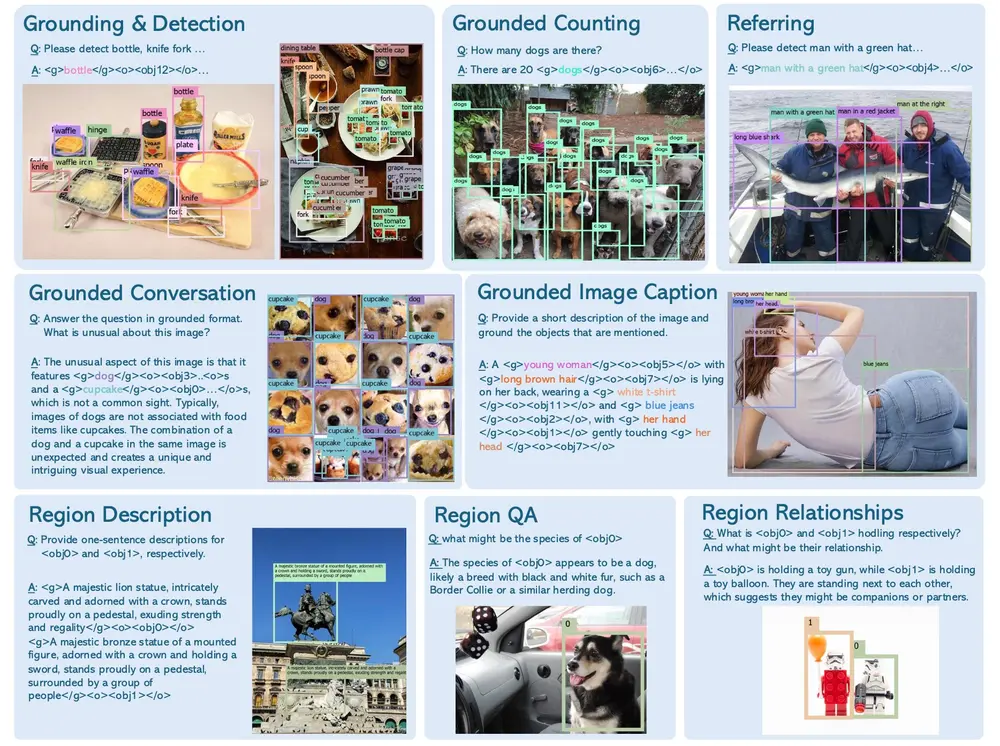

在GUI-Owl的单一策略网络中,巧妙地将感知、基础、推理、规划和动作执行等功能统一起来。这使得它不仅拥有强大的跨平台交互能力,能够无缝对接移动设备(如Android系统)、桌面计算机(包括Windows、macOS、Linux系统)以及网页环境,还擅长处理多轮决策任务,并且具备明确的中间推理功能,在面对复杂操作时能够有条不紊地规划执行步骤。在Mobile-Agent-v3中,GUI-Owl可以实例化为不同的专用智能体,各司其职,协同完成各类任务。

Mobile-Agent-v3框架的主要功能

1. 多平台支持,打破设备壁垒

Mobile-Agent-v3对多种平台的全面支持,让用户无论使用何种设备,都能享受到高效的GUI自动化服务。无论是在出门在外时通过手机处理事务,还是在办公室利用桌面电脑完成工作,该框架都能精准适配,为用户提供一致且流畅的操作体验。

2. 自进化轨迹生成,优化任务执行路径

自进化轨迹生成框架是Mobile-Agent-v3的一大亮点。通过模型自身的评估与优化机制,它能够持续改进交互轨迹的质量。在执行任务过程中,模型会不断分析已有的操作路径,自动识别出更优的执行方式,从而减少不必要的操作步骤,提高任务完成的效率和准确性。例如,在多次预订外卖的过程中,模型会逐渐优化从打开外卖应用、选择商家、挑选菜品到下单支付的整个流程,让后续的预订操作更加快捷。

3. 多智能体协作,攻克复杂任务

在Mobile-Agent-v3框架下,多个智能体能够紧密协作,共同应对复杂任务。每个智能体被赋予不同的角色和任务,它们之间通过明确的分工与高效的协作,提升了复杂任务的执行效率。以在移动设备上规划一次旅行安排为例,一个智能体负责在地图应用中查找目的地及周边景点,另一个智能体在酒店预订应用中筛选合适的住宿,还有智能体负责在交通票务应用中查询并预订车票或机票,最后各个智能体将收集到的信息整合,为用户生成完整的旅行计划。

4. 强化学习,提升决策能力

借助轨迹感知的相对策略优化(TRPO)技术,Mobile-Agent-v3能够在在线环境中进行强化学习。通过给予模型轨迹级奖励,激励其在长序列任务中不断改进决策。比如在处理一系列文档编辑任务时,模型会根据每一步操作所带来的结果反馈,调整后续的决策策略,使得最终的文档处理结果更符合用户预期,在不断尝试与学习中,模型的决策能力得以逐步提升。

Mobile-Agent-v3框架的主要特点

1. 大规模环境基础设施,提供丰富数据支撑

利用云技术构建的大规模虚拟环境,能够模拟出多样化的设备和软件环境,为Mobile-Agent-v3生成海量且丰富的交互数据。这些数据涵盖了各种操作系统、应用程序以及用户操作场景,为模型的训练与优化提供了坚实的数据基础,让模型能够学习到更广泛、更全面的操作模式和应对策略。

2. 自进化轨迹生成,持续提升任务执行质量

如前文所述,自进化轨迹生成这一特点并非一次性的优化,而是一个持续的过程。随着模型不断接触新的任务和数据,其对交互轨迹的评估和优化也在不断深入,从而使任务执行质量得到持续提升,能够更好地适应日益复杂多变的用户需求和应用场景。

3. 多智能体协作能力,高效应对复杂场景

多智能体之间的协作并非简单的任务分配,而是基于智能体各自的优势和特点,形成有机的协同体系。它们在复杂场景中能够相互配合、信息共享,避免重复劳动和错误决策,极大地提高了整个框架在处理复杂任务时的成功率和效率,为用户解决实际问题提供了有力保障。

4. 强化学习框架,适应动态任务需求

强化学习框架使得Mobile-Agent-v3能够在动态变化的在线环境中不断进化。无论是面对新出现的应用程序,还是用户提出的特殊操作要求,模型都能通过强化学习,快速调整自身策略,适应新的任务需求,展现出强大的灵活性和适应性。

Mobile-Agent-v3的工作原理

1. 自进化轨迹生成框架驱动任务优化

自进化轨迹生成框架在Mobile-Agent-v3的工作流程中起着关键的优化作用。当模型接收到用户的任务指令后,首先会基于已有的知识和经验生成初始的交互轨迹。在执行任务过程中,框架会实时监控任务执行情况,收集相关数据,并依据特定的评估指标对当前的交互轨迹进行评估。如果发现当前轨迹并非最优,框架会自动触发优化机制,通过调整模型参数或改变操作顺序等方式,生成更优的交互轨迹,确保任务能够以最高效的方式完成。

2. 多智能体协作实现任务分解与执行

在面对复杂任务时,多智能体协作机制开始发挥作用。Mobile-Agent-v3会根据任务的性质和特点,将其分解为多个子任务,并分配给不同的智能体。每个智能体利用自身所具备的特定能力和知识,独立完成各自负责的子任务。例如,在处理一个涉及数据分析和报告生成的桌面任务时,负责数据处理的智能体先对原始数据进行清洗、分析,然后将处理后的数据传递给负责文档编辑的智能体,由其生成报告文档。各个智能体在完成子任务的过程中,会实时与其他智能体进行信息交互,确保整个任务的执行过程协调一致。

3. 强化学习助力长序列任务决策

在长序列任务执行过程中,强化学习机制为Mobile-Agent-v3提供了有力的决策支持。模型在每执行一步操作后,都会根据环境反馈获得一个奖励信号,这个奖励信号反映了该操作对完成最终任务的贡献程度。模型通过不断调整自身的策略,试图最大化长期累积奖励。比如在一个需要连续操作多个应用程序完成项目策划的任务中,模型会根据每一次操作后所获得的奖励(如是否成功获取关键信息、操作是否符合项目逻辑等),学习到在不同状态下应该采取的最优行动,从而在后续遇到类似任务时,能够做出更合理、更高效的决策。

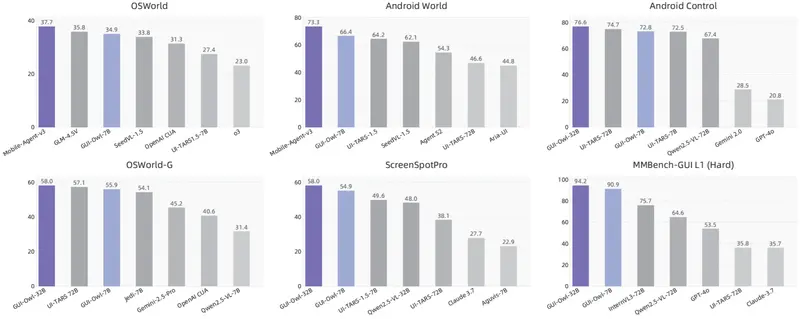

测试结果彰显卓越性能

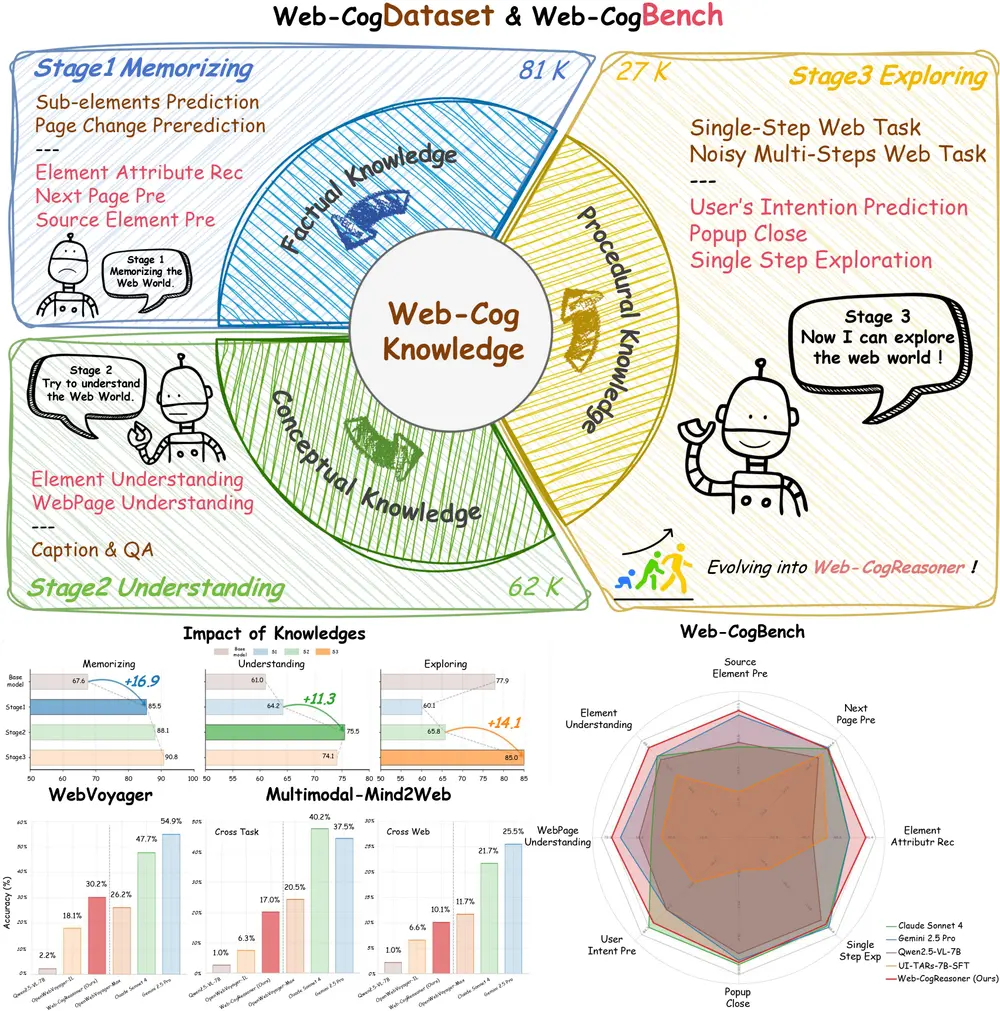

为了验证GUI-Owl和Mobile-Agent-v3的性能,研究团队在多个基准测试中进行了严格测试,结果令人惊艳:

- 在ScreenSpot-V2测试中,涵盖移动、桌面和网页环境,GUI-Owl-7B的平均得分高达92.8,大幅领先于其他模型,充分证明了其在多平台环境下对GUI元素的精准感知与操作能力。

- OSWorld-G测试专注于评估模型的UI理解和单步决策能力,GUI-Owl-7B取得了86.9的高分,GUI-Owl-32B更是达到了90.9,展现出强大的理解与决策水平。

- 在AndroidWorld和OSWorld的在线环境测试中,Mobile-Agent-v3分别获得了73.3和37.7的得分,显著优于其他对比模型,突出了其在实际在线应用场景中的高效性与稳定性。

阿里通义实验室推出的Mobile-Agent-v3框架,凭借其创新的架构设计、强大的功能特性以及卓越的性能表现,为GUI自动化领域树立了新的标杆。随着该框架在更多场景中的应用与推广,有望为广大用户带来更加便捷、高效的数字化体验,推动各行业在数字化转型进程中迈出坚实的步伐。

相关文章