在大模型迈向“深度思考”的关键阶段,蚂蚁集团迈出重要一步:其自研的万亿参数自然语言推理大模型 Ring-1T-preview 正式上线 Hugging Face,成为全球首个开源的万亿参数级推理专用大模型。

- Hugging Face:https://huggingface.co/inclusionAI/Ring-1T-preview

- 魔塔:https://modelscope.cn/models/inclusionAI/Ring-1T-preview

该模型基于 Ling-2.0 MoE 架构构建,在 20T token 的大规模语料上完成预训练,并通过自研高效强化学习系统 ASystem 进行了针对推理能力的专项优化(RLVR 训练)。此前广受关注的“棒冰”方法(icepop)也已应用于训练流程中。

目前,Ring-1T 仍在持续训练中。此次发布的 preview 版本旨在推动社区对超大规模思考型模型的能力探索与共建迭代。

性能表现:逼近 GPT-5,在多项权威测试中领先开源模型

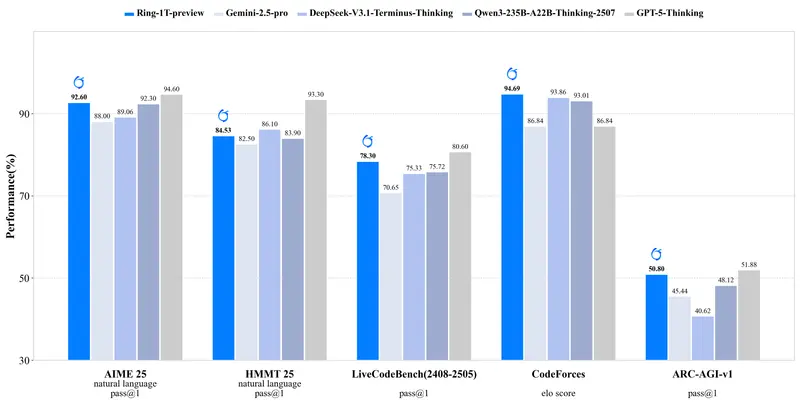

尽管仍处于预览阶段,Ring-1T 已展现出卓越的自然语言推理能力,在多个高难度基准测试中达到国际前沿水平:

| 测试项目 | Ring-1T-preview 成绩 | 对比模型 |

|---|---|---|

| AIME 2025(美国数学邀请赛) | 92.6 分 | 超越所有已知开源模型及 Gemini 2.5 Pro;接近 GPT-5(无工具使用)的 94.6 分 |

| CodeForces(竞赛级编程) | 94.69 分 | 超过 GPT-5 |

| LiveCodeBench v6 | 开源模型第一 | 显著优于 Llama 系列及其他主流开源模型 |

| ARC-AGI-v1(抽象与类比推理) | 开源模型首位 | 展现出对复杂模式识别与逻辑构造的支持潜力 |

这些结果表明,Ring-1T 不仅具备强大的语言理解能力,更能在数学推导、算法设计和抽象思维任务中实现接近人类专家水平的表现。

技术架构:从基础模型到“会思考”的演进

Ring-1T 是基于 Ling-2.0 MoE 架构 打造的 1T 参数基础语言模型的“思考版本”(reasoning-tuned),其核心技术路径包括:

1. 高效 MoE 设计

采用稀疏激活的混合专家架构(Mixture-of-Experts),在保证万亿参数表达能力的同时控制计算成本,提升推理效率。

2. 大规模强化学习训练(RLVR)

通过自研系统 ASystem 实现高效的推理向强化学习训练。其中,框架 AReaL 已开源(GitHub 可查),支持多步推理策略优化、反馈建模与动态奖励分配。

3. icepop 方法应用

结合此前公开的 icepop 方法(iterative chain-of-thought prompting with policy optimization),在低资源条件下模拟高质量思维链生成过程,辅助大规模 RL 训练的数据构建。

这一整套技术体系的目标明确:让超大规模模型真正具备“逐步推理”而非“模式匹配”的能力。

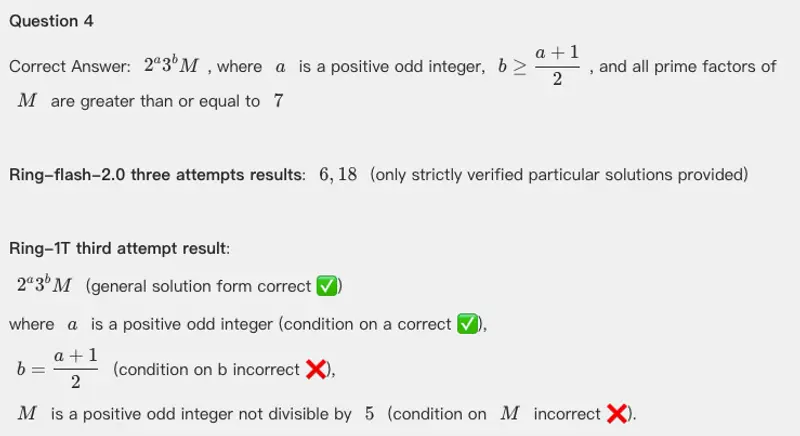

实测案例:在 IMO 数学难题中展现高级推理潜力

为验证 Ring-1T 的极限推理能力,团队将其集成至多代理协作框架 AWorld(GitHub 地址),并在 IMO 2025(国际数学奥林匹克竞赛)题目上进行纯自然语言推理测试。

注:IMO 是全球最具挑战性的高中生数学赛事之一,题目通常需要构造性证明、反例设计、归纳推理等高级思维技能。

测试设置如下:

- 允许单次推理尝试;

- 不调用外部工具或代码执行;

- 输出全程以自然语言展开。

结果如下:

- Ring-1T 在一次尝试中成功解出第3题;

- 对第1、2、4、5题给出部分正确推理路径;

- 相比之下,Ring-flash-2.0 在三次尝试后才解出第3题。

这说明 Ring-1T 在洞察力、逻辑严密性和问题拆解能力方面已有显著提升,初步具备处理高度抽象问题的潜力。

为何现在开源预览版?

尽管 Ring-1T 仍在训练中,但团队认为其当前状态已具备足够的研究价值。提前开源的目的在于:

- 加速社区验证与反馈:鼓励学术界和开发者测试其在数学、编程、逻辑推理等场景下的表现;

- 推动“思考型模型”技术发展:探索如何更好地训练、评估和部署具备深度推理能力的大模型;

- 共建开放生态:AReaL 框架已开源,未来计划逐步开放更多训练方法与数据流程。

官方也坦承当前版本存在若干局限:

- 存在语言混杂现象(如中英文夹杂);

- 部分输出出现重复推理步骤;

- 在角色扮演或多视角任务中可能出现身份误认。

这些问题将在后续训练中持续优化。

相关文章