今日,智谱 AI 正式推出其最新旗舰文本模型 GLM-4.6,作为 GLM 系列的最新迭代版本,该模型在推理、编码与智能体能力上实现全面升级,定位为当前国内最强的代码专用大模型。

- 项目主页:https://z.ai/blog/glm-4.6

- GitHub:https://github.com/zai-org/GLM-4.5

- Hugging Face:https://huggingface.co/zai-org/GLM-4.6

- 魔塔:https://modelscope.cn/models/ZhipuAI/GLM-4.6

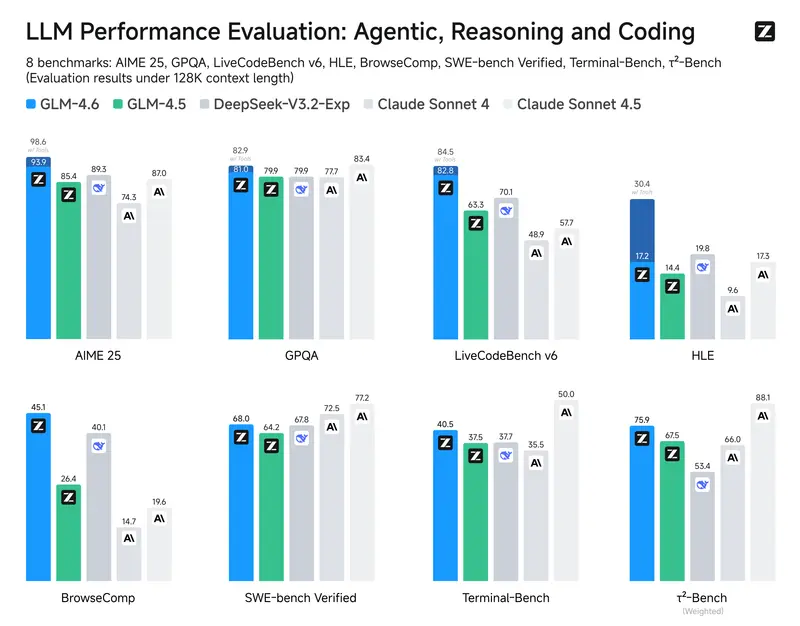

据官方披露,GLM-4.6 在综合代码能力上相较前代 GLM-4.5 提升达 27%,并在真实编程任务中表现对齐国际主流闭源模型 Claude Sonnet 4,部分场景下甚至超越。

目前,GLM-4.6 已上线智谱 MaaS 平台 bigmodel.cn,并同步开源至 Hugging Face 与 ModelScope,遵循 MIT 协议,支持社区自由使用与研究。

核心升级:从参数到能力的系统性提升

| 特性 | GLM-4.5 | GLM-4.6 |

|---|---|---|

| 总参数量 | 未公开 | 355B |

| 激活参数量 | ~32B | 32B(MoE 架构) |

| 上下文长度 | 128K | 200K |

| 推理中工具调用 | 支持有限 | ✅ 原生支持 |

| 开源协议 | MIT | MIT |

1. 更长上下文:200K 支持复杂任务

上下文窗口从 128K 扩展至 200K,显著增强对大型项目文件、多轮交互轨迹和长链推理任务的支持,尤其适用于代码审查、Agent 自主规划等高阶场景。

2. 编码能力跃升:对齐 Claude Sonnet 4

在多个公开基准测试中,GLM-4.6 的代码生成与理解能力达到国际先进水平:

- AIME 2025(数学推理)

- LiveCodeBench v6(竞赛级编程)

- SWE-Bench Verified(真实 GitHub issue 修复)

- τ²-Bench(工具调用与脚本生成)

在国产模型中位列第一,整体性能接近 Claude Sonnet 4 / 4.5,虽在极端复杂任务上仍有差距,但已具备实战替代潜力。

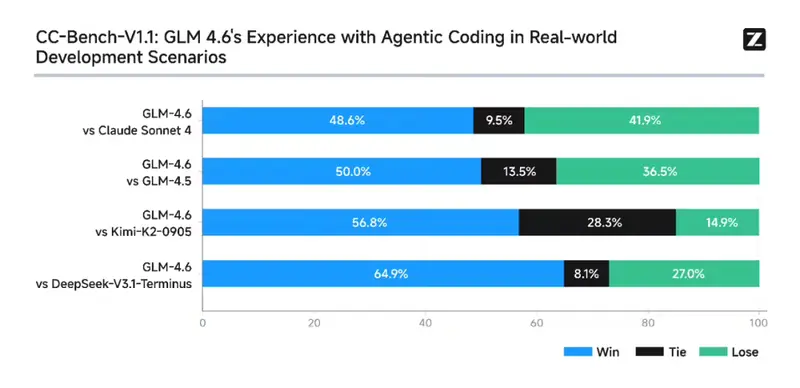

真实场景验证:CC-Bench 测试再升级

榜单分数只是起点。为了更准确评估模型在实际开发中的表现,智谱延续了其自建评测体系 CC-Bench ——一套基于真实编程任务的代理(Agent)行为轨迹测试框架。

本次测试包含 74 个真实编程任务,覆盖六大领域:

- 前端开发(HTML/CSS/JS 小工具)

- 应用开发(React、Node.js、Go 后端服务)

- UI/UX 优化(响应式布局、动效改进)

- 构建与部署(CI/CD 配置、Dockerfile 调优)

- 数据分析(Pandas 处理、可视化)

- 机器学习(图像识别、聚类算法)

所有任务均在独立 Docker 容器中运行,由同一评测人员以多轮人机协作方式推进,确保公平性。

测试结果概览:

| 对比项 | 结果 |

|---|---|

| 任务完成率 vs Claude Sonnet 4 | 48.6% 胜率(基本持平) |

| 胜率 vs 其他国产模型 | 显著领先 |

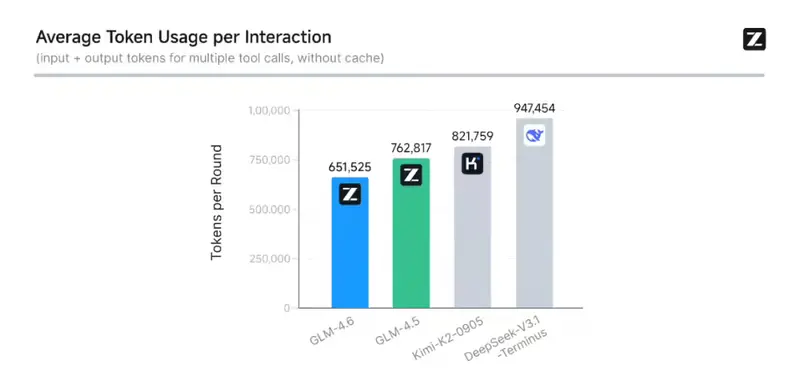

| 平均 token 消耗 vs GLM-4.5 | 减少 30%+,同类最低 |

| 工具调用成功率 | 提升至 92% 以上 |

这意味着:GLM-4.6 不仅“能做”,而且“做得更快、花得更少”。

值得一提的是,智谱已将全部测试题目与 Agent 交互轨迹开源,托管于 Hugging Face 数据集:

🔗 https://huggingface.co/datasets/zai-org/CC-Bench-trajectories

此举极大提升了评测透明度,也为行业提供了可复现的 Agent 能力评估范式。

智能体能力强化:不只是写代码,更是“会思考的程序员”

GLM-4.6 的进步不仅体现在代码生成质量上,更在于其作为“AI 编程代理”的成熟度:

✅ 支持推理过程中动态调用工具

模型可在思维链(Chain-of-Thought)中主动判断是否需要执行 read_file、execute_command 或 search_web 等操作,并在获取反馈后继续推理,形成闭环。

✅ 增强搜索与工具调度能力

在 BrowseComp 和 Terminal-Bench 等涉及浏览器或终端控制的任务中,GLM-4.6 表现优于多数开源模型,能够准确解析网页结构、定位元素、执行命令并处理输出。

✅ 写作与角色扮演更自然

除技术能力外,在文档撰写、API 注释生成、用户沟通等软技能方面也有提升,语言风格更贴近人类工程师,减少机械感表达。

国产芯片适配:首次实现 FP8+Int4 混合量化部署

为推动国产算力生态落地,智谱宣布 GLM-4.6 已成功在 寒武纪 国产芯片上完成 FP8 + Int4 混合量化部署,这是国内首个在此类芯片上投产的 FP8+Int4 模型解决方案。

- 在保持精度损失可控的前提下,推理成本大幅降低;

- 支持更高吞吐与更低延迟,适用于企业级 MaaS 服务。

同时,在 摩尔线程 新一代 GPU 上,基于原生 FP8 精度与 vLLM 推理框架,GLM-4.6 可稳定高效运行,验证了 MUSA 架构在大模型支持上的兼容性与性能潜力。

这些组合方案即将通过智谱 MaaS 平台向公众和企业开放,标志着国产“大模型 + 国产芯片”一体化路径迈出关键一步。

产品化进展:GLM Coding Plan 全面升级

随着 GLM-4.6 发布,智谱同步升级其编程专属订阅服务 GLM Coding Plan:

📦 个人版更新:

- 包月套餐价格不变(最低 20 元/月),自动升级至 GLM-4.6;

- 新增能力:

- 图像识别与视觉搜索

- 支持集成 Claude Code、Roo Code、Kilo Code、Cline 等 10+ 主流编程 Agent 工具

🏢 企业版上线:

- 提供定制化部署、私有化接入与 SLA 保障;

- 支持大规模团队协作与审计追踪。

⚡ 高频用户专享:GLM Coding Max

针对重度开发者推出 Max 套餐,提供 Claude Max (20x) 计划 3 倍用量,满足高强度开发需求。

相关文章