在文本到图像(Text-to-Image, T2I)生成领域,一个长期存在的困境是:开源模型越做越像,却始终难以真正“理解”复杂指令。

问题不在架构,而在数据与评估 —— 缺乏大规模、注重语义推理的训练数据集,也缺少能够真实衡量“是否听懂了”的评测基准。

- 项目主页:https://flux-reason-6m.github.io

- GitHub:https://github.com/rongyaofang/prism-bench

- 数据:https://huggingface.co/datasets/LucasFang/FLUX-Reason-6M

为此,来自香港中文大学、香港大学、北京航空航天大学、阿里巴巴和商汤科技的研究团队联合推出两项重磅资源:

- FLUX-Reason-6M:首个专为“推理能力”设计的百万级双语T2I数据集;

- PRISM-Bench:一套全面、判别性强、与人类判断高度一致的新型评估基准。

它们共同构成了一套完整的“训练+评测”基础设施,旨在推动开源T2I模型向更高阶的认知能力迈进。

核心目标:让AI不只“画得像”,更要“想得清”

当前主流T2I模型多依赖海量图文对进行训练,但这些数据普遍存在两个问题:

- 描述简单:如“一只狗在草地上奔跑”,缺乏空间关系、风格控制或逻辑嵌套;

- 无推理过程:模型无法学习“如何一步步构建画面”。

这导致模型面对复杂提示时容易出错,例如:

“一位穿着印有‘Dream’字样的黑色T恤的男子,站在标有‘Reality’的红色门旁,天空中有用发光字体写着‘Awake’的云朵。”

这类任务需要理解实体、文本渲染、位置布局、语义隐喻等多重推理。而 FLUX-Reason-6M 正是为了教会模型“拆解问题、逐步生成”而生。

FLUX-Reason-6M:600万张图,教AI“思考式作画”

基本信息

| 项目 | 数据 |

|---|---|

| 图像数量 | 600万张 |

| 描述文本 | 2000万条(英/中双语) |

| 构建耗时 | 4个月 |

| 计算资源 | 128 × A100 GPU |

这是目前最大规模、最系统化的推理导向T2I数据集,完全开源,供全球研究者使用。

多维度内容框架

数据集围绕六个关键维度组织,覆盖从基础元素到创造性表达的完整谱系:

| 维度 | 说明 |

|---|---|

| Imagination(想象) | 超现实、抽象概念可视化 |

| Entity(实体) | 对象识别、数量控制、属性绑定 |

| Text Rendering(文本渲染) | 图像内文字内容准确呈现 |

| Style(风格) | 艺术流派、媒介模拟(油画、像素风等) |

| Affection(情感) | 氛围、情绪传递(欢快、忧郁等) |

| Composition(构图) | 空间布局、视角、层次结构 |

每个维度都有精细标注和难度分级,支持定向训练与分析。

核心创新:生成思维链(GCoT)

这是 FLUX-Reason-6M 的灵魂所在 —— Generation Chain-of-Thought(GCoT)。

每条提示都附带详细的生成步骤分解,例如:

Prompt: “一只坐在标有‘奇妙’的粉色纸箱里的可爱约克夏犬,周围环绕着柔软的羽毛和鲜艳的粉色花朵。”

GCoT:

1. 主体:一只可爱的约克夏犬,坐姿;

2. 背景容器:一个打开的粉色纸箱,侧面清晰标有中文“奇妙”;

3. 周围元素:轻盈的白色羽毛散落四周,几朵亮粉色玫瑰点缀其间;

4. 风格:柔和光影,卡通写实混合风格;

5. 构图:中心对称,狗位于视觉焦点。

通过这种结构化监督信号,模型不仅能学会“画什么”,还能掌握“怎么一步步构思”。

数据构建流程

整个数据管道高度自动化,包含以下环节:

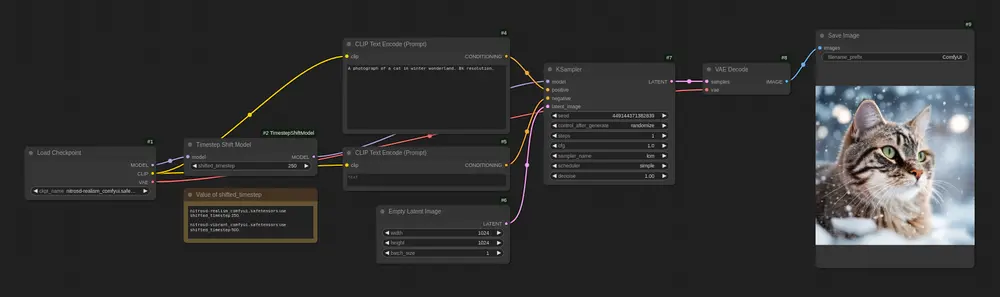

- 使用 FLUX.1-dev 模型生成高质量图像;

- 利用 VLMs(视觉语言模型)反推描述并生成 GCoT;

- 多轮过滤去噪、质量打分与人工校验;

- 中英文互译与一致性对齐。

最终产出的数据兼具多样性、准确性与教学价值。

PRISM-Bench:比人类更懂“好不好”

有了好数据,还需要一个可靠的“考官”。于是团队推出了 PRISM-Bench —— 当前最全面的T2I评估基准。

设计理念

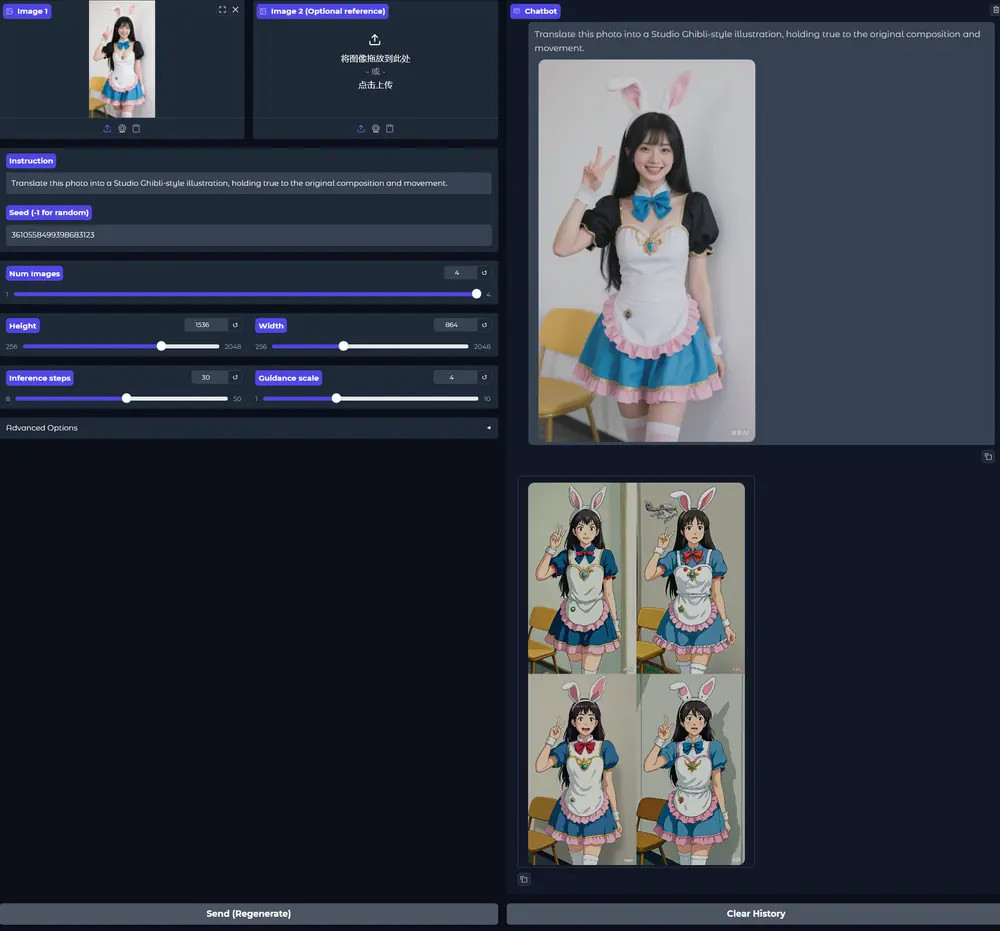

传统自动指标(如CLIP Score)往往与人类感知脱节。PRISM-Bench 的目标是:

用先进的VLM作为“代理评委”,实现接近人类判断的细粒度评分。

它包含 7个独立赛道,每个赛道含100个精心设计的提示,总计700个测试案例。

| 赛道 | 测试重点 |

|---|---|

| Imagination | 抽象概念具象化能力 |

| Entity | 实体完整性与属性匹配 |

| Text Rendering | 图像内文本准确性 |

| Style | 风格一致性与还原度 |

| Affection | 情绪氛围传达 |

| Composition | 布局合理性与美学 |

| Long-Text | 长指令理解与信息保留 |

其中,“Long-Text”赛道特别具有挑战性,要求模型处理超过50词的复杂指令。

评估方式

采用两阶段评估协议:

- 对齐性评估:判断图像是否忠实反映提示内容;

- 美学质量评估:评价图像本身的视觉美感。

评估由 GPT-4.1 和 Qwen2.5-VL-72B 等顶级VLM执行,结合定制提示模板,确保结果稳定且可复现。

同时发布中文版本 PRISM-Bench-ZH,专门测试模型对中文提示的理解能力。

实测结果:揭示现状与差距

研究人员在 PRISM-Bench 上对 19个领先T2I模型 进行了系统评测,包括:

- 闭源模型:Gemini 2.5-Flash-Image、GPT-Image-1

- 开源模型:Qwen-Image、Stable Diffusion 系列、FLUX.1-Krea-dev 等

主要发现:

- 闭源模型整体领先,尤其在 Imagination、Style 和 Long-Text 赛道表现突出;

- 开源模型在部分任务上具备竞争力,尤其是在 Entity 和 Composition 方面;

- 所有模型在 Text Rendering 和 Long-Text 上得分普遍偏低,说明:

- 文本生成仍不稳定(常拼错、变形);

- 长指令信息丢失严重,难以完整响应。

📌 这表明:推理能力仍是T2I系统的共性短板,亟需针对性改进。

为什么重要?不只是两个工具

FLUX-Reason-6M 与 PRISM-Bench 的意义远超单一数据集或基准:

| 意义 | 说明 |

|---|---|

| ✅ 填补训练空白 | 提供首个面向“推理工程化”的大规模数据,使模型可被系统性地教导“如何思考”。 |

| ✅ 统一评测标准 | 结束“各测各的”混乱局面,提供可横向比较的权威 benchmark。 |

| ✅ 推动公平竞争 | 所有资源全部开源,降低研究门槛,让更多团队参与前沿探索。 |

| ✅ 指明改进方向 | 实测结果揭示具体薄弱环节,为后续研究提供清晰路线图。 |

这是一次典型的“基础设施级”贡献 —— 不直接提出新模型,却为整个领域铺好了前进的道路。

相关文章