在文生图模型日益成熟的今天,提升生成质量已不再是唯一目标——如何让图像真正符合人类的审美偏好,成为更高阶的挑战。

现有方法通常依赖强化学习或可微奖励机制,将模型输出与人类偏好对齐。但这些方法普遍存在两个瓶颈:

- 计算成本高:需多步去噪并逐层反向传播梯度,训练耗时且资源密集;

- 依赖离线微调:为获得理想风格(如照片级真实感),必须预先训练专用奖励模型,灵活性差。

针对这些问题,腾讯混元团队联合香港中文大学(深圳)、清华大学深圳国际研究生院提出 Direct-Align ——一种全新的在线强化学习框架,首次实现对整个扩散轨迹的直接、高效对齐。

- 项目主页:https://tencent.github.io/srpo-project-page

- GitHub:https://github.com/Tencent-Hunyuan/SRPO

- 模型:https://huggingface.co/rockerBOO/flux.1-dev-SRPO

其核心思想是:

不再逐步优化去噪过程,而是通过预设噪声先验 + 单步图像恢复,从任意时间步直接重建原始图像,并结合语义感知的动态奖励机制进行端到端优化。

该方法已在 FLUX.1.dev 模型上验证效果:仅用不到10分钟训练,就在人类评估中实现真实感提升3.7倍、美学质量提升3.1倍,同时显著降低对专用奖励模型的依赖。

问题本质:为什么“后期微调”不够用?

当前主流偏好对齐方法(如GRPO、ReFL)通常只在扩散过程的后期几个时间步进行优化。原因在于:

- 多步去噪 → 多次前向+反向 → 计算开销呈指数增长;

- 早期高噪声状态下难以提取有效语义信息,导致奖励信号不可靠。

这带来两个后果:

- 优化范围受限,无法影响整体生成路径;

- 容易引发“奖励作弊”——模型学会迎合局部评分规则(如过度饱和、特定构图),而非真正提升质量。

Direct-Align 的突破在于:打破“必须逐步去噪”的思维定式,让模型能在任意时间步快速还原图像内容,从而在整个扩散轨迹上实施稳定优化。

核心技术:两个关键创新

1. 直接对齐(Direct-Align)——从噪声中“一键还原”图像

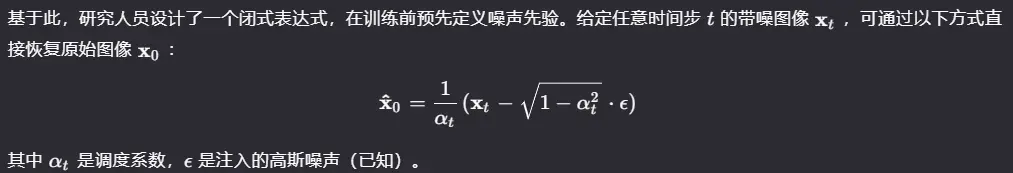

Direct-Align 的核心假设是:

扩散过程中的每一步状态,都是原始图像与噪声之间的线性插值。

这意味着:

- 无需运行完整去噪流程;

- 可在任意时间步(包括早期高噪声阶段)快速重建清晰图像;

- 奖励计算可在单步内完成,大幅降低计算负担。

这一机制使得优化不再局限于后期低噪声阶段,而是覆盖整个扩散轨迹,从根本上提升了控制粒度。

2. 语义相对偏好优化(SRPO)——用文本动态调节奖励

传统方法使用固定奖励模型打分,一旦部署就难以调整。Direct-Align 提出 SRPO(Semantic Relative Preference Optimization),将奖励建模为文本条件驱动的动态信号。

具体做法如下:

- 对每个样本生成两个分支:

- 正提示分支:如“高质量摄影风格”

- 负提示分支:如“卡通化、过饱和、模糊”

- 分别计算两者的奖励得分;

- 构建相对奖励:

这种设计带来了三大优势:

✅ 减少奖励作弊:负反馈直接抑制不良模式(如颜色溢出),无需KL正则或额外判别器;

✅ 支持在线调整:用户可通过修改提示词实时引导风格偏好;

✅ 降低离线微调需求:无需为每种风格单独训练奖励模型。

例如,在生成“一个年轻女孩在黑暗森林中骑着灰色狼”时,系统不仅能判断图像是否符合描述,还能根据“暗黑奇幻风”或“纪实摄影感”等指令动态调整奖励权重,确保输出既准确又具艺术表现力。

训练效率革命:10分钟完成高质量微调

得益于单步恢复与轻量级奖励机制,Direct-Align 实现了惊人的训练效率。

| 方法 | 训练时间 | 性能提升 |

|---|---|---|

| DanceGRPO | ~12小时 | 基准水平 |

| Direct-Align | <10分钟 | ↑5.9×真实感, ↑8.7×美学 |

关键优化点包括:

- 仅需生成一张图像即可完成一次完整优化;

- 支持完全使用小型真实图像数据集替代在线采样(仅需约1500张图像);

- 梯度通过解析方式直接回传至U-Net,避免重复前向计算。

这是目前首个能在分钟级时间内完成全流程微调的在线RL方法,极大降低了部署门槛。

实验结果:全面超越现有方案

1. 自动评估指标

在 Aesthetic Score v2.5、PickScore、ImageReward 和 HPSv2.1 等主流奖励模型下,Direct-Align 均显著优于基线 FLUX 模型。

2. 人类评估表现

在双盲测试中,评审员被要求比较生成图像的真实感与美学质量:

| 对比对象 | 真实感提升 | 美学质量提升 |

|---|---|---|

| Baseline FLUX | 3.7× | 3.1× |

| DanceGRPO | 5.9× | 8.7× |

尤其在光影细节、材质质感和场景合理性方面,Direct-Align 输出更具“无AI感”的自然表现。

3. 抗奖励作弊能力

在多种不同奖励函数测试下,模型均未出现过拟合现象(如色彩偏移、重复纹理),证明其具备良好的泛化性与稳定性。

相关文章