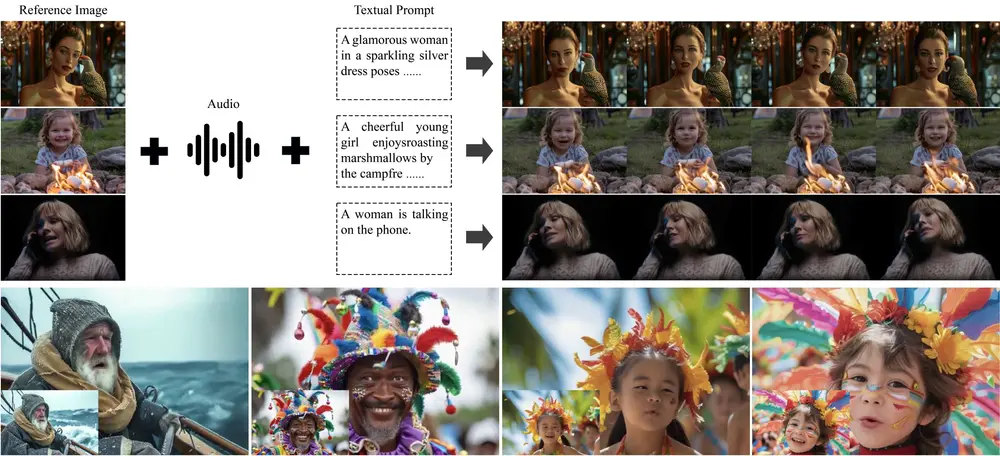

一段文字描述 + 一张人物照片 + 一段语音音频,能否生成一个口型同步、动作自然、形象一致的高质量人物视频?

现在,可以了。

清华大学与字节跳动智能创作团队合作推出 HuMo(Human-Centric Video Generation via Collaborative Multi-Modal Conditioning),一个专注于人类视频生成(HCVG)的新一代多模态生成框架。它支持从文本、图像和音频的任意组合输入中,生成高保真、可控性强的人类活动视频。

- 项目主页:https://phantom-video.github.io/HuMo

- GitHub:https://github.com/Phantom-video/HuMo

- 模型:https://huggingface.co/bytedance-research/HuMo

无论是虚拟主播、数字人内容创作,还是个性化短视频制作,HuMo 都展现出强大的灵活性与实用性。

三种输入方式,满足不同创作需求

HuMo 的核心优势在于其对多模态输入的灵活支持,用户可根据已有资源自由选择输入组合:

✅ 文本 + 图像 → 视频

输入一段文字描述和一张参考图(如真人照片或角色设定图),生成符合描述的动作视频,且人物外貌保持高度一致。

示例:输入“一位穿红色旗袍的女性在雨中撑伞行走”,并附上某演员的照片,HuMo 可生成该演员形象在相应场景下的动态视频。

✅ 文本 + 音频 → 视频

无需提供图像,仅通过文本提示和语音音频即可生成口型同步的人物视频。适用于有声书、播客可视化等场景。

模型会自动构建合理的人物外观,并确保唇部运动与语音节奏精准匹配。

✅ 文本 + 图像 + 音频 → 视频

三者协同控制,实现最高级别的定制化:

- 外观来自参考图像,

- 动作由文本引导,

- 唇部与音频严格同步。

这是目前最接近“可控数字人”的生成模式。

关键技术:如何实现高质量协同生成?

HuMo 并非简单拼接多模态信息,而是通过一套系统性设计,让文本、图像、音频在生成过程中协同作用。

1. 高质量多模态数据集构建

研究团队构建了一个大规模配对数据集,包含:

- 精确对齐的文本描述;

- 与主体语义一致但视觉不同的参考图像(通过跨视频检索获得);

- 经过语音增强和唇形对齐校验的音频片段。

这为模型学习“同一人物在不同表现形式下的统一性”提供了坚实基础。

2. 两阶段训练范式

为避免多任务干扰,HuMo 采用分阶段训练策略:

| 阶段 | 目标 |

|---|---|

| 第一阶段 | 专注主体一致性:通过将参考图像的 VAE 潜变量沿时间维度注入噪声序列,使模型学会保留输入人物特征,同时响应文本指令 |

| 第二阶段 | 引入音频同步能力:加入音频交叉注意力机制,并采用“预测聚焦策略”,强化语音与面部动作(尤其是嘴唇)的关联 |

这种渐进式学习有效提升了各模态间的协调性。

3. 时间自适应 CFG 推理策略

在推理阶段,HuMo 使用一种时间自适应分类器自由引导(Time-Adaptive CFG)策略:

- 在去噪的不同阶段,动态调整文本、图像、音频的引导权重;

- 早期侧重整体结构与身份保持,后期加强细节与同步精度;

- 实现更稳定、细粒度的多模态控制。

这一策略显著提升了生成结果的可控性与自然度。

实际效果:优于现有方法

在多个基准任务上的测试表明,HuMo 在关键指标上优于当前主流方案:

| 任务 | 对比优势 |

|---|---|

| 主体保持 | 相比 MAGREF、HunyuanCustom 和 Phantom,在身份一致性、文本对齐和视觉质量综合表现更优 |

| 音频-视觉同步 | 在 Lip Sync Error(LSE)和 SyncNet 准确率上接近 OmniHuman-1,具备实用级同步能力 |

| 可编辑性 | 支持基于文本修改服装、表情、姿态等属性,而无需重新提供图像 |

消融实验也验证了:两阶段训练、预测聚焦、时间自适应 CFG 三项设计均对最终性能有显著贡献。

相关文章