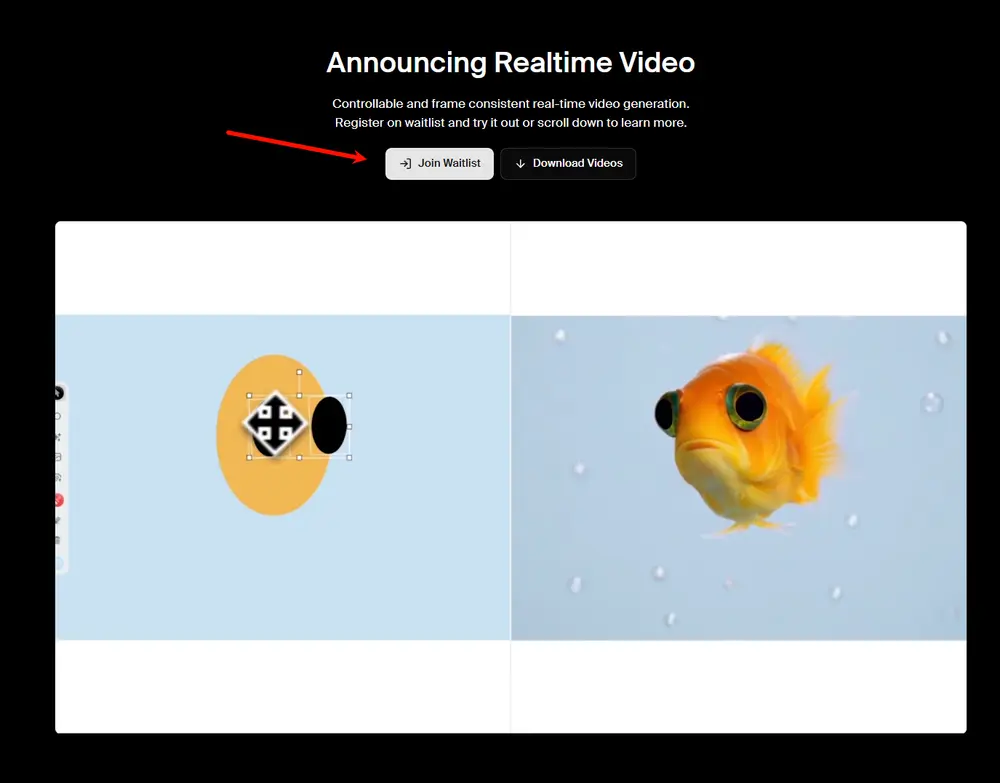

KREA AI 宣布开启其首个实时视频生成模型的测试通道。该模型支持 12+ fps 的生成速度,快于常规播放速度,能够在用户调整输入时提供即时反馈,同时保持帧间运动、身份与风格的高度一致性。

这意味着:你画一笔,画面就动起来;你改一句提示,视频立刻响应——整个过程无需等待渲染,也无需反复提交请求。

目前,该功能已开放等待列表,首批访问权限将逐步发放。

什么是“实时视频生成”?

传统的 AI 视频生成通常是一个“提交-等待-查看”的闭环:输入提示,等待数秒甚至数分钟,得到一段固定视频。修改?只能重新生成。

KREA AI 的新模型打破了这一模式。它的目标不是“生成一段视频”,而是“构建一个可交互的动态系统”。

其核心能力包括:

- 生成速度快于播放:每秒生成 12 帧以上,实现真正的“实时预览”;

- 帧间一致性高:人物身份、场景风格、动作轨迹在时间维度上稳定连贯;

- 多模态输入支持:可通过绘图、文本、摄像头或屏幕流驱动视频生成。

这使得创作过程更接近使用视频游戏或动画软件,而非传统 AI 工具。

技术思路:从“生成器”到“世界模型”

KREA AI 的背后理念源自“世界模型”(World Model)的研究方向——即让系统学习场景如何随时间演变,以及动作如何影响未来状态。

不同于逐帧独立生成的模型,KREA 的方法具备:

- 时间记忆机制:模型保留前序帧的状态信息,用于指导后续帧的生成;

- 动态传播能力:当你在画布上移动一个物体,系统能预测其运动轨迹并持续演化;

- 低延迟反馈循环:输入变化后,视频在毫秒级时间内更新,形成自然的交互节奏。

这种设计让模型不仅能“画出来”,还能“演下去”。

四种交互方式,重新定义创作流程

1. 绘制你的视频(Draw Your Video)

在画布上绘制简单形状或线条,AI 会将其转化为完整的动态场景。例如:

- 画一个圆圈,变成太阳升起;

- 拖动一条曲线,生成飞驰的赛车;

- 调整笔触细节,画面中的建筑随之变形。

整个过程像使用绘图软件一样流畅,但输出是带物理感的动画。

2. 网络摄像头输入(Webcam Streaming)

将你的摄像头画面作为输入源,实时生成风格化视频。你可以:

- 将自己的动作转化为 3D 角色动画;

- 把面部表情映射到卡通形象;

- 将桌面环境重构为赛博城市景观。

适用于虚拟直播、角色绑定、创意表达等场景。

3. 屏幕流输入(Screen Streaming)

直接捕获你的屏幕内容,将 UI 操作、光标移动、时间轴滚动等行为转化为生成式视频。

想象一下:

- 在剪辑软件中拖动时间线,AI 实时生成对应片段;

- 在设计稿上点击按钮,界面自动播放动效;

- 演示产品原型时,所有交互都由 AI 动态渲染。

这为产品设计、教学演示、原型验证提供了全新可能。

4. 文本提示 + 实时调控

除了视觉输入,也支持文本提示驱动。关键在于:

你可以边输入边调整,视频会实时响应变化。

比如将“森林晨光”改为“暴风雨来临”,画面中的光线、云层、植被会逐步过渡,而不是突然切换。

核心优势:最小输入,最大控制

KREA AI 强调“最小输入,最大控制”的设计哲学:

- 一个矩形,可以是建筑、飞船或岛屿;

- 一条线段,可以是道路、河流或光轨;

- 一次手势,可以触发整个场景的演变。

这些原始输入作为“控制把手”,由 AI 解读并扩展为复杂视觉内容。用户不必精确描述每一个细节,而是通过交互不断引导和修正。

这种模式降低了使用门槛,同时提升了创作自由度。

如何体验?

目前,KREA AI 实时视频生成功能正处于限量测试阶段,用户可通过官网注册加入等待列表。官方表示,首批访问权限将从本周开始陆续开放。

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)