开发者 lodestones 近期宣布,基于 FLUX.1-schnell 构建的 8.9 亿参数生成模型 Chroma 已完成全部基础训练,正式开放供开发者与研究者使用。作为完全遵循 Apache 2.0 许可证的开源模型,Chroma 最大特点是“无美学调整、无后训练限制”,以原始、中立的基础模型形态,为后续微调提供灵活起点。

此次发布不仅包含面向实际应用的“发布分支”,还推出探索技术边界的“研究分支”,同时背后投入的 10.5 万 H100 GPU 小时计算量,也确保了模型的数据分布覆盖度与微调易用性。

Chroma 模型的核心定位——“无修饰的基础模型”

要理解 Chroma 的独特性,需先厘清其“基础模型”的本质——与市面上常见的“美学优化模型”不同,它拒绝任何偏向性调整,专注于成为“通用微调起点”,具体定位可从三方面解读:

1. 核心属性:原始、中立,无任何“定向优化”

- 无美学调整:未针对特定风格(如动漫、写实、插画)进行优化,避免模型“偏科”——例如不会因训练数据倾向“写实照片”,而难以生成抽象艺术;

- 无后训练技术:未使用 DPO(直接偏好优化)等技术,这类技术虽能让模型遵循特定审美偏好,但会“压缩变异性”(教模型“什么好、什么坏”),导致创作多样性受限;

- 纯基础能力:专注于“模式覆盖”——通过海量数据学习所有可能的风格、概念、对象分布,就像一块“多功能黏土”,开发者可根据需求塑造成任何形态,而非预先定型的“成品雕塑”。

2. 技术基础:基于 FLUX.1-schnell,8.9 亿参数平衡性能与效率

Chroma 以 FLUX.1-schnell(一款以“生成速度快、细节还原准”著称的模型)为基础框架,参数规模设定为 8.9 亿——这一规模既避免了“小参数模型能力不足”的问题,又不会像“百亿参数模型”那样,对微调设备(如开发者的消费级 GPU)要求过高,兼顾了“性能覆盖度”与“微调易用性”。

3. 开源保障:Apache 2.0 许可证,无任何商用或研究限制

完全遵循 Apache 2.0 许可证意味着:

- 开发者可自由用于商业项目(如开发图像生成工具、定制化内容创作平台),无需支付授权费;

- 可无限制修改、二次分发模型(如基于 Chroma 微调后,将新模型开源或闭源);

- 研究机构可自由用于技术探索(如测试新的微调方法、优化生成效率),无数据或使用范围约束。

模型家族拆解:4 大分支,覆盖“实际应用”与“技术研究”

此次发布的 Chroma 家族分为“发布分支”(面向实际开发)与“研究分支”(面向技术探索),4 个分支各有明确定位,开发者可按需选择:

| 分支名称 | 核心特性 | 适用场景 | 关键优势 |

|---|---|---|---|

| Chroma1-Base(发布分支) | 512x512 基础分辨率,原始基础模型 | 几乎所有创意项目(如海报设计、短视频素材生成);计划进行长期微调后,再针对性训练高分辨率的场景 | 全能性强,微调起点中立,适合需要“全风格覆盖”的开发需求 |

| Chroma1-HD(发布分支) | 基于 Base 微调,支持 1024x1024 高分辨率 | 快速微调、LoRA 训练(如定制品牌风格的高分辨率banner、产品渲染图) | 无需额外训练高分辨率模块,直接输出高清结果,节省微调时间 |

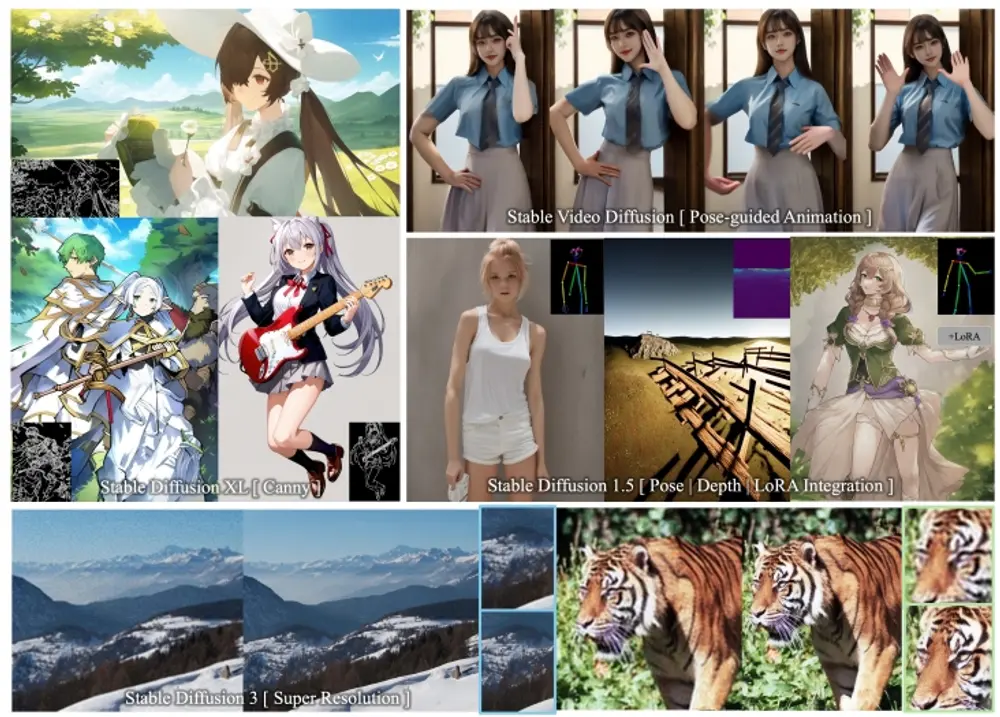

| Chroma1-Flash(研究分支) | 基于 Base 优化,探索“快速推理”能力 | 对生成速度有要求的场景(如实时图像生成工具、低性能设备适配) | 无需 GAN 技术即可提升速度,差量权重可叠加到其他 Chroma 版本,灵活调整加速强度 |

| Chroma1-Radiance(研究分支,开发中) | 像素空间端到端模型,移除 VAE 模块 | 对细节保真度要求极高的场景(如医疗图像生成、高精度产品设计图) | 避免 VAE 压缩导致的细节丢失(如模糊的眼睛、残缺的纹理),计算成本与潜在空间模型一致 |

技术理念:为什么 Chroma 拒绝美学调整与 GAN 技术?

开发者 lodestones 在公告中详细解释了模型设计背后的技术取舍,核心是“追求灵活性、可重复性与细节保真度”,具体可拆解为两点:

1. 拒绝美学调整与 DPO:为了“创作自由”,避免模型“偏科”

- 美学调整的局限:美学优化后的模型(如专门训练的“动漫模型”)虽在特定领域表现好,但会失去多样性——例如难以生成“动漫+写实混合风格”,且二次微调成本高(需覆盖原有定向训练的影响);

- DPO 技术的问题:DPO 通过“偏好数据”让模型贴合特定审美,但本质是“压缩数据分布”——模型会优先生成“被判定为好”的内容,抑制小众风格或创新表达,而 Chroma 希望提供“无偏向的起点”,让开发者自由定义审美方向。

用 lodestones 的比喻来说:“基础模型是一块巨大的黏土,美学模型是已经塑造成特定形状的成品;我提供黏土,是因为开发者可能想捏出雕塑、杯子或玩偶,而不是只能接受我预先做好的样子。”

2. 规避 GAN 技术:为了“稳定可重复”,拒绝“赌博式训练”

GAN(生成对抗网络)是传统提升生成速度与细节的技术,但 lodestones 认为其存在两大核心问题,因此在 Chroma 中规避使用:

- 训练不稳定:GAN 依赖“生成器”与“判别器”的“最小-最大博弈”——若判别器过强,生成器无法学习;若生成器过强,会停止改进,训练过程常处于“剧烈震荡”状态,难以稳定收敛,且结果不可重复(同一参数可能训练出完全不同的模型);

- 模式崩塌:生成器可能发现“单一成功模式”(如某类图像总能骗过判别器),进而反复生成同类内容,丢失数据分布的多样性——例如生成“人物肖像”时,所有人物都呈现相似的五官或表情。

Chroma 的研究分支正是对 GAN 替代方案的探索:Flash 分支尝试“非 GAN 加速”,Radiance 分支则通过“移除 VAE(需配合 GAN 训练的模块)”,从根本上规避 GAN 依赖,同时追求“端到端像素生成”的细节优势。

未来规划:从模型迭代到社区共建,开源生态的长期设想

尽管 Chroma 已完成基础训练,但开发者也提及了后续方向,核心是“依赖社区支持,扩展开源模型版图”:

1. 模型迭代:优先完善研究分支,探索端到端生成

- Chroma1-Radiance 收尾:目前处于开发中的 Radiance 分支(像素空间模型)将继续优化,目标是解决“VAE 伪影”问题——例如图像中模糊的细节、色彩偏差,未来正式发布后,将成为“高精度生成”场景的重要选项;

- Flash 分支优化:计划基于社区反馈,调整 Flash 分支的加速参数,在“速度”与“细节保真度”间找到更优平衡,让低性能设备也能流畅运行。

2. 社区共建:呼吁资源支持,拓展更多开源模型

lodestones 提到,训练 Chroma 已消耗约 10.5 万 H100 GPU 小时(计算成本极高),独自承担其他大模型(如 Qwen、WAN)的开源训练已无可能,因此提出社区共建设想:

- 希望通过社区支持(如资金捐赠、算力贡献),建立“专用训练设备”,为更多模型提供开源训练资源;

- 例如计划探索 Qwen 模型的“参数裁剪”——理论上可裁剪 60 亿参数而不影响性能,若能实现,将大幅降低 Qwen 的微调与推理门槛。

相关文章