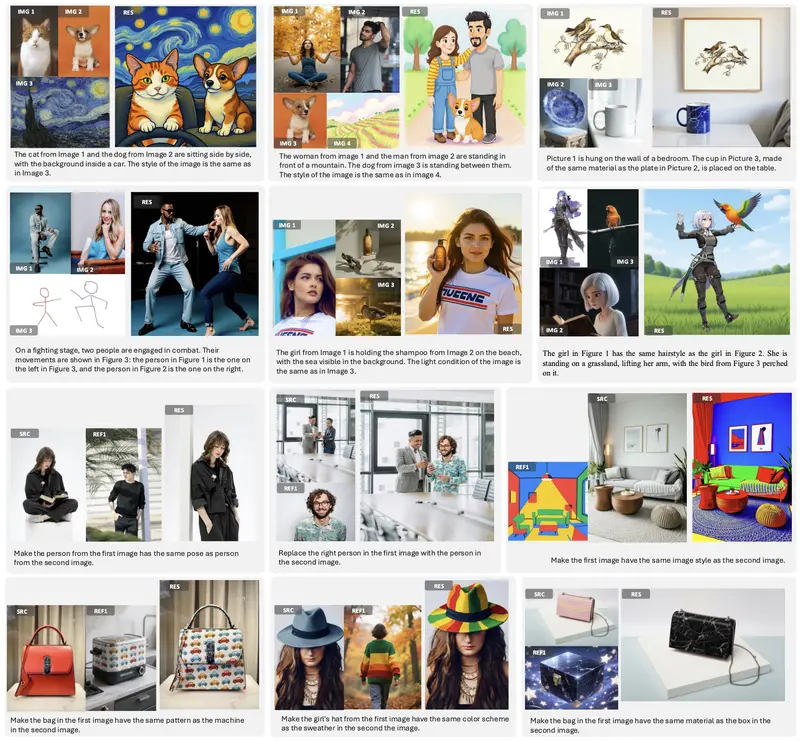

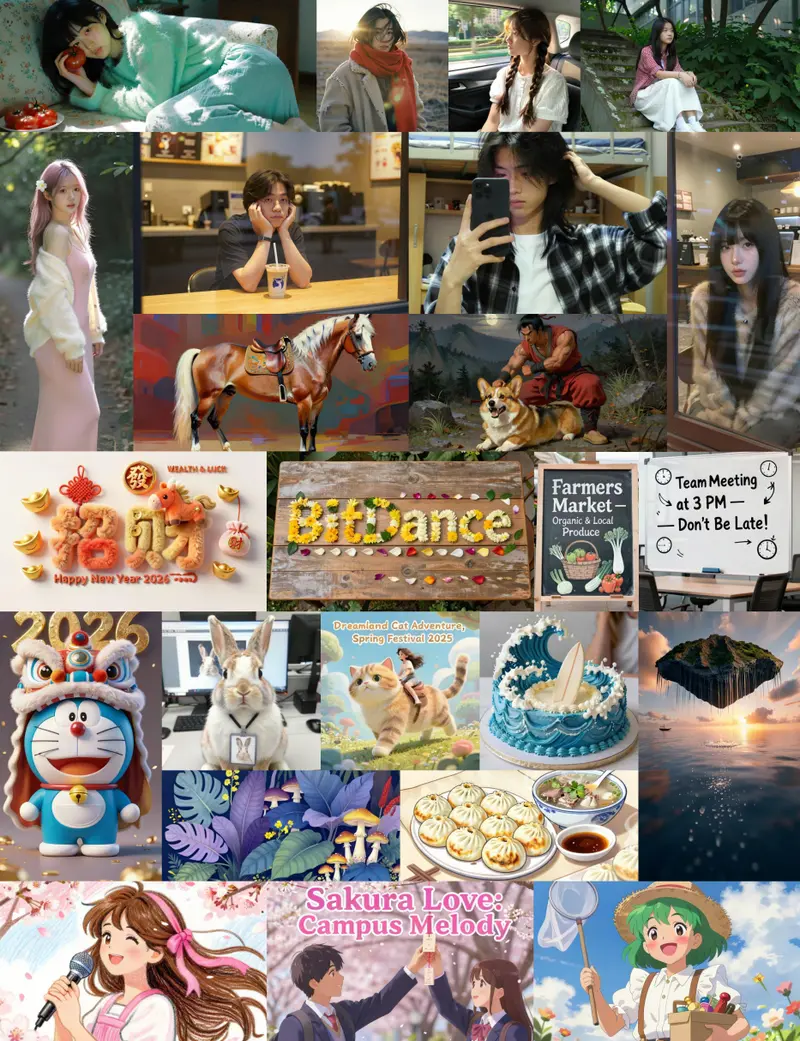

Nunchaku 官方宣布,其基于Qwen-Image的四个量化版本模型已正式上线 Hugging Face和魔塔!这些模型专为高效文本到图像生成而优化,尤其在复杂文本渲染方面表现突出。

- Hugging Face:https://huggingface.co/nunchaku-tech/nunchaku-qwen-image

- 魔塔:https://www.modelscope.cn/models/nunchaku-tech/nunchaku-qwen-image

目前支持通过 Diffusers 进行推理,ComfyUI 集成、LoRA 微调支持以及 CPU 卸载功能正在开发中,即将推出。

模型简介

| 项目 | 说明 |

|---|---|

| 开发团队 | Nunchaku |

| 模型类型 | 文本到图像生成(Text-to-Image) |

| 基础模型 | Qwen-Image |

| 量化方法 | SVDQuant |

| 许可证 | Apache-2.0 |

| 适用场景 | 高质量图像生成,尤其擅长包含文字、标志、复杂排版的图像 |

该系列模型通过 SVDQuant 技术进行量化,在将模型压缩至 4-bit 的同时,最大程度保留了原始性能,实现了高保真生成与推理效率的平衡。

模型文件说明

Nunchaku 提供了四种量化配置,适配不同硬件平台:

| 文件名 | 量化类型 | 秩(Rank) | 适用GPU | 特点 |

|---|---|---|---|---|

svdq-int4_r32-qwen-image.safetensors | INT4 | 32 | 非 Blackwell 架构(如 30/40 系列) | 速度快,资源占用低 |

svdq-int4_r128-qwen-image.safetensors | INT4 | 128 | 非 Blackwell 架构 | 质量更高,速度较慢 |

svdq-fp4_r32-qwen-image.safetensors | NVFP4 | 32 | Blackwell 架构(50 系列) | 专为新架构优化 |

svdq-fp4_r128-qwen-image.safetensors | NVFP4 | 128 | Blackwell 架构 | 高质量输出,性能开销更大 |

✅ 提示:秩越高,图像细节和文本准确性越好;秩越低,推理速度越快。可根据硬件条件和生成需求选择合适版本。

🛠 使用方法

1、通过 Diffusers 快速体验

项目提供示例脚本 qwen-image.py,可直接集成到 Hugging Face Diffusers 流程中使用。

2、ComfyUI 支持即将上线

开发者已确认,ComfyUI 节点支持正在开发中,未来将支持可视化工作流调用,便于与 ControlNet、LoRA 等插件协同使用。

其他功能预告

- LoRA 微调支持

- CPU 卸载推理(适用于低显存设备)

- 更多优化脚本与部署指南

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...