图像到视频(Image-to-Video, I2V)模型近年来取得了长足进展,能够根据一张静态图像和文本提示生成动态视频,实现更强的视觉控制。然而,研究发现,这类模型往往生成的视频过于静态,动态性远不如其文本到视频(T2V)版本。

韩国科学技术院(KAIST)的研究人员深入分析了这一问题,并提出了一种简单但有效的新方法:自适应低通引导(Adaptive Low-Pass Guidance, ALG)。该方法在不修改模型结构或重新训练的前提下,显著提升了视频的动态性,同时保持了图像质量和文本对齐。

问题:I2V 模型为何生成的视频太“静态”?

当前主流的 I2V 模型大多基于 T2V 架构适配而来。虽然这些模型在视觉控制方面表现优异,但它们生成的视频常常缺乏动态感,即使提示词中包含运动描述。

研究人员通过对比 T2V 和 I2V 模型的生成结果发现:

- 动态度显著下降:例如在 Wan 2.1 模型中,I2V 的动态度下降了 18.6%。

- 其他质量指标稳定:如图像质量、文本一致性等未受影响。

进一步分析表明,这种“动态抑制”主要来源于输入图像中过早暴露的高频细节(如纹理、边缘等),导致模型在生成早期就“锁定”静态特征,形成一种“捷径轨迹”,阻碍了后续的动态演变。

方法:自适应低通引导(ALG)

为解决这一问题,KAIST 提出了一种名为 ALG(Adaptive Low-Pass Guidance) 的采样策略:

- 核心思想:在去噪过程的早期阶段对输入图像进行低通滤波,减少高频细节的干扰;

- 逐步恢复:随着采样步骤推进,逐步降低滤波强度,恢复图像细节;

- 目标:让模型在生成初期更关注整体结构和运动趋势,后期再还原精细纹理。

这种方法无需对模型进行任何修改或重新训练,是一种即插即用的增强方案。

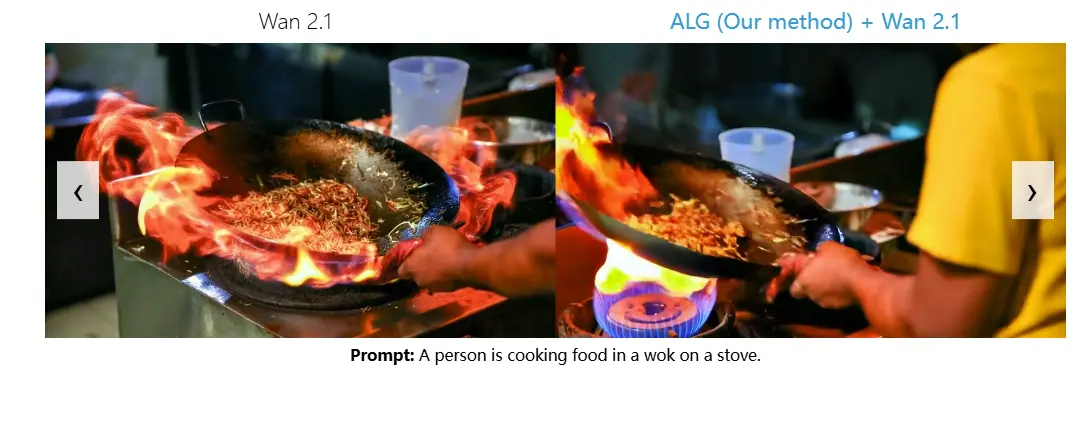

示例对比

以一张静态的飞机图片和提示“飞机在天空中飞行”为例:

- 传统 I2V 模型:生成的视频中飞机几乎静止。

- 使用 ALG 后:生成的视频中飞机在天空中动态飞行,视觉效果更自然,同时仍与原始图像高度一致。

核心优势

✅ 增强动态性

- 在多个 I2V 模型上测试,动态度平均提升 36%:

- CogVideoX:64.2% → 82.5%

- Wan 2.1:28.9% → 41.5%

- HunyuanVideo:88.2% → 92.7%

- LTX-Video:12.6% → 21.1%

✅ 保持图像质量

- 图像主体和背景一致性与原始方法相当。

✅ 保持文本对齐

- 视频内容与提示词高度匹配,无语义偏移。

✅ 无需额外训练

- ALG 是一种采样阶段的优化方法,适用于任何 I2V 模型,无需重新训练。

适用模型广泛

ALG 已在多个主流 I2V 模型上验证其效果,包括:

- CogVideoX

- Wan 2.1

- HunyuanVideo

- LTX-Video

这些模型在使用 ALG 后,均表现出显著的动态性提升,证明了该方法的广泛适用性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...