近年来,随着基于变换器(Transformer)的扩散模型向数十亿参数扩展,文本到视频(Text-to-Video, T2V)生成技术取得了显著进展。尽管当前模型已能生成高质量视频内容,但它们通常只能离线生成短视频片段,限制了在交互式和实时应用中的部署。

为了解决这一问题,加州大学伯克利分校与 Meta 的研究团队提出了 StreamDiT —— 一种支持流式视频生成的新型扩散模型。它通过引入流匹配训练框架和高效架构设计,实现了高质量、低延迟的实时视频生成,适用于从直播创作到虚拟现实等多种场景。

核心创新点

✅ 流式训练机制

StreamDiT 引入了“移动缓冲区”概念,并结合**流匹配(Flow Matching)**方法,实现连续视频帧的生成。该机制允许模型同时处理不同噪声水平的帧,提升内容一致性和视觉质量。

🔀 混合训练方案

通过融合多种帧分割策略进行训练,增强模型对不同场景的适应能力,避免过拟合,提高泛化性。

🚀 多步蒸馏方法

为了实现实时性能,研究人员开发了一种定制多步蒸馏流程,将采样步骤从 128 步压缩至仅 8 步,大幅提升了推理速度,同时保持生成质量。

⏱ 时间可变 DiT 架构

基于 adaLN DiT 结构,结合变化的时间嵌入和窗口注意力机制,有效建模时间动态,兼顾效率与质量。

主要功能

| 功能 | 描述 |

|---|---|

| 实时视频生成 | 单 GPU 上以 16 FPS 生成 512p 视频流,满足实时需求 |

| 流式视频生成 | 支持无限长度视频生成,无需等待整段完成 |

| 互动视频生成 | 用户可通过更新文本提示动态控制视频内容 |

| 视频到视频转换 | 支持输入视频编辑,在去噪过程中保持时间一致性 |

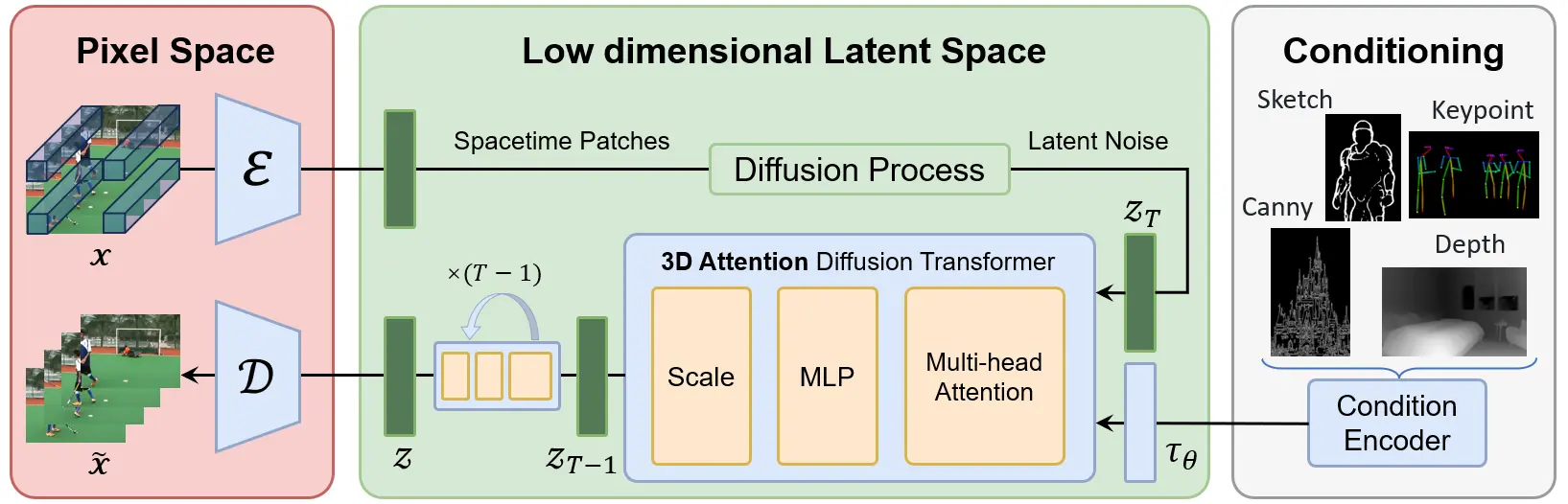

技术架构概览

🔄 流匹配与移动缓冲区

StreamDiT 采用基于流匹配的训练方式,维护一个移动帧缓冲区,使得模型能够持续生成新的视频帧,同时保持帧间的平滑过渡。

🧬 模型架构

- 基于 adaLN DiT 构建,支持自适应层归一化;

- 使用时间变化的嵌入机制,捕捉视频的时间特性;

- 引入窗口注意力机制,降低计算复杂度,提升实时表现。

🎞 流式生成过程

支持多种生成模式,统一处理不同分割方案和块大小,确保在各种实时场景中均能维持一致的高质量输出。

交互式视频生成

StreamDiT 的推理流水线专为低延迟响应和用户交互而设计:

- 独立进程运行:DiT 去噪器、TAE 解码器和文本编码器分别运行,降低整体延迟;

- 实时回调机制:持续监听用户新提示,即时更新文本嵌入;

- 跨注意力引导:使用最新嵌入调整生成方向,实现动态内容修改。

这种设计使用户能够通过实时输入文本指令,边看边改,极大增强了创作自由度和沉浸感。

性能评估结果

| 评估维度 | 表现 |

|---|---|

| VBench 质量指标 | 在主体一致性、背景一致性、运动自然性等方面优于 ReuseDiffuse 和 FIFO-Diffusion |

| 人工评估 | 整体质量、帧一致性、运动完整性和自然性均领先 |

| 实时性能 | 在单个 H100 GPU 上实现 16 FPS 的 512p 分辨率视频流生成 |

应用场景展望

🎥 实时流式生成

适用于直播平台、在线教育、虚拟会议等需要持续内容输出的场景。

⚡ 交互式视频编辑

用户可以随时更改风格或内容,立即看到效果,非常适合创意工作者和内容创作者。

🎮 游戏与虚拟现实

为游戏环境、VR 场景提供实时生成的动态视频背景,增强沉浸体验;也可用于头像系统,实现个性化虚拟形象。

🤖 机器人仿真与控制

StreamDiT 可用于构建实时世界模拟环境,并支持扩散策略生成连续动作序列,推动具身智能的发展。

相关文章